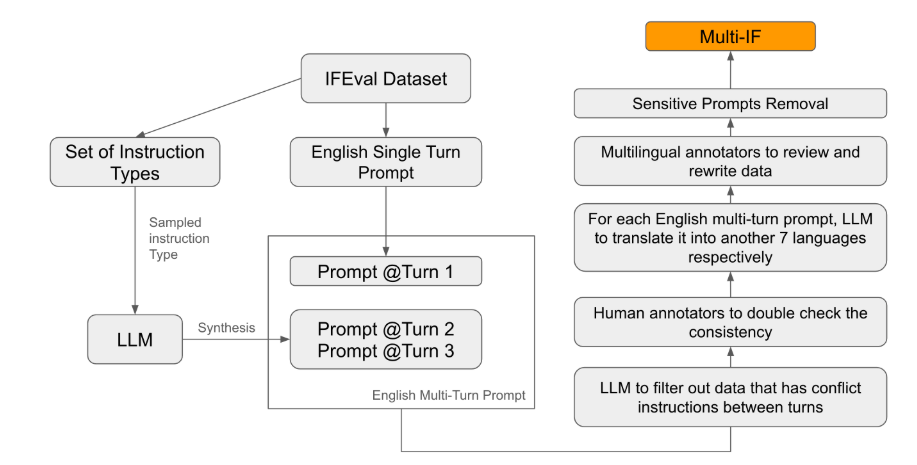

Metaは最近、大規模言語モデル(LLM)の複数回会話と多言語環境における指示遵守能力を評価することを目的とした、Multi-IFという全く新しいベンチマークを発表しました。このベンチマークは8つの言語を網羅し、4501個の3ターン会話タスクを含んでおり、複雑な複数回会話と多言語シナリオにおける現在のモデルのパフォーマンスに焦点を当てています。

既存の評価基準のほとんどは、単一ターン会話と単一言語タスクに集中しており、モデルの実際のアプリケーションにおけるパフォーマンスを包括的に反映することが困難です。Multi-IFの発表はまさにこのギャップを埋めるために行われました。研究チームは、単一ターンの指示を複数ターンの指示に拡張することで複雑な会話シナリオを作成し、各ターンの指示が論理的に一貫性があり、段階的に進んでいることを保証しました。さらに、データセットは自動翻訳と手動校正などの手順を通じて多言語サポートを実現しています。

実験の結果、ほとんどのLLMは複数回会話におけるパフォーマンスが著しく低下することが示されました。o1-previewモデルを例にとると、最初のターンの平均精度は87.7%ですが、3ターン目には70.7%に低下します。特に、ヒンディー語、ロシア語、中国語などの非ラテン文字の言語では、モデルのパフォーマンスは英語よりも一般的に低く、多言語タスクにおける限界を示しています。

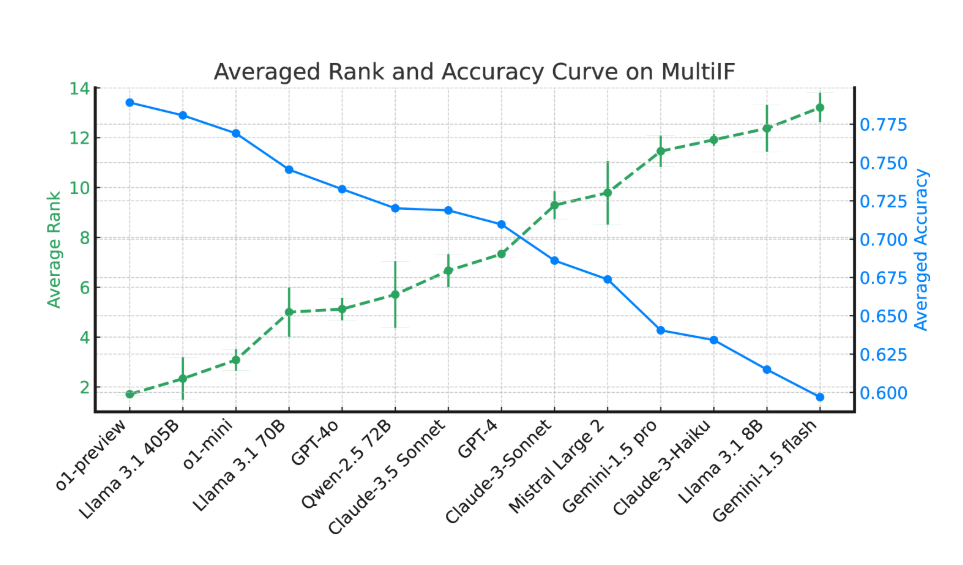

14種類の最先端の言語モデルを評価した結果、o1-previewとLlama3.1405Bが最高の性能を示し、3ターン指示の平均精度はそれぞれ78.9%と78.1%でした。しかし、複数回会話では、すべてのモデルの指示遵守能力が全体的に低下しており、複雑なタスクにおけるモデルの課題を反映しています。研究チームは、複数回会話におけるモデルの指示忘れ現象を定量化するために「指示忘れ率」(IFR)も導入し、その結果、高性能モデルはこの点で比較的良好なパフォーマンスを示しました。

Multi-IFの発表は、研究者にとって挑戦的なベンチマークを提供し、LLMの世界的な多言語アプリケーションの発展を促進します。このベンチマークの発表は、現在のモデルの複数回、多言語タスクにおける不足点を明らかにするだけでなく、将来の改善のための明確な方向性を提供します。

論文:https://arxiv.org/html/2410.15553v2

要点:

🌍 Multi-IFベンチマークは8つの言語を網羅し、4501個の3ターン会話タスクを含み、複雑なシナリオにおけるLLMのパフォーマンスを評価します。

📉 実験によると、多くのLLMは複数回会話における精度は著しく低下し、特に非ラテン文字の言語では性能が弱いです。

🔍 o1-previewとLlama3.1405Bモデルが最高の性能を示し、3ターン指示の平均精度はそれぞれ78.9%と78.1%です。