人工知能の急速な発展に伴い、大規模モデルの知能化レベルは向上していますが、同時に推論システムの効率性に対する課題も顕著になっています。高い推論負荷への対応、推論コストの削減、応答時間の短縮は、業界共通の重要な課題となっています。

Kimi社は清華大学MADSys研究所と共同で、KVCacheベースのMooncake推論システム設計案を発表しました。この案は2024年6月に正式にリリースされました。

Mooncake推論システムは、革新的なPD分離アーキテクチャとストレージ中心の理念により、推論のスループットを大幅に向上させ、業界から広く注目を集めています。この技術フレームワークの応用と普及をさらに推進するため、Kimi社と清華大学MADSys研究所は、9#AISoft、阿里雲、Huawei Storageなどの複数企業と協力して、オープンソースプロジェクトMooncakeを立ち上げました。11月28日、Mooncakeの技術フレームワークがGitHubプラットフォームで正式に公開されました。

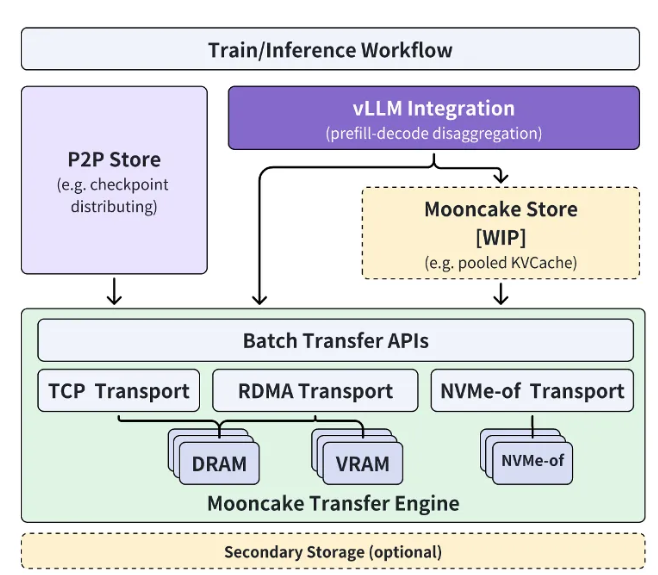

Mooncakeオープンソースプロジェクトは、超大規模KVCacheキャッシュプールを中心に展開され、段階的な方法で高性能なKVCache多階層キャッシュMooncake Storeを順次オープンソース化することを目指しています。同時に、このプロジェクトは様々な推論エンジンと基盤となるストレージ、転送リソースとの互換性を備えています。

現在、転送エンジンTransfer Engineの一部がGitHubでグローバルにオープンソース化されています。Mooncakeプロジェクトの最終目標は大規模モデル時代に、新しい高性能メモリセマンティックストレージの標準インターフェースを構築し、関連する参考実装を提供することです。

Kimi社のエンジニアリング担当副社長である許欣然氏は次のように述べています。「清華大学MADSys研究所との緊密な協力により、分離型の大規模モデル推論アーキテクチャMooncakeを共同で開発し、推論リソースの最適化を実現しました。

Mooncakeはユーザーエクスペリエンスの向上だけでなく、コスト削減にもつながり、長文処理や高並列処理のニーズに効果的なソリューションを提供します。」 氏は、より多くの企業や研究機関がMooncakeプロジェクトに参加し、より効率的なモデル推論システムアーキテクチャを共同で探求し、AIアシスタントなど大規模モデル技術に基づく製品がより多くの人々に恩恵をもたらすことを期待しています。

プロジェクト入口:https://github.com/kvcache-ai/Mooncake

要点:

🌟 Kimi社と清華大学が共同でMooncake推論システムを発表、AI推論効率の向上を実現。

🔧 MooncakeプロジェクトがGitHubでオープンソース化、高性能メモリセマンティックストレージ標準インターフェースの構築を目指す。

🤝 より多くの企業や研究機関の参加を期待、AI技術の進歩を共同で推進。