大規模言語モデル(LLM)が自然言語処理(NLP)分野で広く利用されるようになり、テキスト生成や言語理解などのタスクの効率が大幅に向上しました。しかし、アラビア語は複雑な語形変化、多様な方言、そして豊かな文化的背景を持つため、言語モデルの応用において依然として過小評価されています。

多くの最先端言語モデルは英語を対象としているため、アラビア語関連のモデルは、規模が大きすぎて計算リソースを大量に消費するか、文化的なニュアンスを十分に反映できないかのどちらかです。JaisやAceGPTなど、70億パラメーターを超えるモデルは強力な能力を備えていますが、リソース消費が大きいため、幅広い用途への展開が困難です。そのため、効率と性能の両方を兼ね備えたアラビア語モデルが強く求められていました。

この問題を解決するために、Stability AIはアラビア語Stable LM1.6Bモデルを発表しました。これは基礎版とチャット版があり、アラビア語中心のLLMとして、その規模を考慮すると、文化的な整合性と言語理解のベンチマークテストで優れた成績を収めています。70億パラメーターを超える大規模モデルとは異なり、アラビア語Stable LM1.6Bは良好な性能を維持しながら、計算リソースの消費を削減しています。

このモデルは1000億を超えるアラビア語テキストトークンで微調整されており、現代標準アラビア語と様々な方言を強力に表現しています。特にチャット版モデルは文化的なベンチマークテストで優れた結果を示し、高い精度とコンテキスト理解能力を備えています。

Stability AIのこの新しいモデルは、現実世界の指示データセットと合成された対話生成を融合することで、文化的に繊細なクエリを効果的に処理し、同時に様々なNLPタスクにおいて幅広い適用性を維持しています。

技術的な側面では、アラビア語Stable LM1.6Bはアラビア語の特徴を考慮した高度な事前学習アーキテクチャを採用しています。主な設計要素は以下の通りです。

トークン最適化:Arcade100kトークナイザーを使用し、トークンの粒度と語彙規模のバランスを取り、アラビア語テキストにおける過剰なトークン化の問題を軽減しています。

多様なデータセットの網羅性:ニュース記事、ウェブコンテンツ、電子書籍など、幅広いデータソースからトレーニングデータを取得し、文学アラビア語と口語アラビア語の両方を網羅的に表現しています。

指示微調整:合成された指示と応答のペアを含むデータセット(言い換え対話や多肢選択問題など)により、文化特異的なタスクの処理能力を高めています。

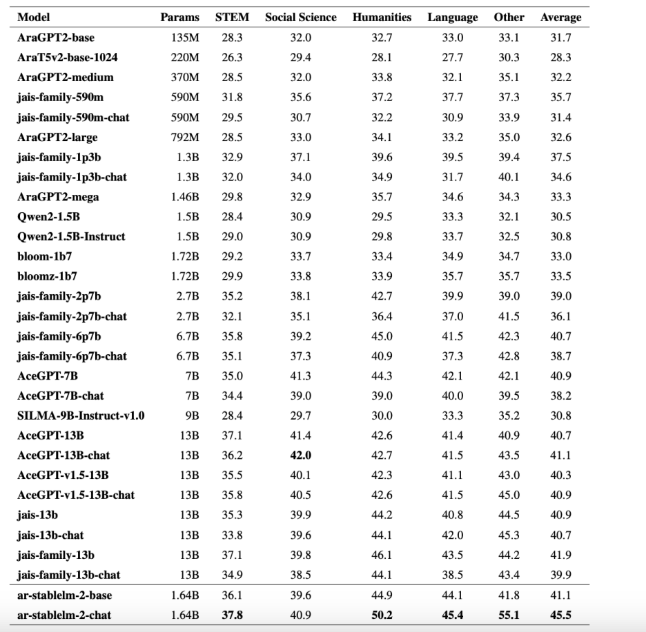

アラビア語Stable LM1.6Bモデルは、アラビア語NLP分野における重要な進歩を示しており、ArabicMMLUやCIDAR-MCQなどのベンチマークテストで強力な結果を達成しています。例えば、チャット版はArabicMMLUベンチマークテストで45.5%というスコアを獲得し、7億から130億パラメーターの他のモデルを上回っています。CIDAR-MCQベンチマークテストでも、チャットモデルは46%という非常に高いスコアを獲得しています。

現実データと合成データの組み合わせにより、このモデルは拡張性を維持しながら実用性を確保し、様々なNLPアプリケーションに適用できます。アラビア語Stable LM1.6Bの発表は、アラビア語NLPにおける計算効率と文化的な整合性の問題を解決するだけでなく、アラビア語自然言語処理タスクのための信頼できるツールを提供します。

チャットモデル:https://huggingface.co/stabilityai/ar-stablelm-2-chat

基礎モデル:https://huggingface.co/stabilityai/ar-stablelm-2-base

論文:https://arxiv.org/abs/2412.04277

要点:

🌟 アラビア語Stable LM1.6Bモデルは、アラビア語NLPにおける計算効率と文化的な整合性の問題を解決することを目的としています。

📈 このモデルは複数のベンチマークテストで優れた成績を収め、パラメーター数の多い多くのモデルを上回っています。

🌐 Stability AIは現実データと合成データの融合により、アラビア語モデルの実用性と拡張性を両立させています。