英偉達はGB200とB200発売からわずか6ヶ月後、新型GPUであるGB300とB300を発表しました。一見すると小さなアップグレードのように見えますが、実際には大きな変革を意味しており、特に推論モデルのパフォーマンスの大幅な向上は、業界全体に大きな影響を与えるでしょう。

B300/GB300:推論性能の飛躍的向上

B300 GPUはTSMCの4Nプロセスノードを採用し、演算チップ向けに最適化された設計となっています。これにより、B300のFLOPS性能はB200と比べて50%向上しました。性能向上の一部はTDPの増加によるもので、GB300とB300 HGXのTDPはそれぞれ1.4KWと1.2KWに達します(GB200とB200はそれぞれ1.2KWと1KW)。残りの性能向上は、アーキテクチャの強化とシステムレベルの最適化(例:CPUとGPU間の動的電力配分)によるものです。

FLOPSの向上に加え、メモリも12-Hi HBM3Eにアップグレードされ、GPUあたりのHBM容量は288GBに増加しました。ただし、ピン速度は変更されていないため、GPUあたりのメモリ帯域幅は依然として8TB/sです。注目すべきは、サムスンがGB200またはGB300のサプライチェーンに参加していないことです。

さらに、英偉達はその価格設定にも調整を加えました。これはBlackwell製品の利益率に一定の影響を与えるでしょうが、より重要なのは、B300/GB300の性能向上は主に推論モデルにおいて顕著に現れるということです。

推論モデル向けに最適化

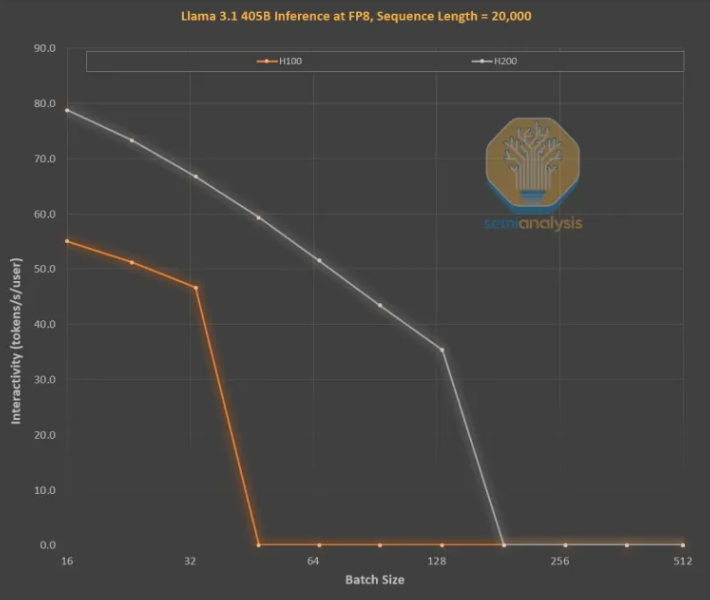

メモリの改良は、OpenAI O3スタイルのLLM推論トレーニングにとって非常に重要です。長いシーケンスはKVキャッシュを増やし、重要なバッチサイズと遅延を制限するためです。H100からH200へのアップグレード(主にメモリの増加)により、以下の2つの改善が見られました。

より高いメモリ帯域幅(H200は4.8TB/s、H100は3.35TB/s)により、比較可能なすべてのバッチサイズのインタラクティブ性が全体的に43%向上しました。

H200はH100よりも大きなバッチサイズを実行するため、1秒間に生成されるトークン数は3倍になり、コストは約3分の1に削減されました。この違いは主に、KVキャッシュが総バッチサイズを制限しているためです。

より大きなメモリ容量は、パフォーマンスの大幅な向上に繋がります。2つのGPU間の性能と経済的な違いは、そのパラメータ仕様が示すよりもはるかに大きいです。

推論モデルのユーザーエクスペリエンスは、リクエストとレスポンスの間に顕著な待ち時間があるため、低下する可能性があります。推論時間を大幅に短縮できれば、ユーザーの利用意欲と支払い意欲を高めることができます。

ハードウェアが中間世代のメモリアップグレードによって3倍の性能向上を実現したことは驚くべきことであり、ムーアの法則、黄氏法則、またはこれまでに目撃した他のいかなるハードウェア改良速度をもはるかに凌駕しています。

最も強力なモデルは、性能がやや劣るモデルよりもはるかに高い価格設定を行うことができます。最先端モデルの粗利益は70%を超える一方、オープンソースの競合である後発モデルの利益率は20%を下回ります。推論モデルは、単一の連鎖思考を行う必要はありません。検索機能を拡張して、O1ProとO3で行われたようにパフォーマンスを向上させることができます。これにより、よりスマートなモデルがより多くの問題を解決し、GPUごとに多くの収益を生み出すことができます。

もちろん、英偉達だけがメモリ容量を増やすことができるわけではありません。ASICもこれを行うことができます。実際、AMDは、MI300X、MI325X、MI350Xのメモリ容量が通常英偉達よりも高く、それぞれ192GB、256GB、288GBであるため、より有利な立場にある可能性があります。しかし、英偉達にはNVLinkという秘密兵器があります。

NVL72の重要性は、72個のGPUが同じ問題で協力して作業し、メモリを共有し、遅延が非常に低いことです。世界には、完全相互接続の交換能力を持つ他のアクセラレータはありません。

英偉達のGB200 NVL72とGB300 NVL72は、多くの重要な機能を実現するために不可欠です。

より高いインタラクティブ性により、思考連鎖ごとの遅延が低減されます。

72個のGPUはKVキャッシュを分散させることができるため、より長い思考連鎖(知能の向上)を実現できます。

バッチサイズのスケーラビリティは、一般的な8GPUサーバーよりもはるかに優れており、コストを削減できます。

同じ問題に取り組んで精度とモデルのパフォーマンスを向上させるサンプル数が多くなります。

したがって、NVL72のトークノミクスは10倍以上向上し、特に長い推論連鎖において顕著です。KVキャッシュがメモリを占有することは経済効果にとって致命的ですが、NVL72は推論の長さを10万トークン以上に拡張する唯一の方法です。

GB300:サプライチェーンの再構築

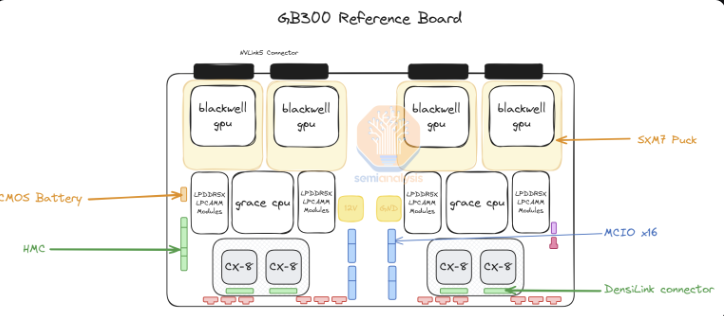

GB300について、英偉達はそのサプライチェーンと内容に大きな変化をもたらしました。GB200の場合、英偉達はBiancaボード全体(Blackwell GPU、Grace CPU、512GB LPDDR5X、VRMコンポーネントを含む)、交換トレイ、銅製バックプレートを提供していました。

GB300の場合、英偉達は「SXM Puck」モジュール上のB300、BGAパッケージのGrace CPU、およびHMCのみを提供します。HMCは、GB200のAspeedではなく、アメリカのスタートアップ企業であるAxiadoから供給されます。エンドカスタマーは、計算ボード上の残りのコンポーネントを直接調達するようになり、セカンダリメモリは、はんだ付けされたLPDDR5Xではなく、LPCAMMモジュールを使用します。これらのモジュールの主要サプライヤーはMicronになります。交換トレイと銅製バックプレートは変更されず、英偉達はこれらのコンポーネントを完全に供給します。

SXM Puckへの移行により、より多くのOEMとODMが計算トレイに参加する機会が得られます。以前は緯創と富士康だけがBianca計算ボードを製造していましたが、現在ではより多くのOEMとODMが参加できます。緯創は、Biancaボードのシェアを失ったため、ODM形式で最大の敗者です。富士康にとって、Biancaボードシェアの損失は、SXM PuckとSXM Puckソケットの独占メーカーであるという事実によって相殺されます。英偉達はPuckとソケットに他のサプライヤーを導入しようとしていますが、まだ他の注文は出ていません。

もう1つの大きな変化はVRMコンポーネントです。SXM PuckにはいくつかのVRMコンポーネントがありますが、ほとんどのオンボードVRMコンポーネントは、ハイパースケール企業/OEMがVRMサプライヤーから直接調達するようになります。ビジネスモデルの変化により、Monolithic Power Systemsは市場シェアを失うことになります。

英偉達はGB300プラットフォームで800G ConnectX-8 NICも提供しており、InfiniBandとイーサネット上で2倍の拡張帯域幅を提供します。英偉達は以前、上市時期の複雑さとBiancaボードでのPCIe Gen6の有効化の放棄のために、GB200のConnectX-8を取り消していました。

ConnectX-8はConnectX-7と比べて大幅に改良されています。帯域幅が2倍になっただけでなく、PCIeレーンも32レーンから48レーンに増加し、風冷式MGX B300Aなどの独自のアーキテクチャを実現しています。さらに、ConnectX-8はSpectrum-X機能を備えていますが、以前の400G製品では、Spectrum-Xには効率の低いBluefield 3 DPUが必要でした。

GB300がハイパースケール企業に与える影響

GB200とGB300の遅延がハイパースケール企業に与える影響は、第3四半期から始まる多くの注文が、英偉達の新しい高価なGPUに移行されることを意味します。先週の時点で、すべてのハイパースケール企業がGB300を採用することを決定しました。その理由は、GB300のパフォーマンスが高いことだけでなく、自らの運命を制御できるようになったことにもあります。

上市時期の課題と、ラック、冷却、電源供給/密度の大幅な変更により、ハイパースケール企業はサーバーレベルでGB200に多くの変更を加えることができません。これにより、MetaはBroadcomと英偉達からの複数ソースNICからの希望を放棄し、英偉達に完全に依存するようになりました。Googleなどの他のケースでは、内部NICを放棄し、英偉達のみを使用するようになりました。

CPUからネットワーク、ネジ、金属板に至るまで、すべてのコストを最適化することに慣れているハイパースケール企業の何千人もの組織にとって、これは信じられないことです。

最も衝撃的な例はAmazonです。彼らは非常に理想的ではない構成を選択しており、TCOはリファレンスデザインよりも悪くなっています。Amazonは、PCIeスイッチと効率の低い200G弾性光ファイバアダプタNICを使用しているため、風冷が必要であり、Meta、Google、Microsoft、Oracle、X.AI、CoreweaveのようにNVL72ラックを展開することはできません。内部NICを使用しているため、AmazonはNVL36を使用する必要があり、より高価なバックプレーンとスイッチコンポーネントのために、GPUあたりのコストも高くなっています。要約すると、カスタマイズを中心とした制約により、Amazonの構成は理想的ではありません。

GB300が登場したことで、ハイパースケール企業はマザーボード、冷却など、より多くのコンポーネントをカスタマイズできるようになりました。これにより、Amazonは、水冷を採用し、以前は風冷だったコンポーネント(Astera Labs PCIeスイッチなど)を統合した独自の特注マザーボードを構築することが可能になります。より多くのコンポーネントが水冷を採用し、25年第3四半期にK2V6400G NICでHVMがついに実現されたことで、AmazonはNVL72アーキテクチャに戻り、TCOを大幅に向上させることができます。

ただし、ハイパースケール企業はより多くの内容を設計、検証、確認する必要があります。これが最大の欠点です。これは、ハイパースケール企業がこれまでに設計する必要があった中で最も複雑なプラットフォーム(GoogleのTPUシステムを除く)になりかねません。一部のハイパースケール企業は迅速に設計できますが、他のチームは速度が遅いため遅れをとります。市場レポートにはキャンセル状況がありますが、設計速度が遅いことから、MicrosoftはGB300の展開が最も遅い企業の1つであると考えており、第4四半期にもいくつかのGB200を購入しています。

コンポーネントが英偉達の利益の積み重ねから抽出され、ODMに移行されるため、顧客が支払う総価格には大きな違いがあります。ODMの収益は影響を受け、最も重要なのは、英偉達の粗利益も年間を通して変化することです。