2024年12月26日、中国の人工知能スタートアップ企業DeepSeekは、最新の超大型モデルDeepSeek-V3を発表しました。このモデルは、オープンソース技術と革新的な挑戦により、大手AIサプライヤーをリードしています。

DeepSeek-V3は6710億個のパラメータを備え、特定のパラメータを活性化させる専門家混合アーキテクチャ(mixture-of-experts architecture)を採用することで、与えられたタスクを正確かつ効率的に処理します。DeepSeekが提供したベンチマークテストによると、この新しいモデルはMetaのLlama 3.1-405Bを含む主要なオープンソースモデルを上回り、AnthropicやOpenAIのクローズドソースモデルにも匹敵する性能を示しています。

DeepSeek-V3の発表は、オープンソースAIとクローズドソースAIの差がさらに縮まったことを示しています。元々は中国のクオンツヘッジファンドHigh-Flyer Capital Managementの分社であるDeepSeekは、これらの進歩が人工汎用知能(AGI)への道を切り開くと期待しています。AGIとは、人間が実行できるあらゆる知的タスクを理解または学習できるモデルのことです。

DeepSeek-V3の主な特徴は以下の通りです。

前身であるDeepSeek-V2と同様に、新しいモデルはマルチヘッド潜在的アテンション(MLA)とDeepSeekMoEの基本アーキテクチャに基づいており、効率的なトレーニングと推論を保証します。

同社は、補助的な損失のない負荷分散戦略とマルチトークン予測(MTP)という2つの革新的な技術も発表しました。MTPにより、モデルは複数の将来のトークンを同時に予測できるようになり、トレーニング効率が向上し、モデルの動作速度が3倍に向上し、毎秒60トークンを生成できるようになりました。

事前トレーニング段階では、DeepSeek-V3は14.8兆個の高品質で多様なトークンをトレーニングし、2段階のコンテキスト長の拡張を行い、最終的に教師あり微調整(SFT)と強化学習(RL)による事後トレーニングを実施して、モデルを人間の好みと一致させ、潜在能力をさらに引き出しました。

トレーニング段階では、DeepSeekはFP8混合精度トレーニングフレームワークやDualPipeアルゴリズムによるパイプライン並列処理など、さまざまなハードウェアとアルゴリズムの最適化を採用し、トレーニングコストを削減しました。DeepSeek-V3のトレーニング全体は、2788K H800 GPU時間、または約557万ドルで完了したと主張しており、通常の大規模言語モデルの事前トレーニングに使用される数億ドルをはるかに下回っています。

DeepSeek-V3は、市場で最も強力なオープンソースモデルとなっています。同社が行った複数のベンチマークテストでは、英語に焦点を当てたSimpleQAとFRAMESを除くほとんどのベンチマークテストでクローズドソースのGPT-4oを上回りました。これらの2つのテストでは、OpenAIモデルがそれぞれ38.2点と80.5点でリードしました(DeepSeek-V3はそれぞれ24.9点と73.3点)。DeepSeek-V3は、特に中国語と数学のベンチマークテストで優れた性能を示し、Math-500テストでは90.2点を獲得し、Qwenの80点を上回りました。

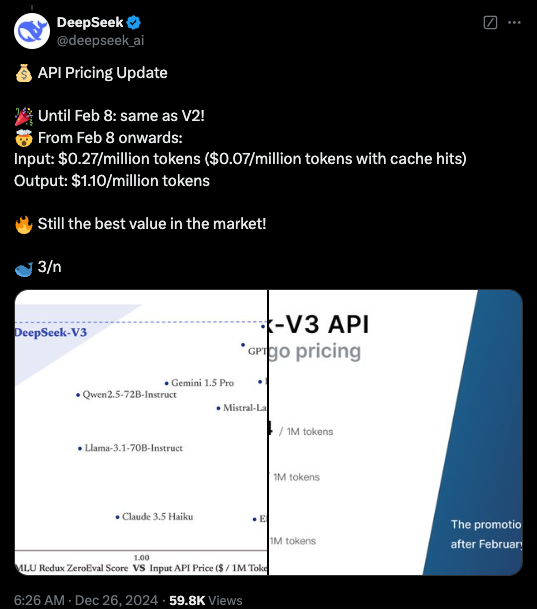

現在、DeepSeek-V3のコードはGitHubでMITライセンスで入手可能であり、モデルは同社のモデルライセンスに基づいて提供されています。企業はDeepSeek Chat(ChatGPTのようなプラットフォーム)を通じて新しいモデルをテストし、APIにアクセスして商用利用することもできます。DeepSeekは、2月8日までDeepSeek-V2と同じ価格のAPIを提供します。その後は、入力トークン100万個あたり0.27ドル(キャッシュヒットの場合、100万個あたり0.07ドル)、出力トークン100万個あたり1.10ドルの料金が発生します。

重要なポイント:

🌟 DeepSeek-V3発表、LlamaとQwenを凌駕する性能。

🔧 6710億個のパラメータと専門家混合アーキテクチャを採用、効率性を向上。

🚀 損失のない負荷分散戦略とマルチトークン予測などの革新、速度向上。

💼 トレーニングコストの大幅削減、オープンソースAIの発展を促進。