北京智譜華章科技有限公司は、年末を締めくくるにあたり、拡張強化学習技術を用いてトレーニングされた推論モデルであるGLM-Zeroの初期バージョン、GLM-Zero-Previewを発表しました。このモデルは、人工知能の推論能力、特に数理論理、コード作成、そして深い推論を必要とする複雑な問題解決能力の向上に焦点を当てています。基盤モデルと比較して、GLM-Zero-Previewは汎用タスク能力を維持しつつ、専門タスク能力が著しく向上しており、AIME2024、MATH500、LiveCodeBenchの評価において、OpenAI o1-previewと同等の性能を示しました。

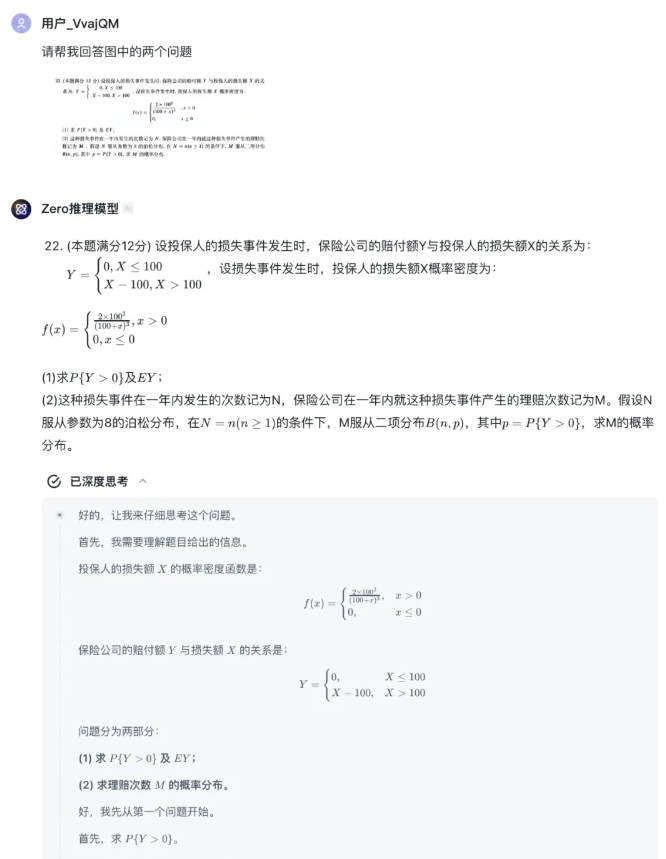

ユーザーは現在、智譜清言プラットフォームの「Zero推論モデル」エージェントでGLM-Zero-Previewを無料で体験できます。このプラットフォームはテキストと画像のアップロードに対応しており、モデルは完全な推論プロセスを出力します。また、開発者は智譜開放プラットフォームのAPIを通じてこのモデルを呼び出すことも可能です。

GLM-Zero-PreviewはOpenAIのo3モデルにはまだ一定の差がありますが、智譜華章科技有限公司は強化学習技術の継続的な最適化と改良を行い、正式版GLM-Zeroを間もなくリリースする予定です。これは、深い思考能力を数理論理からより多くの汎用技術分野へと拡張することを目指しています。

モデルの性能に関して、GLM-Zero-Previewは、強化学習がモデルの深い推論能力を高める上で重要な役割を果たしていることを示しました。トレーニングデータの増加に伴い、深い推論などの分野におけるモデルの性能は着実に向上しています。また、推論段階におけるスケーリング則も検証されており、モデルが考えることができるトークンの数が増え、計算量が増えるにつれて、出力される結果の質も着実に向上することが確認されました。GLM-Zero-Previewは、推論プロセスにおいて自律的な意思決定、問題の分解、そして複数の方法を試行して問題を解決することが可能であり、これは人間の思考決定プロセスに似ています。

実測例では、GLM-Zero-Previewは論理推論において、論理的な欠陥の識別や複数の仮説のシミュレーション能力を示しました。数学においては、強力な帰納と演繹能力を持ち、複雑な数学演算を迅速に処理し、2025年度大学院入試数学(数学1)の試験で優秀な大学院レベルの成績を達成しました。プログラミングにおいては、複数のプログラミング言語を熟練して使用し、開発者が迅速にコードを作成するのを支援します。

智譜清言:

https://chatglm.cn/main/gdetail/676411c38945bbc58a905d31?lang=zh

智譜開放プラットフォーム:

https://bigmodel.cn/dev/api/normal-model/glm-zero-preview