最近、バイトダンスは、オーディオ条件潜在拡散モデルを利用してより正確な口パク同期を実現することを目指した、LatentSyncという新しい口パク同期フレームワークを発表しました。

このフレームワークはStable Diffusionをベースにしており、時間的一貫性に関して最適化されています。

従来のピクセル空間拡散や2段階生成の方法とは異なり、LatentSyncはエンドツーエンド方式を採用しており、中間モーション表現を必要とせず、複雑な音声と視覚の関係を直接モデル化できます。

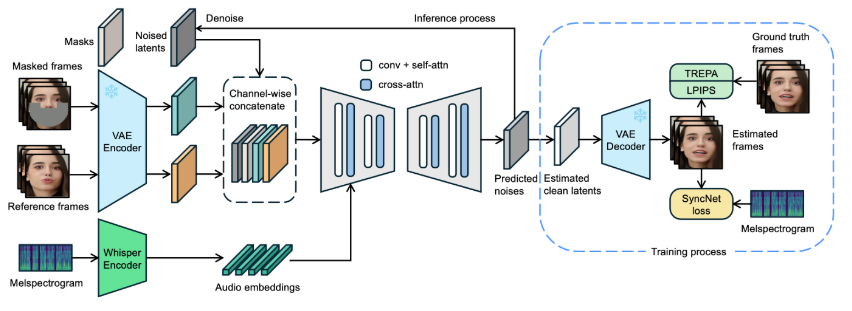

LatentSyncのフレームワークでは、まずWhisperを使用してオーディオスペクトログラムをオーディオ埋め込みに変換し、クロスアテンション層を通じてU-Netモデルに統合します。フレームワークは、参照フレームとマスクフレームをノイズ潜在変数とチャネルレベルで連結し、U-Netへの入力として使用します。

トレーニングプロセスでは、予測ノイズからクリーンな潜在変数を推定し、その後デコードしてクリーンなフレームを生成するワンステップ法を採用しています。同時に、モデルは時間的一貫性を強化し、口パク同期の正確性を維持しながら時間的に一貫性を保つために、Temporal REPresentation Alignment(TREPA)メカニズムを導入しています。

この技術の効果を示すために、プロジェクトでは、元のビデオと口パク同期処理後のビデオを示す一連のサンプルビデオを提供しています。サンプルを通して、ユーザーはLatentSyncによるビデオ口パク同期における顕著な進歩を直感的に理解できます。

元のビデオ:

出力ビデオ:

さらに、プロジェクトでは推論コードとチェックポイントをオープンソース化し、ユーザーがトレーニングとテストを容易に行えるようにする予定です。推論を試したいユーザーは、必要なモデルウェイトファイルをダウンロードするだけで操作できます。ビデオファイル処理から顔のアライメントまでのすべてのステップを網羅した完全なデータ処理フローも設計されており、ユーザーは簡単に使い始めることができます。

モデルプロジェクト入口:https://github.com/bytedance/LatentSync

要点:

🌟 LatentSyncは、中間モーション表現を必要としない、オーディオ条件潜在拡散モデルに基づくエンドツーエンドの口パク同期フレームワークです。

🎤 このフレームワークはWhisperを使用してオーディオスペクトログラムを埋め込みに変換することにより、口パク同期プロセスにおける正確性と時間的一貫性を向上させています。

📹 プロジェクトでは一連のサンプルビデオを提供しており、関連コードとデータ処理フローをオープンソース化する予定です。これにより、ユーザーは容易に使用およびトレーニングできます。