近年、大規模ビジョン言語モデル(Large Vision Language Models、LVLMs)は画像理解やクロスモーダルタスクにおいて卓越した能力を示していますが、同時に「幻覚現象」の問題も深刻化しています。この課題に対処するため、淘天グループの未来生活研究所チームは、「トークン選好最適化」(Token Preference Optimization、略してTPO)という新しい手法を提案し、自己校正型の視覚アンカー報酬メカニズムを導入しました。

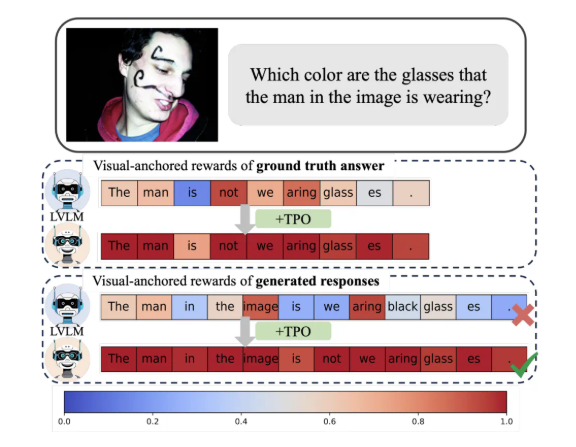

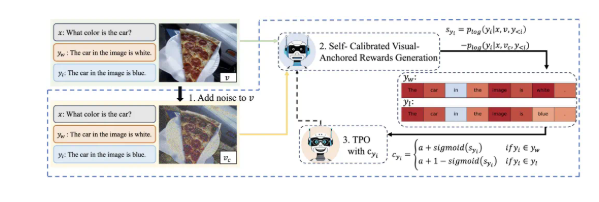

TPOの最大の革新は、自動化されたトークンレベルの報酬信号を実現した点にあります。この手法は、選好データから視覚アンカートークンを自動的に識別し、煩雑な手動による細粒度アノテーションを回避します。同時に、各トークンに、視覚情報との依存度を反映した報酬を割り当てます。この自己校正型の視覚アンカー報酬信号は、モデルの視覚情報への依存性を最適化し、幻覚現象の発生を効果的に軽減することを目指しています。

研究によると、TPOを採用したモデルは、複数の評価基準において従来の手法を大幅に上回り、特に複雑なタスクでは、モデル生成の回答が言語モデルの事前知識ではなく、画像情報にますます依存するようになりました。この進歩は、モデルの理解能力を高めるだけでなく、さらなる研究のための重要な理論的基盤も提供します。

さらに、研究チームはTPOの様々なパラメータ設定についてアブレーション実験を行い、最適化されたノイズ付加ステップと報酬割り当て戦略がモデル性能をさらに向上させることを発見しました。この発見は、将来のビジョン大規模モデルの研究開発に新たな方向性を示唆しています。

結論として、淘天のこの革新的な成果は、マルチモーダルアライメント技術に新たな視点を与え、AI技術の生活・消費分野への深い応用を推進します。