人工知能技術の進歩に伴い、視覚データとテキストデータの融合は複雑な課題となっています。従来のモデルでは、表、グラフ、インフォグラフィック、図表などの構造化された視覚文書を正確に解析することが困難であり、自動的なコンテンツ抽出と理解能力に影響を与え、ひいてはデータ分析、情報検索、意思決定などのアプリケーションに影響を与えていました。このニーズに応えるため、IBMは最近、文書理解のために設計された小型の視覚言語モデルであるGranite-Vision-3.1-2Bを発表しました。

Granite-Vision-3.1-2Bは、表、グラフ、図表など、様々な視覚形式からコンテンツを抽出できます。このモデルは、公共および合成ソースを含む厳選されたデータセットを使用してトレーニングされており、様々な文書関連タスクを処理できます。Granite大規模言語モデルの改良版として、画像とテキストの2つのモダリティを統合することで、モデルの解釈能力が向上し、様々な実用的なアプリケーションシナリオに適しています。

このモデルは3つの主要なコンポーネントで構成されています。まず、視覚エンコーダーは、SigLIPを使用して視覚データを効率的に処理およびエンコードします。次に、視覚言語コネクターは、GELU活性化関数を持つ2層の多層パーセプトロン(MLP)であり、視覚情報とテキスト情報を接続することを目的としています。最後に、大規模言語モデルは、Granite-3.1-2B-Instructに基づいており、128kのコンテキスト長を持ち、複雑で大量の入力を処理できます。

トレーニングにおいて、Granite-Vision-3.1-2BはLlaVAを参考に、多層エンコーダーの特性とAnyResにおけるより密なグリッド解像度を組み合わせています。これらの改良により、詳細な視覚コンテンツの理解能力が向上し、表やグラフの分析、光学文字認識(OCR)、文書ベースのクエリへの回答など、視覚文書タスクをより正確に実行できるようになりました。

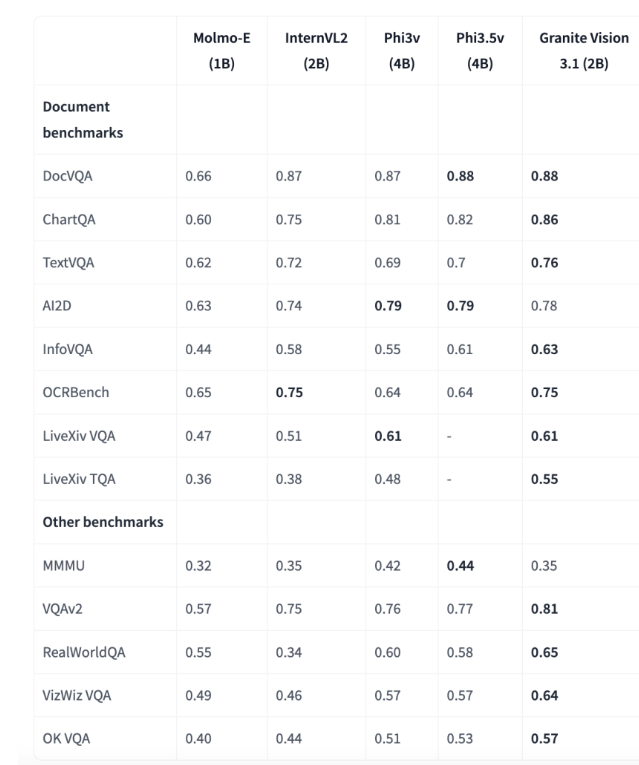

評価の結果、Granite-Vision-3.1-2Bは複数のベンチマークテストで優れた性能を示し、特に文書理解において顕著です。ChartQAベンチマークテストでは、0.86というスコアを獲得し、パラメータが1B~4Bの範囲にある他のモデルを上回りました。TextVQAベンチマークテストでは、0.76というスコアを獲得し、画像に埋め込まれたテキスト情報の解析と回答における強力な能力を示しました。これらの成果は、企業アプリケーションにおける正確な視覚データとテキストデータ処理の可能性を浮き彫りにしています。

IBMのGranite-Vision-3.1-2Bは、視覚言語モデルの重要な進歩を表しており、バランスの取れた視覚文書理解ソリューションを提供します。そのアーキテクチャとトレーニング方法は、複雑な視覚データとテキストデータを効率的に解析および分析することを可能にします。トランスフォーマーとvLLMへのネイティブサポートにより、このモデルは様々なユースケースに適応でき、Colab T4などのクラウド環境に展開することができ、研究者や専門家にとってAI駆動の文書処理能力を強化するための実用的なツールとなります。

モデル:https://huggingface.co/ibm-granite/granite-vision-3.1-2b-preview

要点:

🌟 Granite-Vision-3.1-2Bは、IBMが文書理解のために設計した小型の視覚言語モデルであり、様々な視覚形式のコンテンツ抽出を処理できます。

📊 このモデルは、視覚エンコーダー、視覚言語コネクター、大規模言語モデルの3つの部分で構成されており、複雑な入力に対する理解能力が向上しています。

🏆 複数のベンチマークテストで優れた性能を示し、特に文書理解分野において、強力な企業アプリケーションの可能性を示しています。