豆包大規模モデルチームの公式アカウントによると、北京交通大学と中国科学技術大学の共同研究により、豆包大規模モデルチームが提案した「VideoWorld」動画生成実験モデルが近日正式にオープンソース化されました。

このモデルの最大の特徴は、従来の言語モデルに依存せず、視覚情報のみで世界を認識・理解できる点です。この画期的な研究は、李飛飛教授がTED講演で述べた「幼児は言語に頼らずに現実世界を理解できる」という考えから着想を得ています。

「VideoWorld」は大量の動画データを分析・処理することで、複雑な推論、計画、意思決定能力を実現しました。研究チームの実験によると、わずか3億個のパラメータで顕著な効果が得られました。言語やラベルデータに依存する既存のモデルとは異なり、VideoWorldは独立して知識学習を行うことができ、特に折り紙やネクタイ結びなどの複雑なタスクにおいて、より直感的な学習方法を提供します。

モデルの有効性を検証するため、研究チームは囲碁対戦とロボットシミュレーション制御の2種類の試験環境を構築しました。囲碁は高度な戦略性を持つゲームであるため、モデルのルール学習と推論能力を効果的に評価できます。一方、ロボットタスクは、モデルの制御と計画能力を検証します。トレーニング段階では、モデルは大量の動画デモデータを見ることで、将来の映像を予測する能力を徐々に構築していきます。

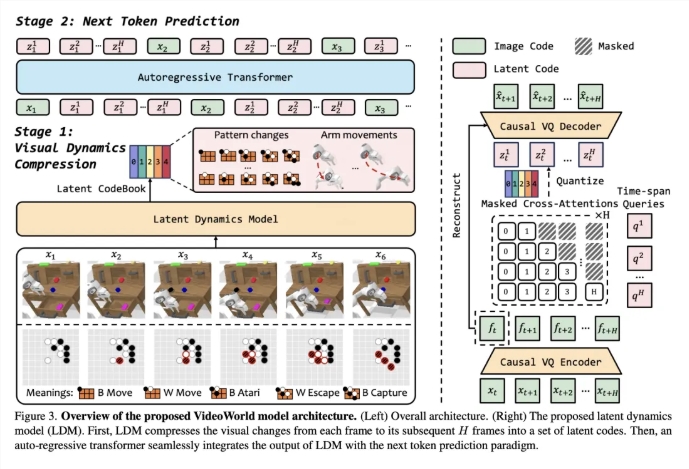

動画学習の効率を高めるため、チームは潜在動的モデル(LDM)を導入しました。これは動画フレーム間の視覚的な変化を圧縮し、重要な情報を抽出することを目的としています。この方法は、冗長な情報を削減するだけでなく、複雑な知識の学習効率も向上させます。この革新により、VideoWorldは囲碁とロボットタスクにおいて優れた能力を示し、プロ五段レベルの囲碁の実力に達しました。

論文リンク:https://arxiv.org/abs/2501.09781

コードリンク:https://github.com/bytedance/VideoWorld

プロジェクトホームページ:https://maverickren.github.io/VideoWorld.github.io

要点:

🌟 「VideoWorld」モデルは視覚情報のみで知識学習が可能であり、言語モデルに依存しません。

🤖 モデルは囲碁とロボットシミュレーションタスクにおいて、優れた推論と計画能力を示しました。

🔓 このプロジェクトのコードとモデルはオープンソース化されており、皆様の参加と交流を歓迎します。