最近、マイクロソフトの研究チームは複数の大学研究者と協力し、「Magma」という多様なモダリティに対応したAIモデルを発表しました。このモデルは、画像、テキスト、動画など様々な種類のデータを処理・統合し、デジタル環境と物理環境の両方で複雑なタスクを実行することを目的として設計されています。技術の進歩に伴い、多様なモダリティに対応したAIエージェントは、ロボット工学、バーチャルアシスタント、ユーザーインターフェースの自動化などの分野で広く活用されています。

従来のAIシステムは、通常、視覚言語理解またはロボット操作のみに焦点を当てており、これら2つの能力を統一的なモデルに統合することが困難でした。多くの既存モデルは特定の分野では優れた性能を示しますが、異なるアプリケーションシナリオでの汎化能力は低い傾向があります。例えば、Pix2ActやWebGUMモデルはUIナビゲーションにおいて優れた性能を示しますが、OpenVLAやRT-2はロボット操作に適しています。しかし、これらは別々にトレーニングする必要があり、デジタル環境と物理環境の境界を越えることが困難でした。

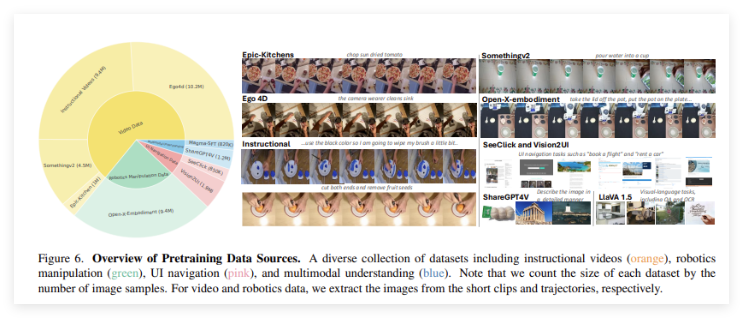

「Magma」モデルは、これらの限界を克服するために開発されました。強力なトレーニング方法を導入することで、多様なモダリティの理解、動作の特定、計画能力を統合し、AIエージェントが様々な環境でシームレスに動作することを目指しています。「Magma」のトレーニングデータセットは3900万サンプルを含み、画像、動画、ロボットの動作軌跡が含まれています。さらに、このモデルは「可マーク集合」(Set-of-Mark, SoM)と「軌跡マーク」(Trace-of-Mark, ToM)という2つの革新的な技術を採用しています。前者はモデルがUI環境で操作可能な視覚オブジェクトをマークすることを可能にし、後者は物体の時間の経過に伴う移動を追跡し、将来の行動計画能力を高めます。

「Magma」は、高度な深層学習アーキテクチャと大規模な事前トレーニング技術を採用し、複数の分野でのパフォーマンスを最適化しています。モデルはConvNeXt-XXLビジョンバックボーンを使用して画像と動画を処理し、LLaMA-3-8B言語モデルはテキスト入力の処理を担当します。このアーキテクチャにより、「Magma」は視覚、言語、動作実行を効率的に統合できます。包括的なトレーニングを経て、モデルは複数のタスクで優れた成果を収め、強力な多様なモダリティの理解と空間推論能力を示しています。

プロジェクト入口:https://microsoft.github.io/Magma/

要点:

🌟 Magmaモデルは3900万以上のサンプルでトレーニングされ、強力な多様なモダリティ学習能力を備えています。

🤖 このモデルは視覚、言語、行動をうまく統合し、既存のAIモデルの限界を克服しています。

📈 Magmaは複数のベンチマークテストで優れた性能を示し、強力な汎化能力と優れた意思決定実行能力を備えています。