人工知能分野において、言語モデルの急速な発展により、音声理解言語モデル(SULMs)が広く注目されています。最近、西北工業大学ASLP研究所は、学術資源が限られた状況下で、音声理解モデルを効果的に訓練し活用する方法を探求し、学術界の研究とイノベーションを促進することを目的とした、オープン音声理解モデルOSUMを発表しました。

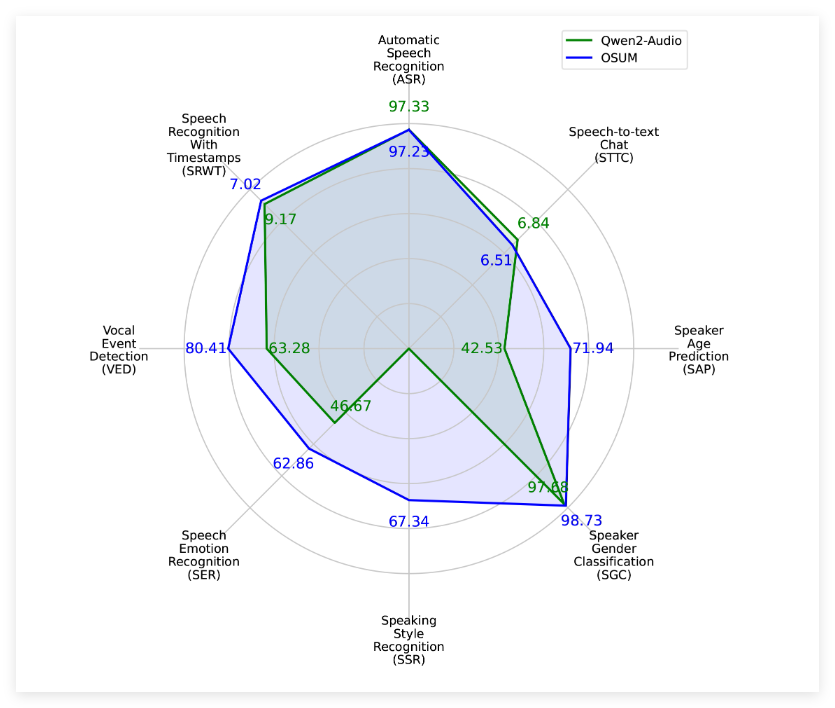

OSUMモデルは、WhisperエンコーダーとQwen2言語モデルを融合し、音声認識(ASR)、タイムスタンプ付き音声認識(SRWT)、音声イベント検出(VED)、音声感情認識(SER)、話し方スタイル認識(SSR)、話者性別分類(SGC)、話者年齢予測(SAP)、音声テキストチャット(STTC)など、8種類の音声タスクに対応しています。このモデルはASR+X訓練戦略を採用することで、目標タスクを実行しながら、音声認識を効率的かつ安定的に最適化し、マルチタスク学習能力を向上させます。

OSUMモデルの発表は、性能だけでなく、透明性も重視しています。その訓練方法とデータ準備プロセスは公開されており、学術界に貴重な参考と指導を提供することを目的としています。技術レポートv2.0によると、OSUMモデルの訓練データ量は50.5K時間に増加し、以前の44.1K時間よりも大幅に増加しています。その中には、3000時間の話者性別分類データと6800時間の話者年齢予測データが含まれています。これらのデータの拡張により、モデルは様々なタスクにおいてより優れた性能を発揮します。

評価結果によると、OSUMは、計算資源と訓練データが明らかに少ないにもかかわらず、多くのタスクにおいてQwen2-Audioモデルを上回っています。関連する評価結果は、公開テストセットだけでなく、内部テストセットも網羅しており、OSUMモデルの音声理解タスクにおける優れた性能を示しています。

西北工業大学ASLP研究所は、OSUMの目標は、オープンな研究プラットフォームを通じて、高度な音声理解技術の発展を促進することだと述べています。研究者や開発者は、このモデルのコードと重みを自由に使用でき、商業目的にも使用できます。これにより、技術の応用と普及が加速されます。

プロジェクト入口:https://github.com/ASLP-lab/OSUM?tab=readme-ov-file

要点:

🌟 OSUMモデルはWhisperエンコーダーとQwen2言語モデルを組み合わせ、多様な音声タスクに対応し、マルチタスク学習を支援します。

📊 OSUMは技術レポートv2.0において、訓練データ量が50.5K時間に増加し、モデルの性能が向上しました。

🆓 このモデルのコードと重みはApache2.0ライセンスの下で公開されており、学術界と産業界の幅広い利用を奨励しています。