中国の人工知能企業DeepSeekは、「オープンソースウィーク」3日目に、FP8汎用行列乗算(GEMM)をサポートするオープンソースライブラリDeepGEMMを発表しました。このツールは、密集型および混合専門家(MoE)行列演算向けに設計されており、DeepSeek V3およびR1モデルのトレーニングと推論を強力にサポートします。公式発表はXプラットフォームを通じて行われ、技術コミュニティで大きな反響を呼びました。

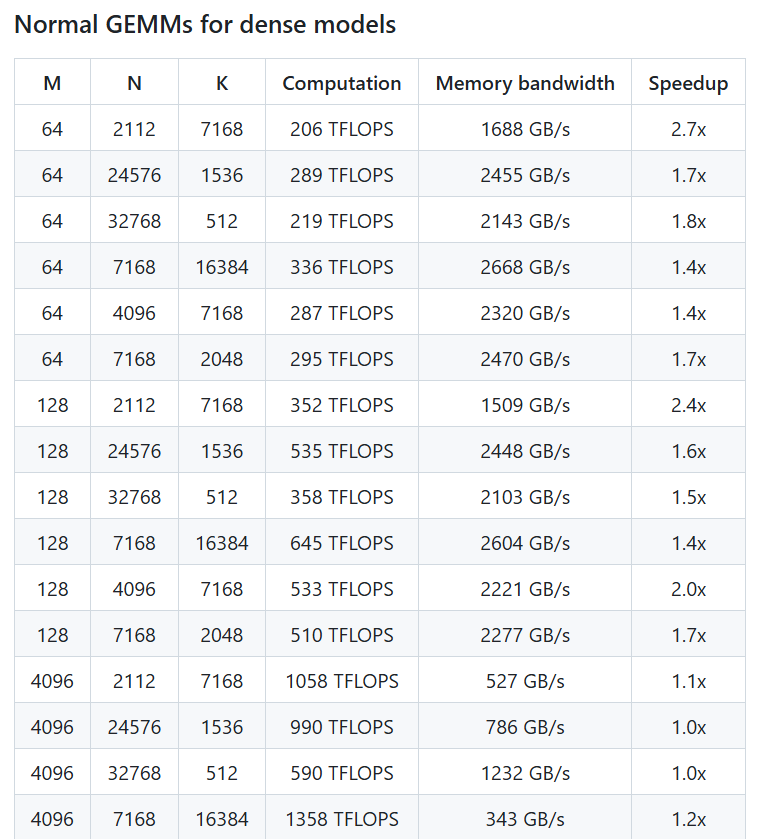

DeepSeek公式アカウントの投稿によると、DeepGEMMはNVIDIA Hopper GPU上で最大1350 TFLOPSを超えるFP8計算性能を実現します。そのコアロジックはわずか約300行のコードですが、ほとんどの行列サイズで専門家が調整したカーネルを上回り、高い効率性と簡潔性を示しています。このライブラリは複雑な依存関係を必要とせず、Just-In-Time(JIT)コンパイル技術を採用し、密集型レイアウトと2種類のMoEレイアウトをサポートしています。「チュートリアルのように分かりやすい」設計で、開発者にとって学習と使用が容易です。

Xユーザーの@TechBitDailyは、「DeepGEMMの発表はDeepSeekオープンソースウィークのハイライトであり、そのFP8性能と簡潔な設計は印象的です」とコメントしています。別のユーザー@AIObserverCNは、このライブラリがMoEモデルの効率的なトレーニングをサポートする上で顕著な利点があり、Hopperアーキテクチャ上でのAIコミュニティのさらなるイノベーションを促進する可能性があると指摘しています。

オープンソースウィークの一環として、DeepGEMMの発表は、DeepSeekがAI技術の透明性とコミュニティ協力を推進するというコミットメントを継続したものです。これ以前、同社は最初の2日間で、高速言語モデルアーキテクチャと専門家並列通信に焦点を当てたFlashMLAとDeepEPツールを発表しました。今回のDeepGEMMの発表は、AIインフラストラクチャ構築における同社の技術力をさらに示すものです。業界関係者は、このライブラリがDeepSeek独自のモデルの性能向上に貢献するだけでなく、世界中の開発者にとって効率的で使いやすい行列演算ツールを提供し、将来の応用範囲が期待できると考えています。ユーザーは現在、GitHubからDeepGEMMを入手し、AIトレーニングと推論における可能性を探ることができます。

プロジェクトアドレス:https://github.com/deepseek-ai/DeepGEMM