人工知能の分野において、アリババの通義实验室チームは最近、最新開発のマルチモーダルモデルであるR1-Omniをオープンソースとして公開しました。このモデルは強化学習と検証可能な報酬(RLVR)手法を組み合わせることで、音声や動画情報の処理において卓越した能力を示しています。R1-Omniの最大の特徴は透明性であり、各モダリティが意思決定プロセスにおいてどのような役割を果たしているかをより明確に理解することができます。特に感情認識などのタスクにおいてその効果は顕著です。

DeepSeek R1の発表に伴い、大規模モデルにおける強化学習の可能性がさらに探求されています。RLVR手法はマルチモーダルのタスクに新たな最適化のアイデアをもたらし、幾何学的推論や視覚的カウントなどの複雑なタスクを効果的に処理することができます。現在の研究は画像とテキストの組み合わせに集中しているものが多くありますが、通義实验室の最新の研究は、RLVRと動画の全モダリティモデルを組み合わせることで、この分野を拡大し、技術の幅広い応用可能性を示しています。

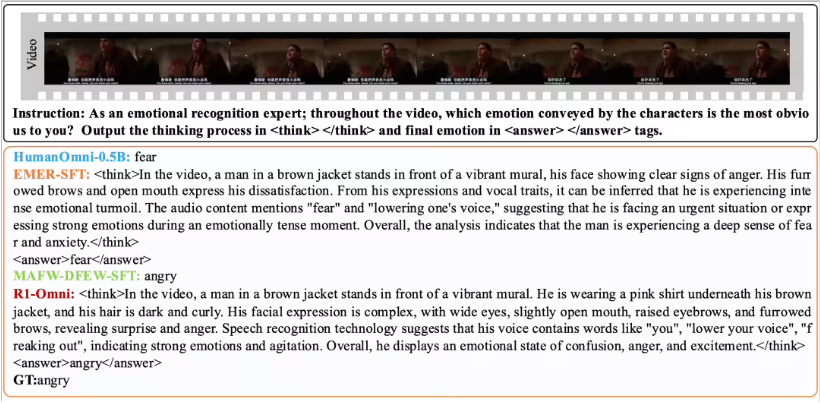

R1-OmniはRLVR手法により、音声と動画情報の影響をより直感的に理解できるようにします。例えば、感情認識タスクにおいて、モデルはどの音声・動画信号が感情判断において重要な役割を果たしているかを明確に示すことができます。この透明性により、モデルの信頼性が向上するだけでなく、研究者や開発者にとってより良い洞察を提供します。

性能検証において、通義实验室チームはR1-Omniと元のHumanOmni-0.5Bモデルを比較実験しました。その結果、R1-OmniはDFEWとMAFWデータセットにおいて顕著な性能向上を示し、平均で35%以上の向上を達成しました。さらに、従来の教師あり微調整(SFT)モデルと比較して、R1-Omniは教師なし学習(UAR)においても10%以上の向上を達成しました。様々な分布のテストセット(RAVDESSなど)において、R1-Omniは優れた汎化能力を示し、WARとUARの両方で13%以上の向上を示しました。これらの成果は、RLVRが推論能力の向上に優れていることを証明するだけでなく、将来のマルチモーダルモデル研究のための新たなアイデアと方向性を提供します。

R1-Omniのオープンソース化により、より多くの研究者や開発者が便利に利用できるようになり、このモデルが将来の応用においてより多くのイノベーションとブレークスルーをもたらすことが期待されます。