GTC2025で、NVIDIAは次世代AIチッププラットフォーム「Vera Rubin」を発表しました。これは、アメリカの著名な天文学者であるヴェラ・ルービン氏への敬意を表したもので、科学者の名前をアーキテクチャの名前に付けるNVIDIAの伝統を継承しています。このシリーズの最初の製品であるVera Rubin NVL144は、2026年下半期に発売される予定です。

NVIDIAのCEOであるジェンスン・フアン氏は、Rubinの性能は現在のHopperアーキテクチャの900倍に達すると述べました。最新のBlackwellアーキテクチャがHopperの68倍の性能向上を実現したことを考えると、Rubinはさらに大きな計算能力の飛躍をもたらすことが示唆されています。

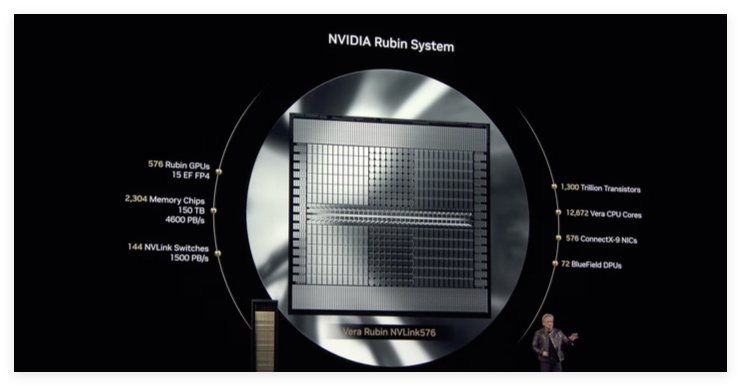

公式発表によると、Vera Rubin NVL144はFP64精度での推論演算能力が3.6ExaFLOPS、FP8精度でのトレーニング性能が1.2ExaFLOPSに達します。GB300NVL72と比較して、性能は3.3倍向上しています。Rubinは最新のHBM4メモリを搭載し、帯域幅は驚異的な13TB/sに達します。また、75TBの高速メモリを搭載しており、前世代の1.6倍です。インターコネクトに関しては、RubinはNVLink6とCX9をサポートし、帯域幅はそれぞれ260TB/sと28.8TB/sに達し、いずれも前世代の2倍です。

標準版のRubinチップはHBM4メモリを搭載し、その全体的な性能は現在のフラッグシップであるHopper H100チップをはるかに凌駕します。

特筆すべきは、RubinプラットフォームがGrace CPUの後継となる新しいCPU「Veru」を採用することです。Veruは88個のカスタムArmコアを搭載し、各コアは176スレッドをサポートし、NVLink-C2Cにより最大1.8TB/sの高帯域幅接続を実現します。NVIDIAは、カスタムVera CPUの速度が昨年のGrace Blackwellチップで使用されたCPUよりも2倍向上すると述べています。

Vera CPUと組み合わせることで、Rubinの推論タスクにおける演算能力は50petaflopsに達し、Blackwellの20petaflopsの2倍以上です。さらに、Rubinは最大288GBのHBM4メモリをサポートします。これは、大規模なAIモデルを処理する必要がある開発者にとって非常に重要です。

Blackwellと同様に、Rubinは実際には2つのGPUで構成されており、高度なパッケージング技術によって1つのユニットとして統合され、全体的な計算効率と性能が向上しています。Rubinの発表は、NVIDIAがAIチップ分野における強力なイノベーション能力と、将来の計算能力への深い洞察を持っていることを改めて示しています。