この度、HPC-AI Techは画期的なビデオAIシステムであるOpen-Sora2.0を発表しました。これは、従来の訓練コストの約10分の1で商用レベルの品質を実現するシステムです。この進歩は、リソースを大量に消費するビデオAI分野におけるパラダイムシフトを示唆しており、言語モデルにおける効率性の向上に匹敵するものです。

Movie GenやStep-Video-T2Vといった既存の高品質ビデオ生成システムの訓練費用は数百万ドルに上る可能性がありますが、Open-Sora2.0の訓練費用は約20万ドルに過ぎません。コストの大幅な削減にもかかわらず、テストの結果、その出力品質はRunway Gen-3AlphaやHunyuanVideoなどの確立された商用システムに匹敵することが示されました。このシステムは、224個のNvidia H200 GPUを使用して訓練されました。

ヒント:「ベージュのソファに2人の女性が座っています。居間は温かく居心地がよく、背景はレンガの壁です。2人は楽しそうに話し合い、笑顔で、親密なミディアムショットでワインを祝杯しています。」|ビデオ:HPC-AI Tech

Open-Sora2.0は、新規な3段階の訓練プロセスによって効率性を達成しています。まず低解像度のビデオから始め、段階的に高解像度へと細化していきます。Fluxのような事前学習済みの画像モデルを統合することで、リソースの利用効率がさらに向上しています。その中核となるのはビデオDC-AEオートエンコーダーであり、従来の方法と比較して優れた圧縮率を実現しています。この革新は、注目すべき5.2倍の訓練速度向上と10倍以上のビデオ生成速度向上をもたらしました。圧縮率の向上により出力の詳細が若干減少するものの、ビデオ作成プロセスが大幅に高速化されます。

ヒント:「レタスの上でトマトがサーフィンをしています。牧場ドレッシングの滝を滑り降りる、大げさなサーフィンアクションと滑らかな波の表現が3Dアニメーションの楽しさを際立たせています。」|ビデオ:HPC-AI Tech

このオープンソースシステムは、テキストの説明と単一の画像からビデオを生成でき、モーションスコア機能により、ユーザーは生成されたクリップ内のモーションの強度を制御できます。HPC-AI Techが提供する例では、リアルな会話や空想的なアニメーションなど、さまざまなシーンが示されています。

しかし、Open-Sora2.0は現在、解像度(768x768ピクセル)と最長ビデオの長さ(5秒または128フレーム)に制限があり、OpenAIのSoraなどの最先端モデルの機能には劣ります。それにもかかわらず、視覚的な品質、プロンプトの正確性、モーション処理などの重要な分野におけるパフォーマンスは、商用基準に近づいています。注目すべきは、Open-Sora2.0のVBenchスコアが、現在OpenAIのSoraに0.69%しか劣っておらず、以前のバージョンと比較して4.52%の差が大幅に改善されていることです。

ヒント:「擬人化されたキノコたちが、暗い魔法の森でディスコパーティーを開いています。きらめくネオンライトと大げさなダンスで、滑らかな質感と反射する表面が滑稽な3Dルックを強調しています。」|ビデオ:HPC-AI Tech

Open-Sora2.0のコスト効率の高い戦略は、言語モデルにおける「Deepseekモーメント」を想起させます。当時、改良された訓練方法により、オープンソースシステムは商用システムよりもはるかに低いコストで商用レベルのパフォーマンスを実現することができました。この発展は、計算コストの高騰によりサービスが秒単位で課金されているビデオAI分野の価格に下落圧力をかける可能性があります。

訓練コスト比較:Open-Sora2.0は約20万ドル必要ですが、Movie Genは250万ドル、Step-Video-T2Vは100万ドル必要です。|画像:HPC-AI Tech

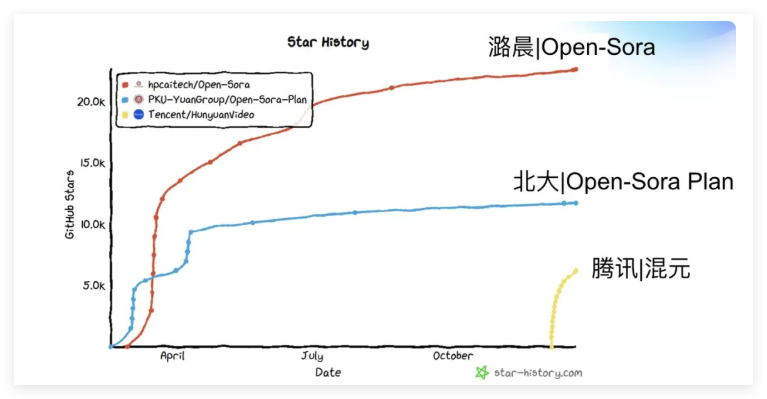

この進歩にもかかわらず、オープンソースと商用ビデオAI間の性能差は言語モデルよりも大きく、この分野における技術的な課題が依然として存在することを示しています。Open-Sora2.0は現在、GitHubでオープンソースプロジェクトとして提供されています。