最新の研究で、Google、カーネギーメロン大学、MultiOnチームは、合成データが巨大言語モデルの学習に与える影響について共同で調査しました。その結果、合成データは特に数学問題解決能力において、大規模モデルの論理推論能力を驚くべきことに8倍も向上させることが分かりました。これは、現在、訓練データの不足が深刻な問題となっている状況において、非常に重要な発見です。

現在、世界中で利用可能な高品質なテキスト訓練データは約300兆件ですが、ChatGPTのようなモデルの普及に伴い、訓練データへの需要は急激に増加しており、2026年までには需要を満たせなくなることが予想されています。このような背景から、合成データは極めて重要な代替手段となっています。

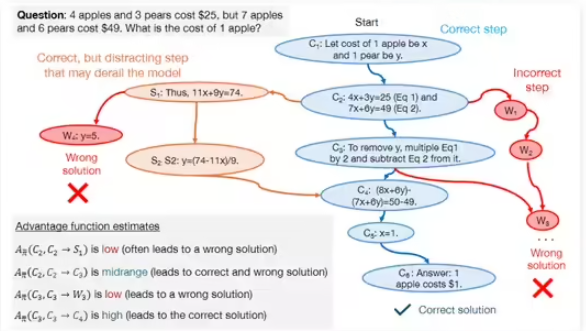

研究チームは主に、正例データと負例データの2種類の合成データを探求しました。正例データとは、GPT-4やGemini1.5Proなどの高性能モデルによって生成された、正しい問題解決手順のことです。これらは他のモデルにとって模範となります。しかし、正例データのみで学習を行うと、モデルが問題解決のプロセスを真に理解することなく、パターンマッチングによって学習してしまう可能性があり、汎化能力が低下するといった欠点があります。

これらの欠点を克服するために、研究チームは負例データを取り入れました。負例データとは、間違っていると検証された問題解決手順のことです。このデータは、モデルが一般的な間違いを認識し、論理推論能力を向上させるのに役立ちます。負例データの使用には、間違った手順が誤解を招く可能性があるという課題がありますが、研究者らは直接的選好最適化(DPO)手法を用いることで、モデルが間違いから効果的に学習し、問題解決プロセスにおける各手順の重要性を明確に理解できるようにしました。

研究では、DeepSeek-Math-7BやLLaMa2-7Bなどのモデルを用い、GSM8KとMATHデータセットで大量のテストを行いました。その結果、正例と負例の合成データで事前学習させた大規模モデルは、数学的推論タスクにおける性能が8倍向上しました。この研究成果は、合成データが巨大言語モデルの論理推論能力向上に大きな可能性を秘めていることを示すとともに、将来のモデル学習のための新たな方向性を示唆しています。