Metaは、大規模言語モデルLlama-3のトレーニング専用に設計された、2つの24K H100 GPUクラスタを公式ウェブサイトで発表しました。Llama-3は、RoCEv2ネットワークとTectonic/HammerspaceのNFS/FUSEネットワークストレージを採用しています。4月末から5月中旬にかけての公開が予定されており、マルチモーダルモデルとなり、引き続きオープンソースとして提供される可能性があります。Metaは、2024年末までに60万個のH100の計算能力を保有する計画です。

関連AIニュースの推奨

メタ、英国で顔認証による不正防止テストを開始 規制当局の承認後に拡大へ

Mar 5, 2025

10

Metaを退社したPyTorchのリーダー、Horace He氏、OpenAI前CTOが設立したスタートアップに加入

Mar 5, 2025

16.0k

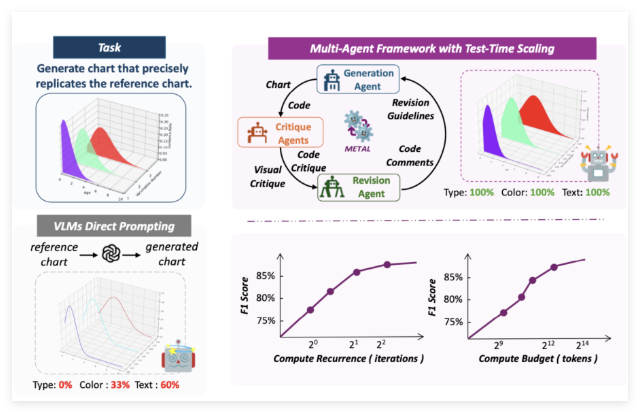

アドビと大学が共同でMETALフレームワークを発表:マルチエージェント協調による正確な図表生成

今日のデータ可視化の分野において、複雑なデータを正確に反映した図表を生成することは依然として難しい課題です。図表は正確なレイアウト、色、テキストの位置を捉える必要があるだけでなく、これらの視覚的な詳細をコードに変換して、意図したデザインを再現する必要があります。しかし、従来の方法では、GPT-4Vなどの視覚言語モデル(VLM)への直接的なプロンプトに依存することが多く、複雑な視覚要素を構文的に正しいPythonコードに変換する際に困難に直面します。小さな間違いでも、図表がデザイン目標を達成できない可能性があります。

Mar 3, 2025

15.9k

Meta、独立AIチャットボットアプリを発売へ ユーザー基盤拡大目指す

Feb 28, 2025

15.8k