最近、中山大学とバイトダンスのデジタルヒューマンチームが大きなニュースを発表しました。MMTryonと呼ばれるバーチャル試着フレームワークを開発したのです。これは非常に画期的で、数枚の洋服の写真と着こなしに関するテキスト指示を入力するだけで、モデルが服を着た様子をワンクリックで生成でき、しかも非常に高品質です。

コート、パンツ、バッグを選んで「パチン」とすると、それらが自動的に人物画像に装着されます。実写の人物でも漫画の人物でも、ワンクリックで完了します。実にクールな操作性です!

MMTryonの優れた点はそれだけではありません。単一画像の着せ替えにおいては、大量のデータを用いた服装エンコーダーを活用し、複雑な着せ替えシーンやあらゆる種類の服装スタイルに対応できます。複数のアイテムの着せ替えにおいては、従来のアルゴリズムが依存していた服装の精密な分割を必要とせず、テキスト指示一つで、リアルで自然な結果を生成します。

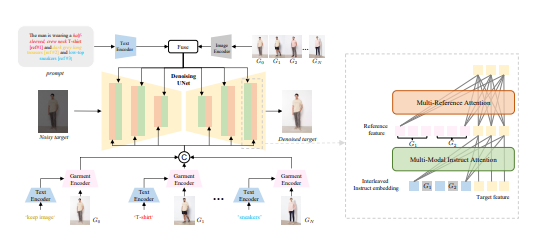

ベンチマークテストでは、MMTryonは最新のSOTA(最先端技術)を達成しました。研究チームはマルチモーダルマルチリファレンスアテンションメカニズムも導入し、着せ替え効果の精度と柔軟性を向上させています。従来のバーチャル試着ソリューションは、単品しか試着できないか、または服装スタイルに制約がありましたが、MMTryonはそれらをすべて解決します。

さらに、MMTryonは表現力の高い服装エンコーダーと、革新的な拡張可能なデータ生成プロセスを採用しており、着せ替えプロセスで分割が不要になり、テキストと複数の試着対象物から高品質なバーチャル着せ替えを実現します。

オープンソースデータセットと複雑なシーンにおける多数の実験により、MMTryonは定性的にも定量的にも既存のSOTA手法を上回ることが証明されました。研究チームは服装エンコーダーを事前学習し、テキストをクエリとして使用してテキストに対応する領域の特徴を活性化することで、服装の分割への依存を解消しました。

さらに驚くべきことに、組み合わせ着せ替えの訓練のために、研究チームは大規模モデルに基づくデータ拡張モデルを提案し、100万件の拡張データセットを構築しました。これにより、MMTryonはあらゆる種類の着せ替えにおいてリアルなバーチャル試着効果を実現します。

MMTryonはファッション業界の革新技術と言えるでしょう。ワンクリック試着を可能にするだけでなく、ファッション着せ替え補助設計ツールとしても活用でき、服選びを支援します。定量指標とヒューマンエバリュエーションにおいても、MMTryonは他のベースラインモデルを凌駕し、その効果は抜群です。

論文アドレス:https://arxiv.org/abs/2405.00448