El equipo Qwen de Alibaba ha lanzado recientemente a QwQ-32B, el último miembro de su familia de modelos lingüísticos grandes (LLM) de código abierto. Este modelo de inferencia con 32 mil millones de parámetros tiene como objetivo mejorar el rendimiento en tareas de resolución de problemas complejos mediante el aprendizaje por refuerzo (RL).

Según la información proporcionada, QwQ-32B ya está disponible en Hugging Face y ModelScope bajo la licencia Apache2.0. Esto significa que el modelo se puede utilizar con fines comerciales y de investigación, y las empresas pueden integrarlo directamente en sus productos y aplicaciones, incluidos los servicios de pago. Los usuarios individuales también pueden acceder al modelo a través de Qwen Chat.

QwQ, cuyo nombre completo es Qwen-with-Questions, es un modelo de inferencia de código abierto lanzado por primera vez por Alibaba en noviembre de 2024, con el objetivo de competir con el o1-preview de OpenAI. El QwQ original mejoró su razonamiento lógico y su capacidad de planificación mediante la revisión y mejora de sus propias respuestas durante el proceso de inferencia, destacando especialmente en tareas matemáticas y de codificación.

El QwQ anterior contaba con 32 mil millones de parámetros y una longitud de contexto de 32.000 tokens, superando a o1-preview en pruebas de referencia matemáticas como AIME y MATH, y en tareas de razonamiento científico como GPQA. Sin embargo, las versiones anteriores de QwQ mostraron un rendimiento relativamente débil en pruebas de referencia de programación como LiveCodeBench, y enfrentaron desafíos como la mezcla de idiomas y la ocasional circularidad en los argumentos.

A pesar de ello, Alibaba ha optado por publicar el modelo bajo la licencia Apache2.0, lo que lo diferencia de las alternativas propietarias como o1 de OpenAI, permitiendo a los desarrolladores y empresas adaptarlo y comercializarlo libremente. Con el avance del campo de la IA, las limitaciones de los LLM tradicionales son cada vez más evidentes, y la mejora del rendimiento derivada de la ampliación a gran escala se está ralentizando, lo que impulsa el interés en los modelos de inferencia a gran escala (LRM). Los LRM mejoran la precisión mediante la inferencia en tiempo de inferencia y la autorreflexión, como la serie o3 de OpenAI y DeepSeek-R1.

El nuevo QwQ-32B, mediante la integración del aprendizaje por refuerzo y el autocuestionamiento estructurado, ha mejorado aún más su rendimiento, con el objetivo de convertirse en un competidor importante en el campo de la IA de inferencia. La investigación del equipo QwQ demuestra que el aprendizaje por refuerzo puede mejorar significativamente la capacidad del modelo para resolver problemas complejos. QwQ-32B emplea un método de entrenamiento de aprendizaje por refuerzo multietapa para mejorar el razonamiento matemático, la capacidad de codificación y la resolución de problemas generales.

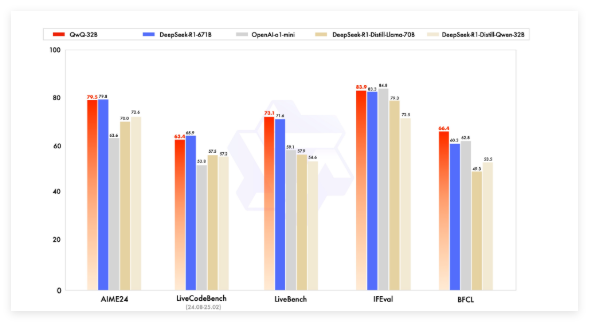

En las pruebas de referencia, QwQ-32B compitió con modelos líderes como DeepSeek-R1, o1-mini y DeepSeek-R1-Distilled-Qwen-32B, logrando resultados competitivos a pesar de tener un menor número de parámetros que algunos de sus competidores. Por ejemplo, DeepSeek-R1 tiene 671 mil millones de parámetros (37 mil millones activados), mientras que QwQ-32B, con un rendimiento similar, tiene una menor necesidad de memoria, generalmente 24 GB de vRAM en GPU, mientras que ejecutar DeepSeek R1 completo requiere más de 1500 GB de vRAM.

QwQ-32B utiliza una arquitectura de modelo de lenguaje causal y se ha optimizado en varios aspectos, incluyendo 64 capas Transformer, RoPE, SwiGLU, RMSNorm y sesgo de atención QKV. También emplea atención de consulta generalizada (GQA), tiene una longitud de contexto extendida de 131.072 tokens y ha pasado por un entrenamiento multietapa que incluye preentrenamiento, ajuste fino supervisado y aprendizaje por refuerzo.

El proceso de aprendizaje por refuerzo de QwQ-32B se divide en dos etapas: la primera se centra en la capacidad matemática y de codificación, utilizando un validador de precisión y un servidor de ejecución de código para el entrenamiento. La segunda etapa utiliza un modelo de recompensa general y un validador basado en reglas para el entrenamiento de recompensas, con el fin de mejorar el seguimiento de instrucciones, la alineación humana y la capacidad de razonamiento del agente, sin afectar a su capacidad matemática y de codificación.

QwQ-32B también posee capacidades agentivas, pudiendo ajustar dinámicamente el proceso de inferencia en función de la retroalimentación del entorno. El equipo QwQ recomienda utilizar una configuración de inferencia específica para obtener el mejor rendimiento y admite el despliegue con vLLM.

El equipo Qwen considera QwQ-32B como el primer paso para mejorar la capacidad de razonamiento mediante la ampliación del aprendizaje por refuerzo. En el futuro, planea explorar aún más la ampliación del aprendizaje por refuerzo, integrar agentes con aprendizaje por refuerzo para lograr un razonamiento a largo plazo, y desarrollar continuamente modelos básicos optimizados para el aprendizaje por refuerzo, con el objetivo final de lograr la inteligencia artificial general (AGI).

Modelo:https://qwenlm.github.io/blog/qwq-32b/

Puntos clave:

🚀 Alibaba lanza el modelo de inferencia a gran escala de código abierto QwQ-32B, que utiliza la técnica de aprendizaje por refuerzo para mejorar la capacidad de resolución de problemas complejos.

💡 QwQ-32B muestra un rendimiento comparable a modelos con mayor número de parámetros en pruebas de referencia matemáticas y de programación, con una menor necesidad de memoria, y se publica bajo la licencia Apache2.0, permitiendo su uso comercial gratuito.

🧠 Este modelo cuenta con una longitud de contexto extendida (130.000 tokens) y capacidades agentivas, y en el futuro se seguirá explorando el potencial del aprendizaje por refuerzo para mejorar la inteligencia del modelo.