Pesquisadores da Meta, em colaboração com a Universidade de Waterloo, lançaram recentemente um novo sistema de IA chamado MoCha, capaz de gerar personagens animados completos com voz sincronizada e movimentos naturais a partir de simples descrições de texto. Essa tecnologia inovadora promete aumentar significativamente a eficiência e a expressividade na criação de conteúdo, apresentando um enorme potencial de aplicação em diversas áreas.

Quebrando paradigmas: animação completa e sincronia labial precisa

Diferentemente dos modelos de IA anteriores que se concentravam principalmente em expressões faciais, o MoCha se destaca por sua capacidade de renderizar movimentos naturais do corpo inteiro. Seja em close ou meia distância, o sistema gera movimentos detalhados com base no conteúdo textual, incluindo sincronia labial, gestos e interação entre múltiplos personagens. As demonstrações iniciais focaram na parte superior do corpo, mostrando como o sistema alinha precisamente a boca do personagem com o diálogo, e como a linguagem corporal se harmoniza naturalmente com o significado do texto.

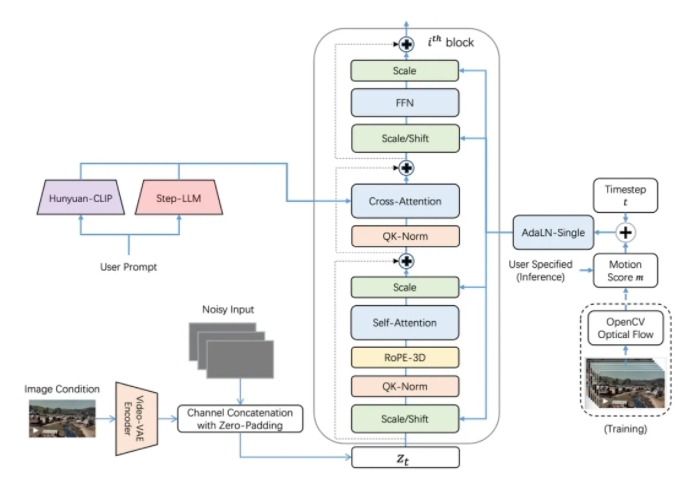

Para alcançar uma sincronia labial mais precisa, a equipe de pesquisa introduziu de forma inovadora o mecanismo de “atenção da janela áudio-vídeo”. Esse mecanismo resolve eficazmente dois desafios de longa data na geração de vídeos por IA: a compressão de informações durante o processamento de vídeo enquanto se mantém a resolução completa de áudio, e o desalinhamento labial comum na geração paralela de vídeos. O princípio básico é limitar o acesso de cada quadro a dados de áudio dentro de uma janela específica. Esse método imita a forma como os humanos processam a fala – os movimentos da boca dependem do som imediato, enquanto a linguagem corporal acompanha padrões textuais mais amplos. Ao adicionar marcadores antes e depois de cada segmento de áudio, o MoCha gera transições mais suaves e sincronia labial mais precisa.

Gerenciamento fácil de múltiplos personagens, sistema de prompts simples e eficiente

Para lidar com cenas com vários personagens, a equipe do MoCha desenvolveu um sistema de prompts simples e eficiente. O usuário precisa definir as informações do personagem apenas uma vez e pode então referenciá-los em diferentes cenários usando tags simples (como ‘Personagem1’, ‘Personagem2’). Esse método evita a descrição repetitiva dos personagens, tornando a criação de animações com múltiplos personagens mais conveniente.

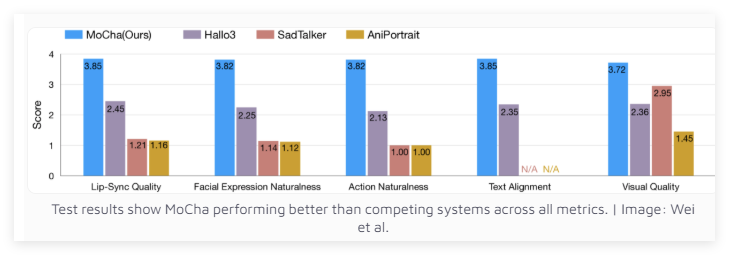

Desempenho excepcional, superando sistemas similares

Após testes em 150 cenários diferentes, o MoCha superou sistemas similares em termos de sincronia labial e qualidade de movimentos naturais. Avaliadores independentes elogiaram o realismo dos vídeos gerados pelo MoCha. Os resultados dos testes mostraram que o MoCha superou seus concorrentes em todos os indicadores.

A equipe de pesquisa da Meta acredita que o MoCha apresenta um enorme potencial de aplicação em áreas como assistentes digitais, avatares virtuais, publicidade e conteúdo educacional. No entanto, a Meta ainda não revelou se o sistema será de código aberto ou se permanecerá como um protótipo de pesquisa. É importante notar que o desenvolvimento do MoCha ocorre em um momento crucial em que grandes empresas de mídia social estão competindo para desenvolver tecnologias de vídeo impulsionadas por IA.

Anteriormente, a Meta já lançou o MovieGen, enquanto a ByteDance, empresa-mãe do TikTok, também está ativamente desenvolvendo seu próprio sistema de animação por IA, incluindo INFP, OmniHuman-1 e Goku. Essa corrida na área de tecnologia de vídeo por IA certamente acelerará o progresso e a adoção dessas tecnologias.

Acesso ao projeto: https://top.aibase.com/tool/mocha