O renomado laboratório chinês de pesquisa em inteligência artificial, DeepSeek AI, após seu poderoso modelo de linguagem de código aberto DeepSeek-R1, alcançou mais uma grande conquista na área de modelos de linguagem de grande porte (LLM). Recentemente, a DeepSeek AI lançou oficialmente uma tecnologia inovadora chamada de ajuste de crítica auto-orientada por princípios (Self-Principled Critique Tuning, ou SPCT), com o objetivo de construir modelos de recompensa de IA (Reward Models, ou RMs) mais gerais e escaláveis. Essa tecnologia promete melhorar significativamente a capacidade de compreensão e resposta da IA em tarefas abertas e ambientes complexos, preparando o caminho para aplicações de IA mais inteligentes.

Contexto: Modelos de Recompensa — o "farol" do aprendizado por reforço

No desenvolvimento de LLMs avançados, o aprendizado por reforço (Reinforcement Learning, ou RL) tornou-se uma tecnologia essencial. O RL utiliza sinais de feedback para orientar o ajuste fino do modelo, permitindo que ele gere respostas de maior qualidade. Neste processo, os modelos de recompensa desempenham um papel crucial, atuando como "árbitros", responsáveis por avaliar a saída do LLM e atribuir pontuações ou "recompensas" correspondentes. Esses sinais de recompensa orientam eficazmente o processo de RL, incentivando o LLM a aprender a gerar conteúdo mais útil.

No entanto, os modelos de recompensa atuais também enfrentam diversas limitações. Eles geralmente se destacam em áreas estreitas com regras claras ou respostas fáceis de verificar, como o excelente desempenho de modelos como o DeepSeek-R1 em problemas de matemática e programação, que se beneficiam de "respostas corretas" bem definidas nesses domínios. Entretanto, para consultas em domínios gerais complexos, abertos ou altamente subjetivos, construir um modelo de recompensa eficaz ainda representa um grande desafio. Os pesquisadores da DeepSeek AI apontam em seu artigo: "Modelos de recompensa gerais precisam gerar recompensas de alta qualidade além de domínios específicos, onde os padrões de recompensa são mais diversos e complexos, e frequentemente não há respostas ou padrões de referência claros."

SPCT: Enfrentando quatro desafios para criar modelos de recompensa gerais

Para superar as limitações dos modelos de recompensa existentes, os pesquisadores da DeepSeek AI propuseram a nova tecnologia SPCT. Eles destacaram quatro desafios-chave para a construção de modelos de recompensa gerais:

- Flexibilidade de entrada (Input flexibility): Os modelos de recompensa devem ser capazes de lidar com diversos tipos de entrada e avaliar simultaneamente uma ou mais respostas.

- Precisão (Accuracy): Em diversos domínios complexos e sem respostas claras, os modelos de recompensa devem gerar sinais de recompensa precisos.

- Escalabilidade em tempo de inferência (Inference-time scalability): Ao alocar mais recursos computacionais para inferência, o modelo de recompensa deve gerar recompensas de maior qualidade.

- Aprendizagem de comportamentos escaláveis (Learning scalable behaviors): Para que os modelos de recompensa sejam eficazes na expansão durante a inferência, eles precisam aprender comportamentos que melhorem o desempenho com o aumento dos recursos computacionais.

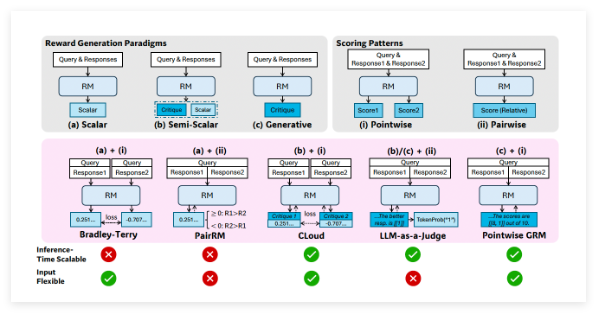

Os pesquisadores observam que a "modelagem de recompensa generativa pontual" (Pointwise Generative Reward Modeling, ou GRM), ou seja, o método em que o modelo gera comentários de texto e extrai pontuações a partir deles, pode fornecer a flexibilidade e escalabilidade necessárias para tarefas gerais. Experimentos iniciais da equipe DeepSeek em modelos como GPT-4o e Gemma-2-27B sugeriram que "certos princípios podem orientar os modelos de recompensa generativos a gerar recompensas dentro de padrões apropriados, melhorando a qualidade da recompensa", o que os inspirou a explorar a possibilidade de alcançar a escalabilidade em tempo de inferência expandindo a geração de princípios e comentários de alta qualidade.

O mecanismo central do SPCT: princípios auto-orientados e ajuste de crítica

Com base nessas descobertas, a equipe DeepSeek desenvolveu a tecnologia SPCT, que treina o GRM para gerar princípios e comentários dinamicamente com base na consulta e na resposta. Os pesquisadores argumentam que os princípios devem ser "parte da geração da recompensa, e não um passo de pré-processamento". Dessa forma, o GRM pode gerar princípios instantaneamente de acordo com a tarefa que está avaliando e, em seguida, gerar comentários críticos com base nesses princípios.

O SPCT consiste em duas etapas principais:

- Ajuste fino rejeitante (Rejective fine-tuning): Nesta etapa, o GRM é treinado para gerar princípios e comentários em formato correto para diversos tipos de entrada. O modelo gera princípios, comentários e recompensas para uma consulta/resposta dada. Somente as trajetórias geradas em que a recompensa prevista coincide com a realidade (por exemplo, a identificação correta da melhor resposta) são aceitas; caso contrário, são rejeitadas. Esse processo é repetido, e o modelo é ajustado finamente nos exemplos filtrados para melhorar sua capacidade de geração de princípios/comentários.

- Aprendizado por reforço baseado em regras (Rule-based RL): Nesta etapa, o modelo é ajustado finamente por meio de aprendizado por reforço baseado em resultados. O GRM gera princípios e comentários para cada consulta, e o sinal de recompensa é calculado com base em regras simples de precisão (por exemplo, se a melhor resposta conhecida foi selecionada). O modelo é então atualizado para incentivar o GRM a aprender a gerar princípios eficazes e comentários precisos de forma dinâmica e escalável.

Para lidar com o desafio da escalabilidade em tempo de inferência, os pesquisadores executam o GRM várias vezes na mesma entrada, gerando diferentes conjuntos de princípios e comentários. A recompensa final é determinada por votação (agregação das pontuações das amostras). Isso permite que o modelo considere perspectivas mais amplas, gerando julgamentos mais precisos e detalhados com mais recursos.

Além disso, para resolver o problema de alguns princípios/comentários gerados apresentarem baixa qualidade ou vieses, os pesquisadores introduziram um "modelo de recompensa meta" (meta RM) — um RM escalar separado e leve, especializado em prever se os princípios/comentários gerados pelo GRM principal podem levar a uma recompensa final correta. Durante a inferência, o meta RM avalia as amostras geradas e filtra os julgamentos de baixa qualidade, melhorando ainda mais o desempenho de escalabilidade.

O desempenho excepcional do DeepSeek-GRM

Os pesquisadores aplicaram o SPCT ao modelo de código aberto Gemma-2-27B do Google, criando o DeepSeek-GRM-27B. Em vários testes de referência, eles o compararam com vários RMs de linha de base robustos (incluindo LLM-as-a-Judge, RM escalar e RM semi-escalar) e modelos públicos (como GPT-4o e Nemotron-4-340B-Reward). Os resultados mostraram que o DeepSeek-GRM-27B superou os métodos de linha de base treinados nos mesmos dados.

Em comparação com o ajuste fino padrão, o SPCT melhorou significativamente a qualidade da recompensa e, mais importante, a escalabilidade em tempo de inferência. Ao expandir a inferência gerando mais amostras, o desempenho do DeepSeek-GRM-27B aumentou consideravelmente, superando até mesmo modelos maiores, como Nemotron-4-340B-Reward e GPT-4o. A introdução do meta RM melhorou ainda mais a escalabilidade, alcançando os melhores resultados por meio da filtragem de julgamentos. Os pesquisadores observam: "Com amostras em maior escala, o DeepSeek-GRM pode fazer julgamentos mais precisos com base em princípios mais diversos e gerar recompensas mais refinadas". Curiosamente, em comparação com os RMs escalares que se saem bem em tarefas verificáveis, mas mal em outros aspectos, o SPCT apresentou menos vieses em diferentes domínios.

O desenvolvimento de modelos de recompensa mais gerais e escaláveis apresenta amplas perspectivas para aplicações de IA em nível empresarial. Áreas potenciais de benefício incluem tarefas criativas e aplicações em que o modelo precisa se adaptar a ambientes dinâmicos (como preferências de clientes em constante mudança).

Apesar dos resultados notáveis, o DeepSeek-GRM ainda apresenta desafios em termos de desempenho em tarefas puramente verificáveis e eficiência em comparação com RMs não generativos. A equipe DeepSeek afirma que os trabalhos futuros se concentrarão em melhorar a eficiência e a integração mais profunda. Eles concluem: "Direções futuras podem incluir a integração do GRM em fluxos de RL online como uma interface geral para sistemas de recompensa, explorar a expansão colaborativa em tempo de inferência com modelos de estratégia ou como um avaliador offline robusto para modelos básicos."

Artigo: https://arxiv.org/abs/2504.02495