La aclamada empresa china de inteligencia artificial Moonshot AI (月之暗面) anunció recientemente el lanzamiento de código abierto de dos nuevos modelos de lenguaje visual: Kimi-VL y Kimi-VL-Thinking. Estos modelos, con su arquitectura ligera y su extraordinaria capacidad de comprensión e inferencia multimodal, han superado a numerosos modelos grandes, incluido GPT-4o, en varias pruebas de referencia clave, generando un gran interés en la industria.

Un cuerpo ligero, una potencia inmensa

A diferencia de los modelos principales que suelen tener cientos de miles de millones o incluso billones de parámetros, Kimi-VL y Kimi-VL-Thinking utilizan una arquitectura MoE (Mixture-of-Experts, mezcla de expertos), con aproximadamente 3.000 millones de parámetros activados. Esto significa que son más eficientes en su ejecución e implementación, requiriendo menos recursos computacionales. Sorprendentemente, a pesar de esta arquitectura ligera, ambos modelos han obtenido excelentes resultados en varias pruebas de referencia, demostrando su potente capacidad de inferencia.

Inteligencia multimodal mejorada: destacada actuación en razonamiento matemático y manipulación de agentes

Los modelos de la serie Kimi-VL destacan en la inferencia multimodal y la capacidad de los agentes. En la prueba de referencia MathVision, que evalúa la capacidad de razonamiento matemático multimodal del modelo, Kimi-VL obtuvo una puntuación del 36,8%, un resultado comparable al de modelos grandes con un número de parámetros diez veces superior.

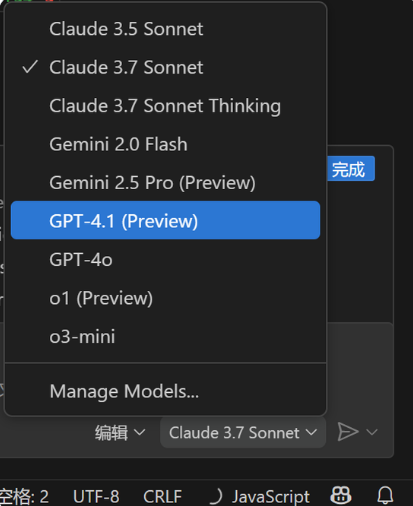

Aún más impresionante es su puntuación del 34,5% en la tarea ScreenSpot-Pro, que evalúa la capacidad de manipulación de agentes. Esto demuestra el excelente potencial del modelo para comprender interfaces de usuario complejas y realizar las operaciones correspondientes, sentando las bases para el desarrollo futuro de aplicaciones de interacción humano-computadora más inteligentes.

Visión de alta definición: compatibilidad nativa con el procesamiento de imágenes de alta resolución

Gracias a la arquitectura MoonViT, los modelos de la serie Kimi-VL poseen una potente capacidad de reconocimiento y comprensión de imágenes y texto. En la prueba de referencia OCRBench, obtuvo una puntuación de 867, lo que demuestra su excelente rendimiento en el procesamiento de imágenes de alta resolución y el reconocimiento de texto complejo. Esta característica es crucial para aplicaciones que manejan una gran cantidad de información de imágenes y documentos.

Memoria a largo plazo: manejo sencillo de la comprensión de contextos largos

La capacidad de comprensión de contextos largos es otro punto destacado de los modelos de la serie Kimi-VL. Admiten entradas de contexto de hasta 128.000 tokens. Esto significa que el modelo puede procesar simultáneamente información compleja y extensa, como documentos largos o vídeos, y realizar una comprensión y un análisis más profundos.

En la prueba de comprensión de documentos largos MMLongBench-Doc, Kimi-VL obtuvo una puntuación del 35,1%, mientras que en la prueba de comprensión de vídeos largos LongVideoBench alcanzó una alta puntuación del 64,5%. Esto hace que los modelos de la serie Kimi-VL tengan un enorme potencial de aplicación en escenarios como respuestas a preguntas sobre documentos, análisis de vídeos, etc., que requieren el procesamiento de una gran cantidad de información contextual.

Código abierto y compartido, creando juntos el futuro de la inteligencia multimodal

Moonshot AI destaca que el lanzamiento de código abierto de Kimi-VL y Kimi-VL-Thinking es solo un pequeño paso hacia la inteligencia multimodal general. Esperan atraer a más desarrolladores de la comunidad para que participen en el desarrollo de aplicaciones del modelo a través del código abierto, explorando juntos las infinitas posibilidades de los modelos de la serie Kimi-VL en áreas como respuestas a preguntas sobre documentos, manipulación de interfaces, comprensión de imágenes y texto y análisis de vídeo.

Actualmente, los desarrolladores pueden obtener información y código de los modelos de la serie Kimi-VL de las siguientes maneras:

GitHub: https://github.com/MoonshotAI/Kimi-VL

https://huggingface.co/moonshotai/Kimi-VL-A3B-Instruct