Le laboratoire de recherche chinois sur l'intelligence artificielle DeepSeek AI, très attendu, a réalisé une nouvelle percée majeure dans le domaine des grands modèles de langage (LLM), après son puissant modèle linguistique open source DeepSeek-R1. Récemment, DeepSeek AI a officiellement lancé une technologie innovante appelée "auto-critique par principes" (Self-Principled Critique Tuning, ou SPCT), visant à construire des modèles de récompense (Reward Models, ou RM) plus universels et plus évolutifs. Cette technologie devrait améliorer considérablement la capacité de l'IA à comprendre et à répondre aux tâches ouvertes et aux environnements complexes, ouvrant la voie à des applications d'IA plus intelligentes.

Contexte : les modèles de récompense – le « phare » de l'apprentissage par renforcement

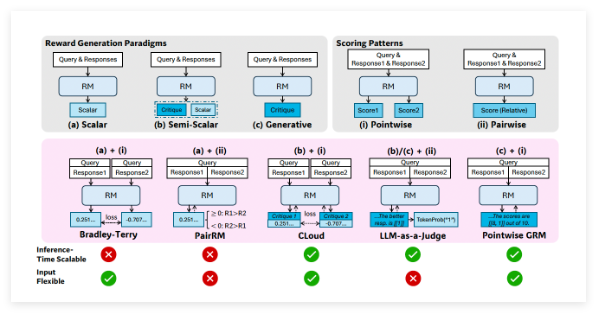

Dans le développement de LLM avancés, l'apprentissage par renforcement (Reinforcement Learning, ou RL) est devenu une technologie clé. Le RL utilise des signaux de rétroaction pour guider l'ajustement fin du modèle, lui permettant de générer des réponses de meilleure qualité. Dans ce processus, les modèles de récompense jouent un rôle crucial, agissant comme un « arbitre » qui évalue la sortie du LLM et attribue un score ou une « récompense » correspondante. Ces signaux de récompense guident efficacement le processus de RL, incitant le LLM à apprendre à produire un contenu plus utile.

Cependant, les modèles de récompense actuels présentent de nombreuses limitations. Ils excellent souvent dans des domaines étroits où les règles sont claires ou où les réponses sont faciles à vérifier. Par exemple, les excellentes performances de modèles comme DeepSeek-R1 en mathématiques et en programmation sont dues à des « bonnes réponses » clairement définies pour ce type de problèmes. Pourtant, pour les requêtes générales complexes, ouvertes ou fortement subjectives, la construction d'un modèle de récompense efficace reste un défi majeur. Les chercheurs de DeepSeek AI soulignent dans leur article : « Les modèles de récompense universels doivent générer des récompenses de haute qualité en dehors de domaines spécifiques, où les critères de récompense sont plus variés et complexes, et souvent sans référence ou réponse standard claire. »

SPCT : relever quatre défis pour créer un modèle de récompense universel

Pour surmonter les limites des modèles de récompense existants, les chercheurs de DeepSeek AI ont proposé la nouvelle technologie SPCT. Ils ont mis en évidence quatre défis clés à relever pour construire un modèle de récompense universel :

- Flexibilité de l'entrée (Input flexibility) : le modèle de récompense doit pouvoir traiter différents types d'entrées et évaluer simultanément une ou plusieurs réponses.

- Précision (Accuracy) : dans divers domaines complexes et standardisés, sans réponse claire, le modèle de récompense doit pouvoir générer des signaux de récompense précis.

- Évolutivité au moment de l'inférence (Inference-time scalability) : lorsque davantage de ressources de calcul sont allouées à l'inférence, le modèle de récompense doit pouvoir produire des récompenses de meilleure qualité.

- Apprentissage de comportements évolutifs (Learning scalable behaviors) : pour que les modèles de récompense soient efficaces à l'inférence, ils doivent apprendre des comportements dont les performances s'améliorent avec l'augmentation des ressources de calcul.

Les chercheurs indiquent que la « modélisation de récompense générative ponctuelle » (Pointwise Generative Reward Modeling, GRM), c'est-à-dire la méthode consistant à générer des commentaires textuels par le modèle et à en extraire des scores, peut fournir la flexibilité et l'évolutivité nécessaires aux tâches universelles. Les expériences préliminaires de l'équipe DeepSeek sur des modèles tels que GPT-4o et Gemma-2-27B montrent que « certains principes peuvent guider les modèles de récompense génératifs pour produire des récompenses dans des limites appropriées, améliorant ainsi la qualité des récompenses », ce qui les a inspirés à penser qu'il est possible d'améliorer l'évolutivité au moment de l'inférence des modèles de récompense en étendant la génération de principes de haute qualité et de commentaires précis.

Mécanisme central de SPCT : auto-critique par principes et ajustement fin critique

Sur la base de ces découvertes, l'équipe DeepSeek a développé la technologie SPCT, qui entraîne le GRM à générer dynamiquement des principes et des commentaires en fonction de la requête et de la réponse. Les chercheurs estiment que les principes devraient « faire partie de la génération de récompenses, et non une étape de prétraitement ». De cette façon, le GRM peut générer des principes instantanément en fonction de la tâche qu'il évalue, puis générer des commentaires critiques basés sur ces principes.

SPCT comporte deux phases principales :

- Ajustement fin réjectif (Rejective fine-tuning) : cette phase entraîne le GRM à générer des principes et des commentaires au format correct pour différents types d'entrées. Le modèle génère des principes, des commentaires et des récompenses pour une requête/réponse donnée. Seules les trajectoires dont la récompense prédite correspond à la réalité (par exemple, identification correcte de la meilleure réponse) sont acceptées, sinon elles sont rejetées. Ce processus est répété, et le modèle est ajusté finement sur les exemples filtrés pour améliorer sa capacité de génération de principes/commentaires.

- Apprentissage par renforcement basé sur les règles (Rule-based RL) : dans cette phase, le modèle est affiné davantage par un apprentissage par renforcement basé sur les résultats. Le GRM génère des principes et des commentaires pour chaque requête, et le signal de récompense est calculé sur la base de règles de précision simples (par exemple, si la meilleure réponse connue a été sélectionnée). Le modèle est ensuite mis à jour pour encourager le GRM à apprendre à générer dynamiquement et de manière évolutive des principes efficaces et des commentaires précis.

Pour relever le défi de l'évolutivité au moment de l'inférence, les chercheurs exécutent plusieurs fois le GRM sur la même entrée, générant différents ensembles de principes et de commentaires. La récompense finale est déterminée par un vote (agrégation des scores des échantillons). Cela permet au modèle de prendre en compte un éventail de perspectives plus large, produisant ainsi un jugement final plus précis et nuancé lorsqu'il dispose de plus de ressources.

De plus, pour résoudre le problème de la qualité potentiellement médiocre ou des biais de certains principes/commentaires générés, les chercheurs ont introduit un « méta-modèle de récompense » (méta-RM) – un RM scalaire distinct et léger, spécialement conçu pour prédire si les principes/commentaires générés par le GRM principal sont susceptibles de conduire à une récompense finale correcte. Pendant l'inférence, le méta-RM évalue les échantillons générés et filtre les jugements de mauvaise qualité, améliorant ainsi les performances d'évolutivité.

Performances exceptionnelles de DeepSeek-GRM

Les chercheurs ont appliqué SPCT au modèle open source Gemma-2-27B de Google, créant DeepSeek-GRM-27B. Dans plusieurs tests de référence, ils l'ont évalué par rapport à plusieurs RM de référence puissants (y compris LLM-as-a-Judge, RM scalaire et RM semi-scalaire) ainsi qu'à des modèles publics (tels que GPT-4o et Nemotron-4-340B-Reward). Les résultats montrent que DeepSeek-GRM-27B surpasse les méthodes de référence entraînées sur les mêmes données.

Par rapport à l'ajustement fin standard, SPCT améliore considérablement la qualité des récompenses et, plus important encore, l'évolutivité au moment de l'inférence. En étendant l'inférence par la génération de plus d'échantillons, les performances de DeepSeek-GRM-27B augmentent considérablement, dépassant même des modèles plus grands tels que Nemotron-4-340B-Reward et GPT-4o. L'introduction du méta-RM améliore encore l'évolutivité, en filtrant les jugements pour obtenir les meilleurs résultats. Les chercheurs soulignent : « Grâce à un échantillonnage à plus grande échelle, DeepSeek-GRM peut prendre des décisions plus précises basées sur des principes plus variés et produire des récompenses plus fines. » Il est intéressant de noter que, contrairement aux RM scalaires qui fonctionnent bien sur les tâches vérifiables mais moins bien ailleurs, SPCT présente moins de biais dans différents domaines.

Le développement de modèles de récompense plus universels et évolutifs offre de vastes perspectives pour les applications d'IA d'entreprise. Les domaines susceptibles d'en bénéficier comprennent les tâches créatives et les applications où le modèle doit s'adapter à des environnements dynamiques (comme les préférences changeantes des clients).

Malgré les résultats remarquables, DeepSeek-GRM présente encore des défis en termes de performances et d'efficacité sur des tâches purement vérifiables par rapport aux RM non génératifs. L'équipe DeepSeek indique que les travaux futurs se concentreront sur l'amélioration de l'efficacité et une intégration plus approfondie. Ils concluent : « Les orientations futures pourraient inclure l'intégration du GRM dans les processus RL en ligne, comme interface universelle pour les systèmes de récompense, l'exploration de l'évolutivité coopérative au moment de l'inférence avec les modèles de stratégie, ou comme évaluateur hors ligne robuste pour les modèles de base. »

Article : https://arxiv.org/abs/2504.02495