हाल ही में, चीनी विज्ञान अकादमी के स्वचालन संस्थान और चीन के विज्ञान ज़ीदोंग ताइचू टीम ने मिलकर एक नई विधि विकसित की है - Vision-R1, जो R1-जैसे प्रबलित अधिगम तकनीक का उपयोग करके दृश्य स्थान निर्धारण की क्षमता में उल्लेखनीय रूप से सुधार करती है। यह विधि न केवल लक्ष्य पहचान और दृश्य स्थान निर्धारण जैसे जटिल कार्यों में 50% का प्रदर्शन सुधार हासिल करती है, बल्कि 10 गुना से अधिक पैरामीटर वाले मौजूदा सर्वोत्तम मॉडल (SOTA) को भी पार कर जाती है।

वर्तमान में, ग्राफ़िक्स और टेक्स्ट बड़े मॉडल आमतौर पर उपयोगकर्ता निर्देशों के प्रति प्रतिक्रिया क्षमता में सुधार के लिए "पूर्व-प्रशिक्षण + पर्यवेक्षित ठीक-ट्यूनिंग" विधि पर निर्भर करते हैं, लेकिन इस विधि में संसाधन खपत और प्रशिक्षण दक्षता के मामले में बड़ी चुनौतियाँ हैं। Vision-R1 उच्च-गुणवत्ता वाले निर्देश संरेखण डेटा और प्रबलित अधिगम को जोड़कर, इस स्थिति को नवीन रूप से बदलता है। यह विधि एक दृश्य कार्य मूल्यांकन-संचालित पुरस्कार तंत्र को डिज़ाइन करके मॉडल की लक्ष्य स्थान निर्धारण क्षमता के लिए एक मजबूत समर्थन प्रदान करती है।

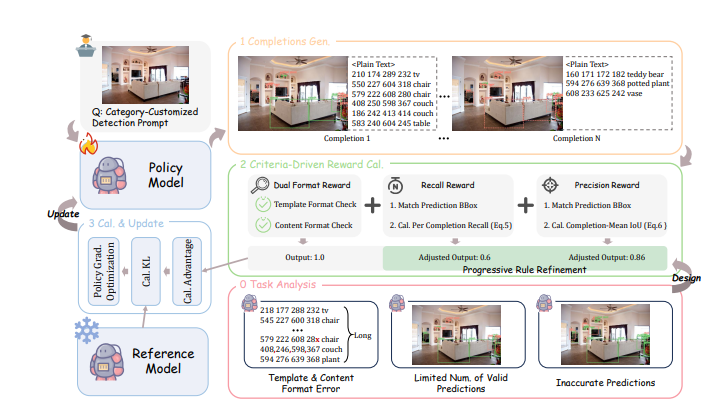

विशिष्ट रूप से, Vision-R1 के पुरस्कार तंत्र में चार मुख्य भाग शामिल हैं: सबसे पहले, यह भारी दृश्यों में भविष्यवाणी की गुणवत्ता का प्रभावी ढंग से मूल्यांकन करने के लिए बहु-लक्ष्य भविष्यवाणी का उपयोग करता है; दूसरा, लंबी श्रृंखला की भविष्यवाणियों में प्रारूप त्रुटियों को हल करने के लिए दोहरे प्रारूप पुरस्कार डिज़ाइन किए गए हैं; तीसरा, रिकॉल पुरस्कार मॉडल को यथासंभव अधिक लक्ष्यों की पहचान करने के लिए प्रोत्साहित करता है; अंत में, सटीकता पुरस्कार यह सुनिश्चित करता है कि मॉडल द्वारा उत्पन्न लक्ष्य बॉक्स की गुणवत्ता अधिक हो। ये डिज़ाइन एक दूसरे के साथ बातचीत करते हैं, जिससे "1+1>2" का अनुकूलन प्रभाव बनता है, जिससे मॉडल जटिल दृश्य कार्यों में बेहतर प्रदर्शन करता है।

उच्च-गुणवत्ता वाले लक्ष्य बॉक्स की भविष्यवाणी करने की चुनौती को हल करने के लिए, शोध दल ने एक क्रमिक नियम समायोजन रणनीति भी प्रस्तावित की है, जो पुरस्कार गणना नियमों को गतिशील रूप से समायोजित करके मॉडल को लगातार अपने प्रदर्शन में सुधार करने के लिए प्रोत्साहित करती है। प्रशिक्षण प्रक्रिया को शुरुआती चरण और उन्नत चरण में विभाजित किया गया है, जो धीरे-धीरे पुरस्कार मानकों को बढ़ाता है, ताकि बुनियादी से उच्च सटीकता तक संक्रमण किया जा सके।

कई परीक्षणों में, Vision-R1 ने क्लासिक लक्ष्य पहचान डेटासेट COCO और विविध दृश्यों के ODINW-13 पर उत्कृष्ट प्रदर्शन दिखाया है, चाहे बुनियादी प्रदर्शन कुछ भी हो, Vision-R1 प्रशिक्षण के बाद मॉडल का प्रदर्शन काफी बढ़ गया है, जो पेशेवर स्थान निर्धारण मॉडल के करीब है। यह विधि न केवल ग्राफ़िक्स और टेक्स्ट बड़े मॉडल की दृश्य स्थान निर्धारण क्षमता में प्रभावी रूप से सुधार करती है, बल्कि भविष्य के बहु-मोडल AI अनुप्रयोगों के लिए नई दिशाएँ भी प्रदान करती है।

परियोजना पता:https://github.com/jefferyZhan/Griffon/tree/master/Vision-R1