O laboratório francês de pesquisa em IA sem fins lucrativos Kyutai lançou um assistente de voz chamado Moshi, um modelo básico multimodal nativo em tempo real revolucionário. Este modelo inovador imita e, em alguns aspectos, supera funcionalidades demonstradas pelo GPT-4o da OpenAI, lançado em maio.

Acesso ao produto:https://top.aibase.com/tool/moshi-chat

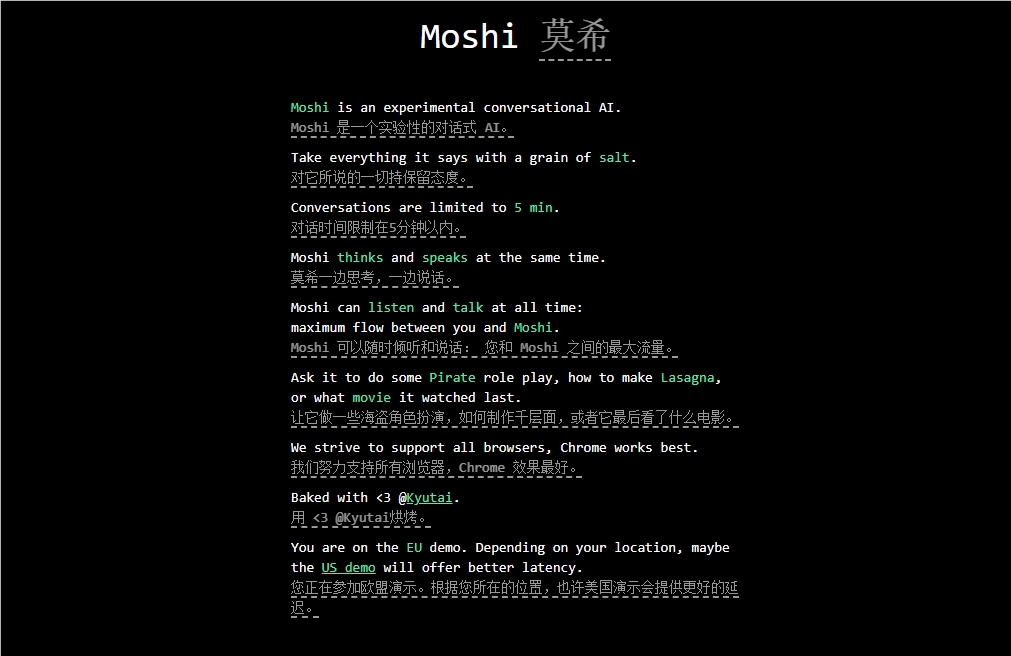

O Moshi foi projetado para entender e expressar emoções, com a capacidade de conversar usando diferentes sotaques (incluindo francês). Ele pode ouvir e gerar áudio e voz simultaneamente, mantendo uma comunicação fluida de pensamento textual. Segundo informações, o Moshi possui diversas emoções semelhantes às humanas, podendo falar com 70 emoções e estilos diferentes.

Um destaque do Moshi é sua capacidade de processar dois fluxos de áudio simultaneamente, permitindo que ele ouça e fale ao mesmo tempo. Essa interação em tempo real é baseada em pré-treinamento conjunto de texto e áudio mistos, utilizando dados de texto sintético do modelo de linguagem de 7 bilhões de parâmetros Helium, desenvolvido pela Kyutai.

O processo de ajuste fino do Moshi envolveu 100.000 diálogos sintéticos de "estilo coloquial" convertidos por meio de tecnologia de texto para fala (TTS). A voz do modelo foi treinada com dados sintéticos gerados por outro modelo TTS, alcançando um tempo de latência impressionante de 200 milissegundos.

Vale ressaltar que a Kyutai também desenvolveu uma variante menor do Moshi, que pode ser executada em um MacBook ou GPU de nível consumidor, tornando-o acessível a uma gama mais ampla de usuários.

Destaques: 🔍 A Kyutai lançou o Moshi, um modelo de IA básico multimodal nativo em tempo real.

🔍 O Moshi possui a capacidade de entender e expressar emoções e suporta vários sotaques.

🔍 O modelo passou por um rigoroso processo de ajuste fino e treinamento, demonstrando desempenho eficiente e potencial para diversas aplicações.