Em maio, a IBM lançou o modelo LLM Granite13B de código aberto, projetado para aplicações empresariais. Agora, Armand Ruiz, vice-presidente de produtos da plataforma de IA da IBM, divulgou o conteúdo completo do conjunto de dados abrangente de 6,48 TB usado para treinar o Granite13B.

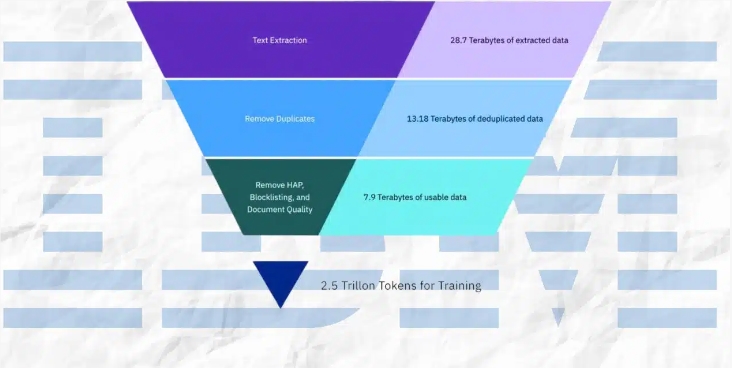

Após um rigoroso pré-processamento, este conjunto de dados foi reduzido para 2,07 TB, representando uma diminuição de 68%. Ruiz destaca que esta etapa é crucial para garantir um conjunto de dados de alta qualidade, isento de vieses, ético e legal, atendendo às necessidades de aplicações empresariais.

O conjunto de dados foi cuidadosamente elaborado a partir de diversas fontes, incluindo:

- arXiv: Mais de 2,4 milhões de pré-impressões de artigos científicos.

- Common Crawl: Um banco de dados de rastreamento da web aberto.

- DeepMind Mathematics: Pares de perguntas e respostas matemáticas.

- Free Law: Pareceres jurídicos de domínio público de tribunais americanos.

- GitHub Clean: Dados de código do CodeParrot.

- Hacker News: Notícias de ciência da computação e empreendedorismo de 2007 a 2018.

- OpenWeb Text: Uma versão de código aberto do corpus Web Text da OpenAI.

- Project Gutenberg (PG-19): Livros eletrônicos gratuitos, com foco em obras antigas.

- Pubmed Central: Artigos de biomedicina e ciências da vida.

- SEC Filings: Documentos de arquivamento 10-K/Q da Securities and Exchange Commission (SEC) dos EUA (1934-2022).

- Stack Exchange: Conteúdo contribuído pelo usuário da rede Stack Exchange.

- USPTO: Patentes americanas concedidas entre 1975 e maio de 2023.

- Webhose: Converte conteúdo da web não estruturado em dados legíveis por máquina.

- Wikimedia: Oito projetos Wikimedia em inglês.

O processo de pré-processamento incluiu extração de texto, remoção de duplicatas, identificação de idioma, segmentação de frases, rotulagem de ódio, abuso e palavrões, rotulagem de qualidade de documentos, rotulagem de mascaramento de URLs, filtragem e tokenização.

Essas etapas envolveram rotulagem e filtragem com base em limiares definidos, garantindo que o conjunto de dados final tenha a mais alta qualidade para o treinamento do modelo.

A IBM lançou quatro versões do modelo de código Granite, com parâmetros variando de 3 bilhões a 34 bilhões. Esses modelos foram testados em uma série de benchmarks e superaram outros modelos comparáveis, como Code Llama e Llama3, em várias tarefas.

Destaques:

⭐ A IBM lançou o conjunto de dados completo de 6,48 TB usado para treinar o modelo LLM Granite13B.

⭐ Após um rigoroso pré-processamento, o conjunto de dados foi reduzido para 2,07 TB, uma diminuição de 68%.

⭐ A IBM lançou quatro versões do modelo de código Granite, com parâmetros variando de 3 bilhões a 34 bilhões.