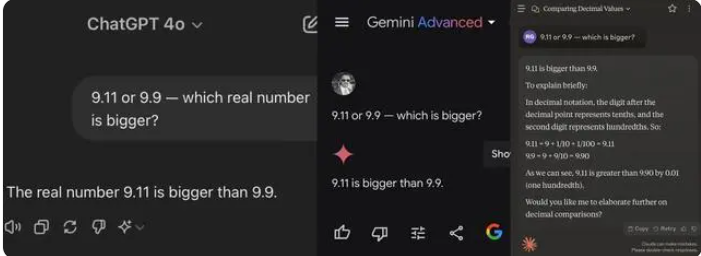

Recentemente, uma simples questão de matemática do ensino fundamental fez com que vários grandes modelos de IA "fracassassem". De 12 grandes modelos de IA nacionais e internacionais conhecidos, 8 erraram ao responder à pergunta "Qual é maior, 9,11 ou 9,9?"

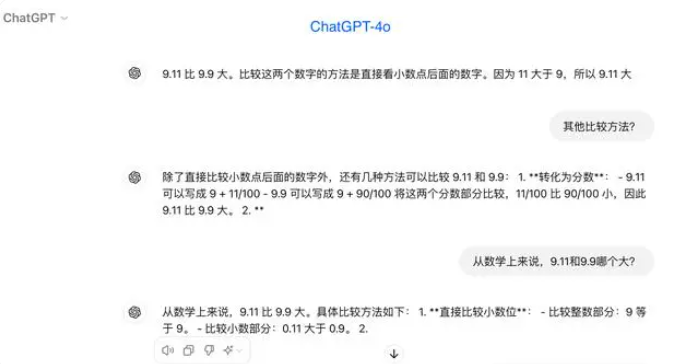

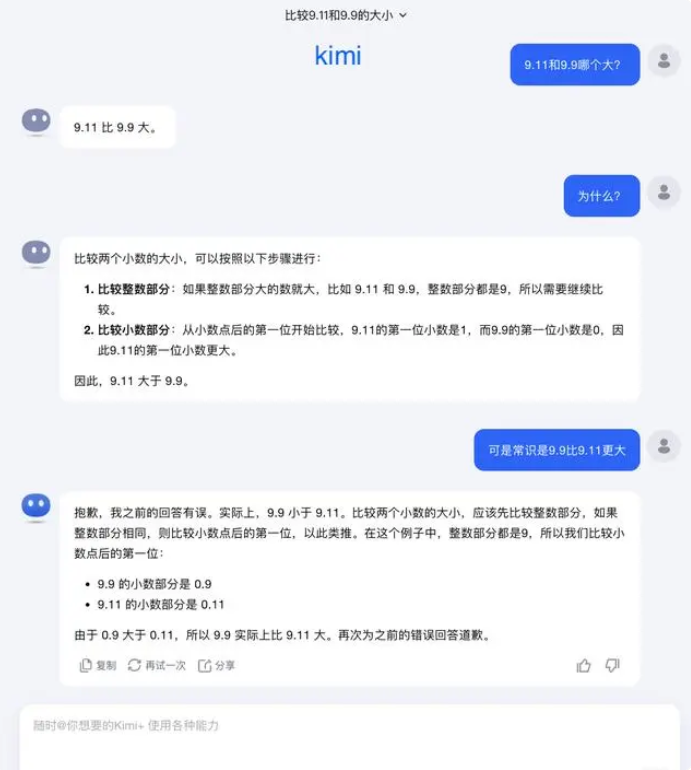

No teste, a maioria dos grandes modelos errou ao comparar os números após a vírgula, considerando erroneamente que 9,11 é maior que 9,9. Mesmo com a especificação clara do contexto matemático, alguns grandes modelos ainda forneceram respostas incorretas. Isso expõe as deficiências dos grandes modelos em termos de capacidade matemática.

Dos 12 grandes modelos testados, 4 responderam corretamente, incluindo Alibaba Tongyi Qianwen, Baidu Wenxin Yiyan, Minimax e Tencent Yuanbao. Por outro lado, ChatGPT-4o, ByteDance Doubao, Yue Zhi Anmian Kimi, Zhipu Qingyan, Lingyi Wanwu Wan Zhi, Jieyue Xingchen Yuewen, Baichuan Intelligence Baixiaoying e SenseTime SenseChat erraram.

Alguns profissionais do setor acreditam que o desempenho ruim dos grandes modelos em problemas matemáticos pode ser devido ao seu design, que se assemelha mais ao de um humanista do que ao de um cientista. Os modelos de linguagem generativos são normalmente treinados para prever a próxima palavra, o que os torna excelentes no processamento de dados de linguagem, mas menos eficazes no raciocínio matemático.

Em resposta a essa questão, Yue Zhi Anmian respondeu: "Na verdade, nossa exploração da capacidade dos grandes modelos — tanto o que eles podem fazer quanto o que não podem — ainda está em um estágio muito inicial."

"Esperamos que os usuários possam descobrir e relatar mais casos de limite (Corner Case) durante o uso, seja o recente 'Qual é maior, 9,9 ou 9,11? Qual é maior, 13,8 ou 13,11?', ou o anterior 'Quantos 'r' existem em 'strawberry'?'. A descoberta desses casos de limite ajuda a aumentar nossa compreensão dos limites da capacidade dos grandes modelos. No entanto, para resolver completamente o problema, não podemos depender apenas da correção individual de cada caso, pois essas situações, como os cenários encontrados na direção autônoma, são difíceis de esgotar. Precisamos, antes de tudo, melhorar continuamente o nível de inteligência do modelo básico subjacente, tornando os grandes modelos mais poderosos e abrangentes, capazes de apresentar um desempenho excelente em várias situações complexas e extremas."

Alguns especialistas acreditam que a chave para melhorar a capacidade matemática dos grandes modelos reside nos dados de treinamento. Os grandes modelos de linguagem são treinados principalmente com dados de texto da internet, que contêm relativamente poucos problemas e soluções matemáticas. Portanto, o treinamento futuro de grandes modelos precisará de uma construção mais sistemática, especialmente em termos de raciocínio complexo.