No mundo da inteligência artificial, os grandes modelos de linguagem (LLMs) são conhecidos por sua capacidade excepcional de processamento de linguagem natural. No entanto, a implantação desses modelos em aplicações reais enfrenta grandes desafios, principalmente devido ao alto custo computacional e consumo de memória na fase de inferência. Para resolver esse problema, os pesquisadores têm explorado maneiras de melhorar a eficiência dos LLMs. Recentemente, um método chamado Q-Sparse chamou a atenção.

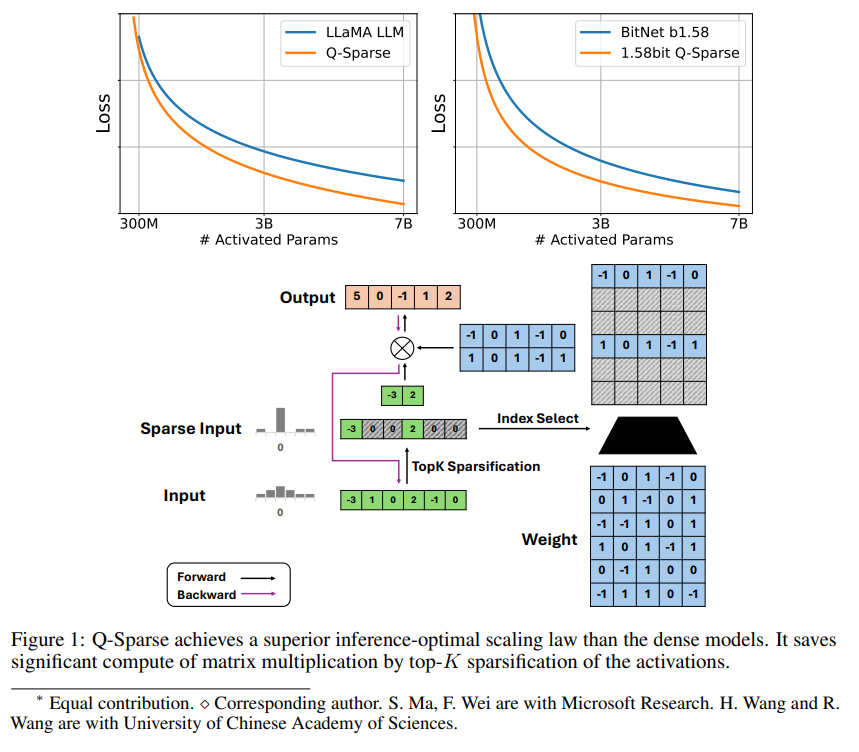

Q-Sparse é um método simples, mas eficaz, que alcança ativações totalmente esparsas em LLMs aplicando rarefação top-K nas ativações e um estimador de passagem direta durante o treinamento. Isso significa que a eficiência pode ser significativamente melhorada durante a inferência. Os principais resultados da pesquisa incluem:

Q-Sparse mantém resultados comparáveis aos LLMs de referência, com maior eficiência de inferência.

Propõe uma lei de escala ótima para inferência em LLMs com ativações esparsas.

Q-Sparse é eficaz em diferentes configurações, incluindo treinamento do zero, treinamento contínuo e ajuste fino de LLMs pré-treinados.

Q-Sparse é aplicável a LLMs de precisão total e de 1 bit (como BitNet b1.58).

Vantagens da ativação esparsa

A esparsidade melhora a eficiência dos LLMs de duas maneiras: primeiro, a esparsidade reduz a quantidade de cálculos de multiplicação de matrizes, pois os elementos zero não são computados; segundo, a esparsidade reduz a quantidade de transferência de entrada/saída (E/S), que é o principal gargalo na fase de inferência dos LLMs.

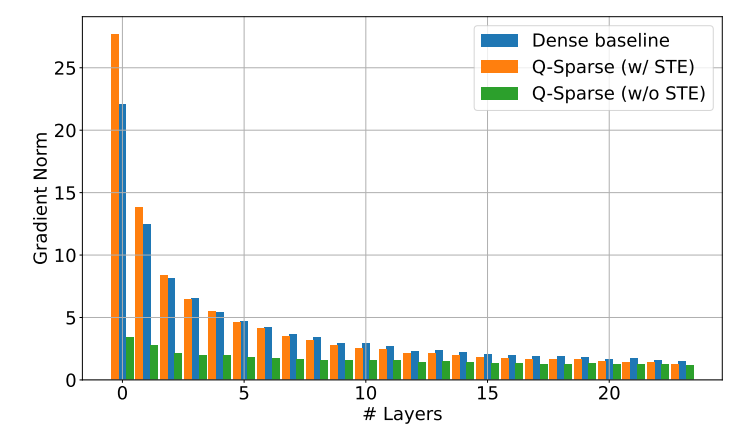

Q-Sparse alcança a esparsidade total da ativação aplicando uma função de rarefação top-K em cada projeção linear. Para retropropagação, um estimador de passagem direta é usado para calcular o gradiente das ativações. Além disso, uma função ReLU quadrática é introduzida para melhorar ainda mais a esparsidade das ativações.

Verificação experimental

Os pesquisadores estudaram a lei de escala dos LLMs com ativação esparsa por meio de uma série de experimentos em larga escala e fizeram algumas descobertas interessantes:

O desempenho dos modelos com ativação esparsa melhora com o aumento do tamanho do modelo e da taxa de esparsidade.

Dada uma taxa de esparsidade S fixa, o desempenho do modelo com ativação esparsa segue uma lei de escala de potência com o tamanho do modelo N.

Dado um parâmetro N fixo, o desempenho do modelo com ativação esparsa segue uma lei de escala exponencial com a taxa de esparsidade S.

Q-Sparse pode ser usado não apenas para treinamento do zero, mas também para treinamento contínuo e ajuste fino de LLMs pré-treinados. Nas configurações de treinamento contínuo e ajuste fino, os pesquisadores usaram a mesma arquitetura e processo de treinamento usados no treinamento do zero, com a única diferença de que os pesos pré-treinados foram usados para inicializar o modelo e a função esparsa foi ativada para continuar o treinamento.

Os pesquisadores estão explorando o uso de Q-Sparse com LLMs de 1 bit (como BitNet b1.58) e especialistas mistos (MoE) para melhorar ainda mais a eficiência dos LLMs. Além disso, eles estão trabalhando para tornar Q-Sparse compatível com o modo de lote, o que fornecerá mais flexibilidade para o treinamento e inferência de LLMs.