Recentemente, equipes de pesquisa da Apple e pesquisadores do Meta AI lançaram uma nova tecnologia chamada LazyLLM, que melhora a eficiência dos grandes modelos de linguagem (LLM) no raciocínio com textos longos.

Como todos sabem, os LLMs atuais costumam enfrentar problemas de lentidão ao lidar com prompts longos, especialmente na fase de preenchimento. Isso ocorre principalmente porque a arquitetura Transformer moderna, ao calcular a atenção, tem uma complexidade computacional que cresce quadraticamente com o número de tokens no prompt. Portanto, ao usar o modelo Llama2, o tempo de cálculo do primeiro token costuma ser 21 vezes maior do que as etapas subsequentes de decodificação, ocupando 23% do tempo de geração.

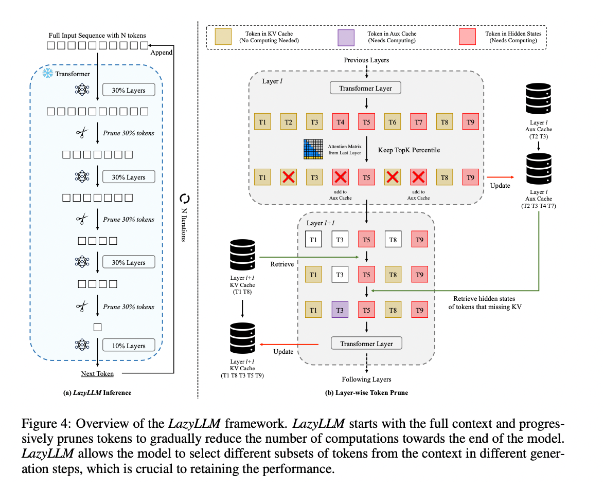

Para melhorar essa situação, os pesquisadores propuseram o LazyLLM, um novo método para acelerar a inferência do LLM por meio da seleção dinâmica de tokens importantes para o cálculo. O cerne do LazyLLM é que ele avalia a importância de cada token com base nas pontuações de atenção das camadas anteriores, reduzindo gradualmente a carga computacional. Diferentemente da compressão permanente, o LazyLLM pode restaurar os tokens reduzidos quando necessário, garantindo a precisão do modelo. Além disso, o LazyLLM introduz um mecanismo chamado Aux Cache, que armazena os estados ocultos dos tokens podados, permitindo a restauração eficiente desses tokens e evitando a queda de desempenho.

O LazyLLM apresenta desempenho excepcional em velocidade de inferência, especialmente nas fases de preenchimento e decodificação. As três principais vantagens da tecnologia são: compatibilidade com qualquer LLM baseado em Transformer, implementação sem necessidade de treinar novamente o modelo e alta eficácia em diversas tarefas de linguagem. A estratégia de poda dinâmica do LazyLLM permite reduzir significativamente a carga computacional, mantendo a maioria dos tokens importantes e, consequentemente, aumentando a velocidade de geração.

Os resultados da pesquisa mostram que o LazyLLM apresenta desempenho superior em várias tarefas de linguagem, com aumento de velocidade de TTFT de até 2,89 vezes (para Llama2) e 4,77 vezes (para XGen), mantendo a precisão praticamente inalterada em relação à linha de base. Seja em perguntas e respostas, geração de resumos ou preenchimento de código, o LazyLLM permite uma geração mais rápida, alcançando um bom equilíbrio entre desempenho e velocidade. Sua estratégia de poda gradual, combinada com a análise por camadas, é fundamental para o sucesso do LazyLLM.

Endereço do artigo: https://arxiv.org/abs/2407.14057

Destaques:

🌟 O LazyLLM acelera o processo de inferência do LLM por meio da seleção dinâmica de tokens importantes, com desempenho excepcional em cenários de textos longos.

⚡ A tecnologia aumenta significativamente a velocidade de inferência, com aumento de velocidade de TTFT de até 4,77 vezes, mantendo alta precisão.

🔧 O LazyLLM não requer modificações nos modelos existentes e é compatível com qualquer LLM baseado em Transformer, facilitando sua implementação.