O que acontece quando uma IA treina novamente usando imagens geradas por ela mesma? Recentemente, pesquisadores da Universidade de Stanford e da Universidade da Califórnia, Berkeley, realizaram um experimento que revelou resultados surpreendentes.

Os pesquisadores descobriram que, quando modelos de geração de imagens de IA são treinados novamente usando suas próprias imagens geradas, esses modelos produzem imagens altamente distorcidas. Pior ainda, essa distorção não se limita às instruções de texto usadas para o treinamento. Uma vez que o modelo é "contaminado", mesmo que depois seja treinado apenas com imagens reais, é difícil para o modelo se recuperar completamente.

O ponto de partida do experimento foi um modelo de código aberto chamado Stable Diffusion (SD). Os pesquisadores primeiro selecionaram 70.000 imagens de alta qualidade de rostos do conjunto de dados FFHQ e as classificaram automaticamente. Em seguida, eles usaram essas imagens reais como entrada e geraram 900 imagens consistentes com características específicas de grupos de pessoas através do modelo Stable Diffusion.

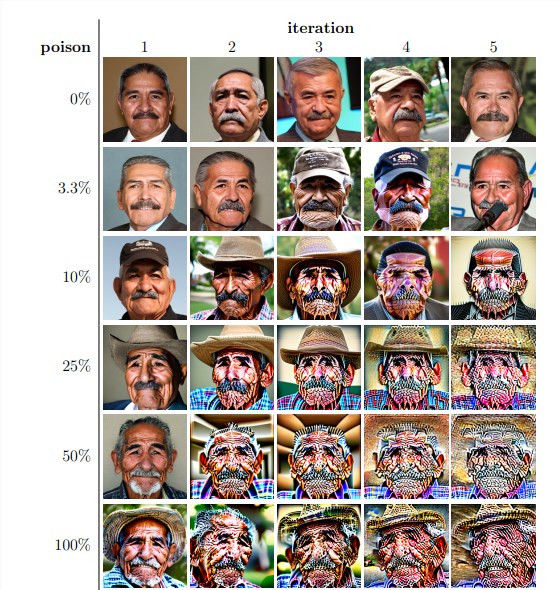

Em seguida, os pesquisadores usaram essas imagens geradas para o treinamento iterativo do modelo. Eles descobriram que, independentemente da proporção de imagens autogeradas no conjunto de dados de treinamento, o modelo eventualmente entra em colapso e a qualidade das imagens geradas diminui drasticamente. Mesmo com apenas 3% de imagens autogeradas no conjunto de dados de treinamento, o fenômeno de colapso do modelo ainda persistiu.

Os resultados do experimento mostraram que a versão base do modelo Stable Diffusion gerou imagens consistentes com as instruções de texto e com alta qualidade visual. Mas quando o modelo passou por treinamento iterativo, as imagens geradas começaram a apresentar inconsistências semânticas e distorções visuais. Os pesquisadores também descobriram que o colapso do modelo não afeta apenas a qualidade da imagem, mas também leva à falta de diversidade nas imagens geradas.

Para verificar isso, os pesquisadores também realizaram um experimento de controle, tentando reduzir o impacto do colapso do modelo ajustando o histograma de cores das imagens geradas e removendo imagens de baixa qualidade. No entanto, os resultados mostraram que essas medidas não foram eficazes para impedir o colapso do modelo.

Os pesquisadores também investigaram se o modelo poderia ser recuperado após ser "contaminado" através de treinamento adicional. Eles descobriram que, embora em alguns casos a qualidade das imagens geradas tenha sido restaurada após várias iterações de treinamento, os sinais de colapso do modelo ainda persistiram. Isso sugere que, uma vez que o modelo é "contaminado", o impacto pode ser de longo prazo, ou até mesmo irreversível.

Esta pesquisa destaca um problema importante: os sistemas de IA de texto para imagem baseados em difusão atualmente populares são muito sensíveis à "contaminação" de dados. Essa "contaminação" pode ocorrer acidentalmente, por exemplo, através da coleta indiscriminada de imagens de recursos online. Ou pode ser um ataque direcionado, como a colocação intencional de dados "contaminados" em um site.

Diante desses desafios, os pesquisadores propuseram algumas soluções possíveis, como o uso de detectores de autenticidade de imagens para excluir imagens geradas por IA ou a adição de marcas d'água nas imagens geradas. Embora esses métodos não sejam perfeitos, combinados, eles podem reduzir significativamente o risco de "contaminação" de dados.

Esta pesquisa nos lembra que o desenvolvimento da tecnologia de IA não é isento de riscos. Precisamos lidar com mais cautela com o conteúdo gerado por IA, garantindo que ele não cause impactos negativos de longo prazo em nossos modelos e conjuntos de dados. Pesquisas futuras precisam explorar melhor como tornar os sistemas de IA mais resilientes a esse tipo de "contaminação" de dados ou desenvolver tecnologias que acelerem a "cura" do modelo.

Endereço do artigo: https://arxiv.org/pdf/2311.12202