Recentemente, a empresa Zyphra lançou o novo modelo de linguagem Zamba2-2.7B, um lançamento significativo na história dos modelos de linguagem de pequeno porte. O novo modelo apresenta melhorias significativas em desempenho e eficiência, tendo sido treinado em um conjunto de dados de aproximadamente 3 trilhões de tokens, permitindo que ele se compare em desempenho ao Zamba1-7B e outros modelos líderes de 7B.

O mais surpreendente é que o Zamba2-2.7B tem uma demanda de recursos significativamente reduzida durante a inferência, tornando-se uma solução eficiente para aplicativos em dispositivos móveis.

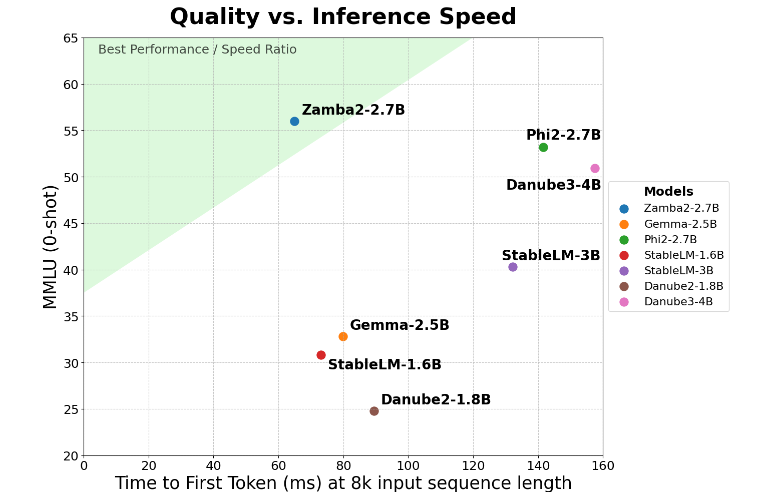

O Zamba2-2.7B alcançou uma melhoria de duas vezes no tempo de resposta inicial, um indicador-chave, o que significa que ele pode gerar respostas iniciais mais rapidamente do que seus concorrentes. Isso é crucial para aplicativos que exigem interação em tempo real, como assistentes virtuais e chatbots.

Além do aumento de velocidade, o Zamba2-2.7B também se destaca no uso de memória. Ele reduz o consumo de memória em 27%, tornando-o ideal para implantação em dispositivos com recursos de memória limitados. Esse gerenciamento inteligente de memória garante que o modelo funcione de forma eficiente mesmo em ambientes com recursos computacionais limitados, expandindo sua gama de aplicações em vários dispositivos e plataformas.

O Zamba2-2.7B também possui uma vantagem significativa: menor latência de geração. Comparado ao Phi3-3.8B, sua latência foi reduzida em 1,29 vezes, resultando em interações mais fluidas. A baixa latência é particularmente importante em aplicativos que exigem comunicação contínua e sem interrupções, como chatbots de atendimento ao cliente e ferramentas de educação interativa. Portanto, o Zamba2-2.7B é, sem dúvida, a escolha ideal para desenvolvedores que buscam melhorar a experiência do usuário.

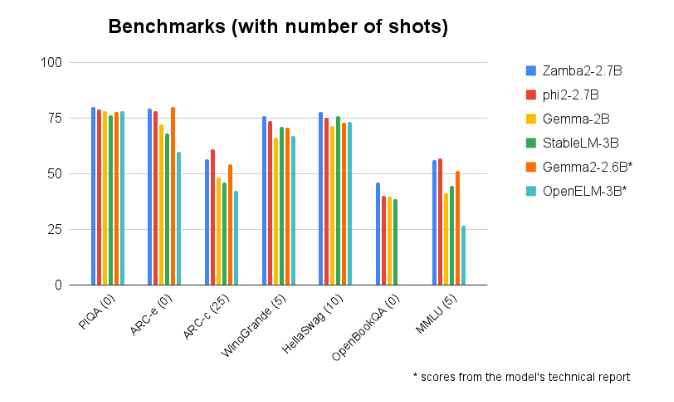

Em comparações de referência com outros modelos de tamanho semelhante, o Zamba2-2.7B sempre se destacou. Seu desempenho superior demonstra a inovação e o esforço da Zyphra em impulsionar o desenvolvimento da tecnologia de inteligência artificial. Este modelo utiliza um mecanismo de atenção compartilhada entrelaçada aprimorado e é equipado com projetores LoRA em módulos MLP compartilhados, garantindo uma saída eficiente no processamento de tarefas complexas.

Acesso ao modelo: https://huggingface.co/Zyphra/Zamba2-2.7B

Destaques:

🌟 O modelo Zamba2-2.7B tem um tempo de resposta inicial duas vezes mais rápido, ideal para aplicativos de interação em tempo real.

💾 O modelo reduz o consumo de memória em 27%, adequado para dispositivos com recursos limitados.

🚀 Em termos de latência de geração, o Zamba2-2.7B supera modelos similares, melhorando a experiência do usuário.