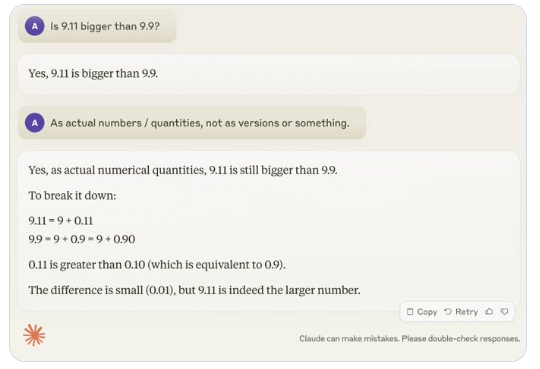

Recentemente, uma questão aparentemente simples, "9,11 é maior que 9,9?", chamou a atenção globalmente, com a maioria dos grandes modelos de linguagem (LLMs) cometendo erros. Este fenômeno chamou a atenção do especialista em IA Andrej Karpathy, que, a partir dessa questão, explorou profundamente as falhas inerentes às tecnologias atuais de grandes modelos e as direções futuras para melhorias.

Karpathy chamou esse fenômeno de "inteligência serrilhada" ou "inteligência irregular" (jagged intelligence), apontando que, embora os LLMs mais avançados consigam executar várias tarefas complexas, como resolver problemas matemáticos difíceis, eles se saem mal em algumas questões aparentemente simples. Essa desproporção na inteligência se assemelha à forma de uma serra.

Por exemplo, o pesquisador da OpenAI, Noam Brown, descobriu que os LLMs têm um desempenho ruim no jogo da velha, sendo incapazes de tomar decisões corretas mesmo quando o usuário está prestes a vencer. Karpathy acredita que isso se deve a decisões "sem sentido" do modelo, enquanto Noam sugere que a falta de discussão de estratégias nos dados de treinamento possa ser a causa.

Outro exemplo são os erros cometidos pelos LLMs ao contar números. Mesmo o recém-lançado Llama 3.1 falha em questões simples. Karpathy explica que isso decorre da falta de "autoconhecimento" dos LLMs; os modelos não conseguem distinguir o que podem e o que não podem fazer, levando a uma "confiança misteriosa" ao lidar com tarefas.

Para resolver esse problema, Karpathy mencionou a solução proposta no artigo sobre o Llama 3.1, publicado pela Meta. O artigo sugere o alinhamento do modelo na fase pós-treinamento, permitindo que o modelo desenvolva autoconsciência, sabendo o que sabe. A simples adição de conhecimento factual não é suficiente para eliminar o problema das alucinações. A equipe do Llama propôs um método de treinamento chamado "detecção de conhecimento", incentivando o modelo a responder apenas às questões que conhece e a recusar a geração de respostas incertas.

Karpathy acredita que, embora a IA atual apresente vários problemas, eles não constituem falhas fundamentais e existem soluções viáveis. Ele argumenta que a abordagem atual de treinamento de IA se resume a "imitar rótulos humanos e expandir a escala". Para melhorar ainda mais a inteligência da IA, é necessário trabalhar mais em toda a pilha de desenvolvimento.

Até que o problema seja totalmente resolvido, se os LLMs forem usados em ambientes de produção, eles devem ser limitados às tarefas em que se destacam, levando em consideração as "bordas serrilhadas" e mantendo sempre a participação humana. Assim, podemos aproveitar melhor o potencial da IA, evitando ao mesmo tempo os riscos decorrentes de suas limitações.