Na área de avatares digitais 3D, apesar dos avanços significativos, métodos anteriores ainda apresentavam problemas de consistência em múltiplas perspectivas e falta de expressividade emocional. Para resolver esses desafios, uma equipe de pesquisa da Universidade de Nanjing, Universidade de Fudan e do laboratório Huawei Noah's Ark fez uma nova descoberta.

Acesso ao produto: https://nju-3dv.github.io/projects/EmoTalk3D/

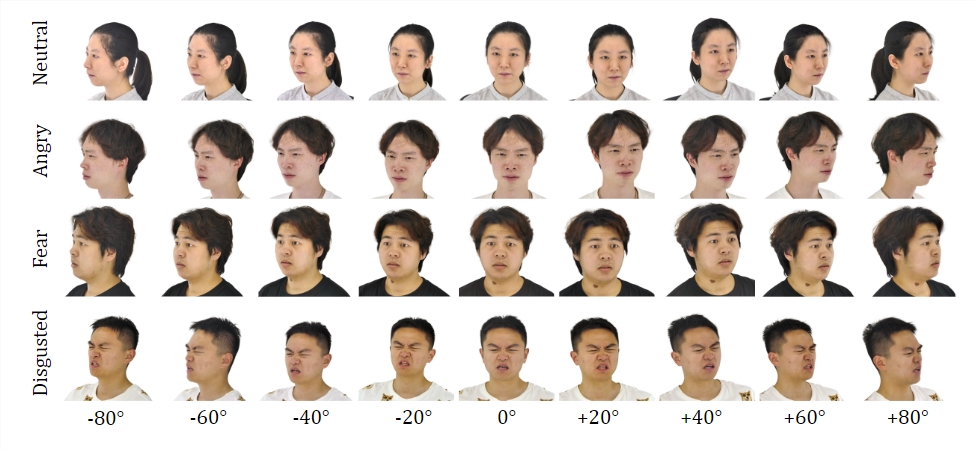

Eles coletaram o conjunto de dados EmoTalk3D, que contém vídeos multi-perspectivos calibrados, anotações emocionais e geometria 3D quadro a quadro. E propuseram um novo método para sintetizar cabeças falantes 3D com emoções controláveis, com melhorias significativas na sincronização labial e na qualidade de renderização.

Conjunto de dados:

Treinando no conjunto de dados EmoTalk3D, a equipe de pesquisa construiu uma estrutura de mapeamento "de áudio para geometria e para aparência". Primeiro, sequências geométricas 3D realistas são previstas a partir de características de áudio, e então, com base na geometria prevista, a aparência do avatar 3D falante, representada por Gaussianas 4D, é sintetizada. A aparência é ainda decomposta em Gaussianas padrão e dinâmicas, aprendidas a partir de vídeos multi-perspectivos e combinadas para apresentar animações de avatares falantes em perspectiva livre.

O modelo consegue implementar emoções controláveis nos avatares falantes gerados e pode ser renderizado em uma ampla gama de perspectivas. Ao capturar detalhes dinâmicos do rosto, como rugas e expressões sutis, apresenta uma qualidade e estabilidade de renderização aprimoradas na geração do movimento labial. Nos exemplos dos resultados gerados, são mostradas com precisão as expressões de alegria, raiva e tristeza do avatar digital 3D.

Seu processo geral inclui cinco módulos:

O primeiro é o codificador de decomposição de conteúdo emocional, que analisa as características de conteúdo e emoção da fala de entrada; o segundo é a rede de áudio para geometria, que prevê a nuvem de pontos 3D dinâmica a partir das características; o terceiro é o módulo de otimização e complementação Gaussiana, que estabelece a aparência padrão; o quarto é a rede de geometria para aparência, que sintetiza a aparência facial com base na nuvem de pontos 3D dinâmica; e o quinto é o módulo de renderização, que renderiza a Gaussiana dinâmica em animações de perspectiva livre.

Além disso, eles também criaram o conjunto de dados EmoTalk3D, um conjunto de dados de avatares falantes multi-perspectivos com anotações emocionais e forma facial 3D quadro a quadro, e será disponibilizado ao público para fins de pesquisa não comercial.

Destaques:

💥 Apresentação de um novo método para sintetizar avatares digitais com emoções controláveis.

🎯 Construção de uma estrutura de mapeamento "de áudio para geometria e para aparência".

👀 Criação e disponibilização do conjunto de dados EmoTalk3D.