Nos dias de hoje, o campo do processamento de linguagem natural (PNL) está se desenvolvendo rapidamente, com grandes modelos de linguagem (LLMs) capazes de executar tarefas complexas relacionadas à linguagem com alta precisão, abrindo novas possibilidades para a interação humano-máquina. No entanto, existe um problema significativo na PNL: a avaliação dos modelos depende fortemente de anotações humanas.

Dados gerados por humanos são cruciais para o treinamento e validação dos modelos, mas a coleta desses dados é cara e demorada. Além disso, à medida que os modelos melhoram, as anotações coletadas anteriormente podem precisar de atualização, diminuindo sua utilidade na avaliação de novos modelos. Isso leva à necessidade contínua de novos dados, criando desafios para a escalabilidade e sustentabilidade da avaliação eficaz de modelos.

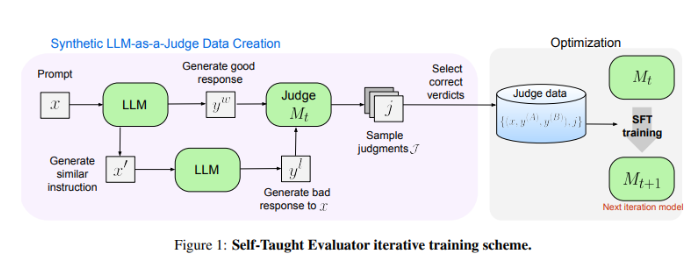

Pesquisadores do Meta FAIR apresentam uma solução inovadora: o "Self-Taught Evaluator" (Avaliador Autodidata). Este método não requer anotações humanas, usando dados sintéticos gerados para treinamento. Primeiro, um modelo-semente gera pares de preferências sintéticas contrastantes. Então, o modelo avalia esses pares e iterativamente melhora, usando seu próprio julgamento para aumentar o desempenho em iterações subsequentes, reduzindo significativamente a dependência de anotações humanas.

Os pesquisadores usaram o modelo Llama-3-70B-Instruct para testar o desempenho do "Avaliador Autodidata". O método aumentou a precisão do modelo no benchmark RewardBench de 75,4% para 88,7%, alcançando ou mesmo superando o desempenho de modelos treinados com anotações humanas. Após várias iterações, o modelo final atingiu uma precisão de 88,3% em uma única inferência e 88,7% em votação majoritária, demonstrando sua forte estabilidade e confiabilidade.

O "Avaliador Autodidata" oferece uma solução escalável e eficiente para a avaliação de modelos de PNL, utilizando dados sintéticos e melhoria iterativa para enfrentar o desafio da dependência de anotações humanas, impulsionando o desenvolvimento de modelos de linguagem.

Endereço do artigo: https://arxiv.org/abs/2408.02666

Destaques:

- 😃A avaliação de modelos de PNL depende de anotações humanas, apresentando problemas de alto custo, tempo e diminuição da utilidade na coleta de dados.

- 🤖O Meta FAIR lança o "Self-Taught Evaluator", utilizando dados sintéticos para treinamento e reduzindo a dependência de anotações humanas.

- 💪O "Avaliador Autodidata" apresenta desempenho excelente, aumentando significativamente a precisão do modelo nos testes, mostrando-se estável e confiável.