No mundo da inteligência artificial, existe um grupo de "artistas" especiais — as estruturas hierárquicas dos modelos Transformer. Eles são como pincéis mágicos, pintando um mundo vibrante na tela da linguagem. Recentemente, um artigo intitulado "Transformer Layers as Painters" ofereceu uma nova perspectiva para entender o mecanismo de funcionamento das camadas intermediárias do Transformer.

Os modelos Transformer, como os modelos de linguagem grandes mais populares atualmente, possuem bilhões de parâmetros. Cada camada é como um artista, colaborando para criar uma grande pintura de linguagem. Mas como esses "artistas" trabalham juntos? Quais são suas "tintas" e "pincéis"? Este artigo tenta responder a essas perguntas.

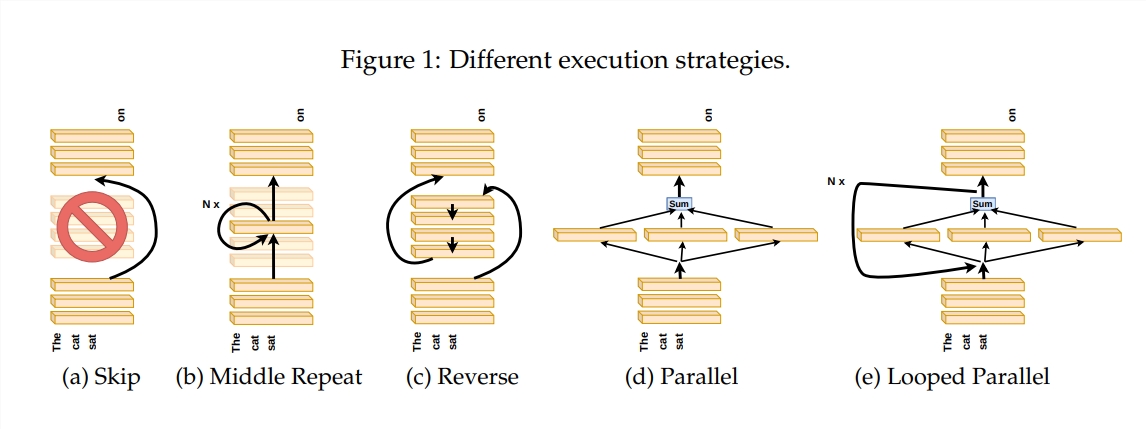

Para investigar o funcionamento das camadas do Transformer, os autores projetaram uma série de experimentos, incluindo pular algumas camadas, alterar a ordem das camadas ou executá-las em paralelo. Esses experimentos são como definir diferentes regras de pintura para os "artistas", para ver se eles conseguem se adaptar.

Na metáfora da "linha de montagem de pintores", a entrada é vista como uma tela, e o processo através das camadas intermediárias é como a tela sendo passada pela linha de montagem. Cada "artista", ou seja, cada camada do Transformer, modifica a pintura de acordo com sua especialidade. Essa analogia ajuda a entender a capacidade de paralelismo e ajuste das camadas do Transformer.

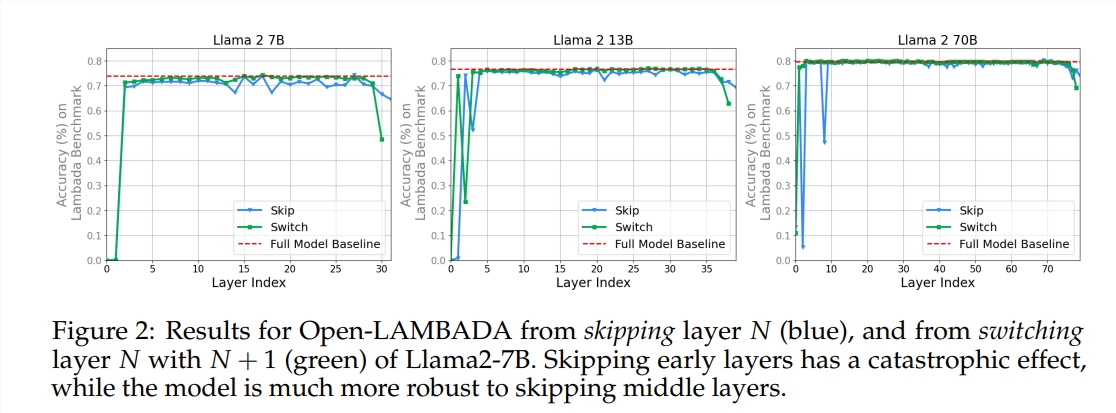

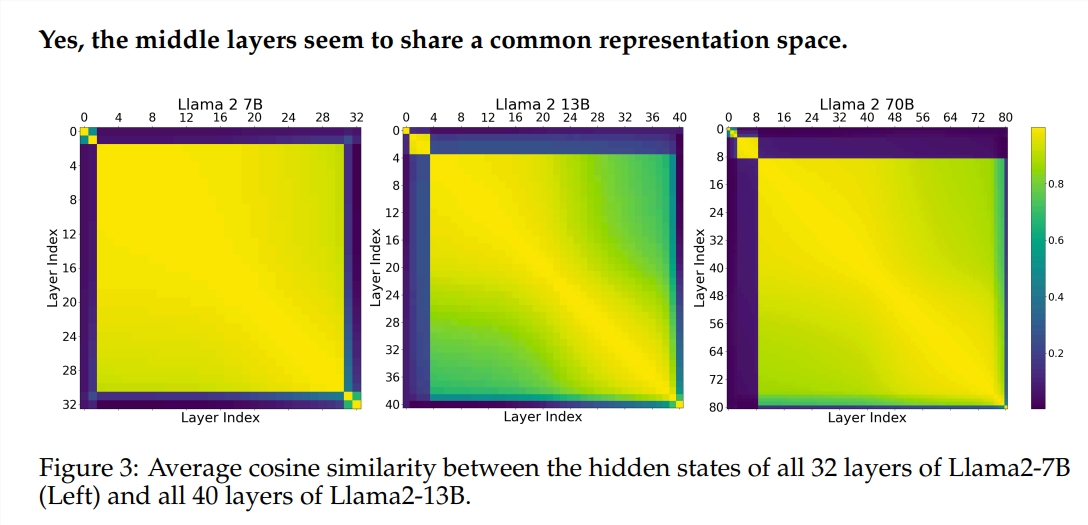

Os experimentos utilizaram dois modelos de linguagem grandes (LLM) pré-treinados: Llama2-7B e BERT. A pesquisa descobriu que os "artistas" das camadas intermediárias parecem compartilhar uma "caixa de tintas" comum — o espaço de representação — diferente das camadas inicial e final. Pular alguns "artistas" das camadas intermediárias não teve grande impacto na pintura como um todo, indicando que nem todos os "artistas" são essenciais.

Embora os "artistas" das camadas intermediárias usem a mesma "caixa de tintas", eles usam suas próprias habilidades para criar padrões diferentes na tela. Se simplesmente repetir as habilidades de um "artista", a pintura perderá seu charme original.

Para tarefas matemáticas e de raciocínio que exigem lógica rigorosa, a ordem de "pintura" é particularmente importante. Já para tarefas que dependem da compreensão semântica, a influência da ordem é relativamente menor.

Os resultados da pesquisa mostram que as camadas intermediárias do Transformer têm um certo grau de consistência, mas não são redundantes. Para tarefas matemáticas e de raciocínio, a ordem das camadas é mais importante do que para tarefas semânticas.

A pesquisa também descobriu que nem todas as camadas são necessárias, e as camadas intermediárias podem ser puladas sem afetar catastroficamente o desempenho do modelo. Além disso, embora as camadas intermediárias compartilhem o mesmo espaço de representação, elas executam funções diferentes. Alterar a ordem de execução das camadas leva a uma queda de desempenho, indicando que a ordem tem um impacto importante no desempenho do modelo.

Na exploração dos modelos Transformer, muitos pesquisadores estão tentando otimizá-los, incluindo poda, redução de parâmetros, etc. Esses trabalhos fornecem experiências e insights valiosos para a compreensão dos modelos Transformer.

Endereço do artigo: https://arxiv.org/pdf/2407.09298v1