Em um mundo digital dominado por dados e algoritmos, cada avanço na inteligência artificial depende de um elemento crucial: o checkpoint (ponto de verificação). Imagine que você está treinando um grande modelo de linguagem capaz de compreender emoções e responder de forma fluente. Esse modelo é extremamente inteligente, mas também um "guloso", exigindo vastos recursos computacionais para seu "treinamento". Durante o processo de treinamento, uma queda de energia ou falha de hardware pode resultar em perdas significativas. Nesse caso, o checkpoint atua como uma "máquina do tempo", permitindo que tudo volte ao último estado seguro e que a tarefa inacabada seja retomada.

No entanto, esta "máquina do tempo" requer um design cuidadoso. Cientistas da ByteDance e da Universidade de Hong Kong, no artigo "ByteCheckpoint: A Unified Checkpointing System for LLM Development", apresentam um novo sistema de checkpoints – o ByteCheckpoint. Ele não é apenas uma ferramenta de backup simples, mas um artefato que aumenta significativamente a eficiência do treinamento de grandes modelos de linguagem.

Primeiro, precisamos entender os desafios enfrentados pelos grandes modelos de linguagem (LLMs). Esses modelos são "grandes" porque precisam processar e memorizar uma quantidade enorme de informações, o que resulta em altos custos de treinamento, grande consumo de recursos e baixa tolerância a falhas. Uma falha pode levar ao desperdício de um longo treinamento.

O sistema de checkpoints é como uma "foto" do modelo, salvando periodicamente o estado durante o treinamento. Assim, mesmo que ocorra um problema, é possível recuperar rapidamente o estado mais recente, minimizando as perdas. No entanto, os sistemas de checkpoints existentes, ao lidar com modelos grandes, frequentemente sofrem com gargalos de E/S (entrada/saída), resultando em baixa eficiência.

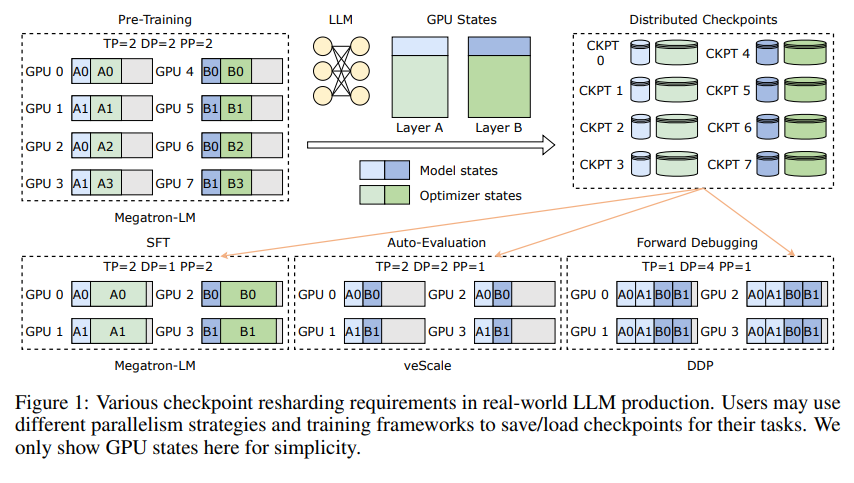

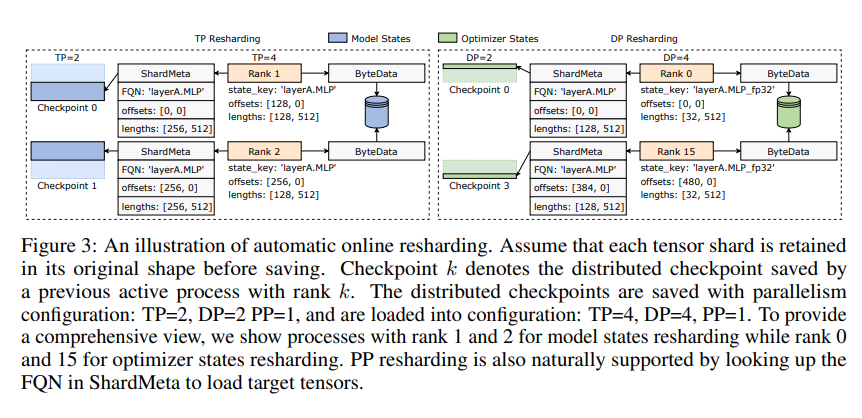

A inovação do ByteCheckpoint reside em sua nova arquitetura de armazenamento, que separa dados e metadados, permitindo o tratamento mais flexível de diferentes configurações paralelas e frameworks de treinamento. Ainda melhor, ele suporta o particionamento automático online de checkpoints, permitindo o ajuste dinâmico dos checkpoints para diferentes ambientes de hardware sem interromper o treinamento.

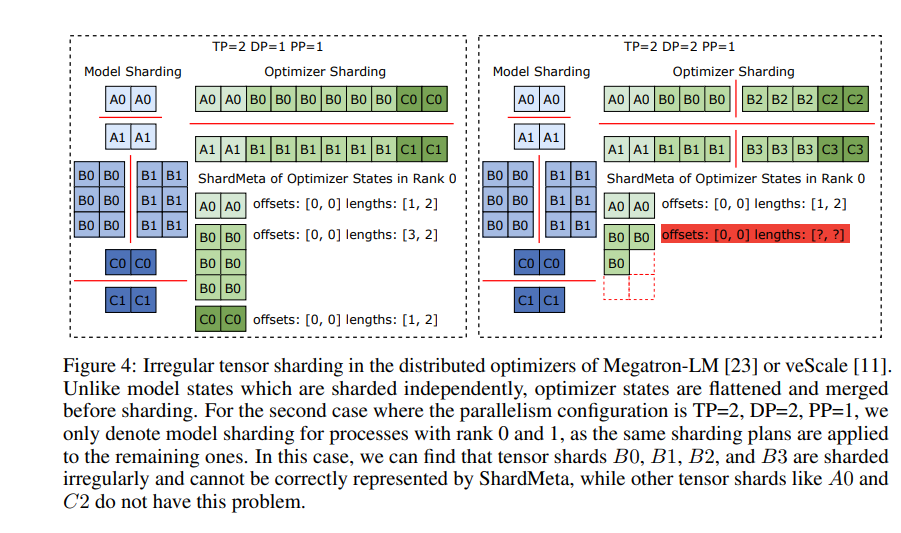

O ByteCheckpoint também introduz uma tecnologia crucial: a fusão assíncrona de tensores. Isso permite o processamento eficiente de tensores distribuídos de forma desigual em diferentes GPUs, garantindo a integridade e consistência do modelo durante o particionamento de checkpoints.

Para melhorar a velocidade de salvamento e carregamento de checkpoints, o ByteCheckpoint integra uma série de otimizações de desempenho de E/S, como pipelines refinados de salvamento/carregamento, pool de memória Ping-Pong, salvamento com balanceamento de carga e carregamento sem redundância, reduzindo significativamente o tempo de espera durante o treinamento.

Experimentos comprovaram que, em comparação com métodos tradicionais, o ByteCheckpoint aumenta a velocidade de salvamento e carregamento de checkpoints em dezenas ou até centenas de vezes, melhorando significativamente a eficiência do treinamento de grandes modelos de linguagem.

O ByteCheckpoint não é apenas um sistema de checkpoints, mas um valioso assistente no treinamento de grandes modelos de linguagem, sendo crucial para um treinamento de IA mais eficiente e estável.

Link do artigo: https://arxiv.org/pdf/2407.20143