Recentemente, o renomado pesquisador de IA Andrej Karpathy apresentou um ponto de vista bastante controverso: ele acredita que a técnica de aprendizado por reforço baseado em feedback humano (RLHF), amplamente elogiada atualmente, pode não ser o caminho necessário para alcançar a verdadeira capacidade de resolução de problemas em nível humano. Essa declaração, sem dúvida, lançou uma bomba no atual campo de pesquisa de IA.

RLHF foi considerado um fator-chave para o sucesso de modelos de linguagem grandes (LLMs) como o ChatGPT, sendo aclamado como a "arma secreta" que confere à IA compreensão, obediência e capacidade de interação natural. No processo de treinamento tradicional de IA, o RLHF geralmente é a última etapa após o pré-treinamento e o ajuste fino supervisionado (SFT). No entanto, Karpathy compara o RLHF a um "gargalo" e a uma "solução paliativa", argumentando que está longe de ser a solução definitiva para a evolução da IA.

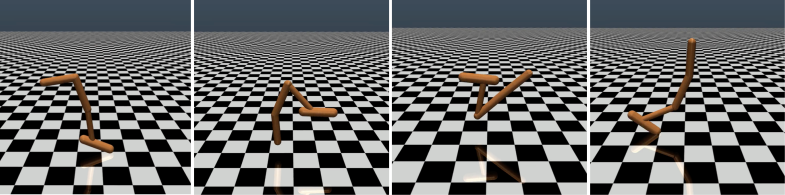

Karpathy comparou habilmente o RLHF com o AlphaGo da DeepMind. O AlphaGo empregou o que ele chamou de "RL verdadeiro" (aprendizado por reforço), jogando contra si mesmo e maximizando sua taxa de vitória, eventualmente superando os melhores jogadores humanos sem intervenção humana. Esse método, por meio da otimização de redes neurais, aprendeu diretamente dos resultados do jogo, alcançando um desempenho acima do nível humano.

Em contraste, Karpathy acredita que o RLHF se assemelha mais à imitação de preferências humanas do que à verdadeira resolução de problemas. Ele imagina que, se o AlphaGo utilizasse o método RLHF, os avaliadores humanos precisariam comparar uma grande quantidade de estados de jogo e selecionar suas preferências; esse processo poderia exigir até 100.000 comparações para treinar um "modelo de recompensa" que imite a "verificação de atmosfera" humana. No entanto, essa avaliação baseada em "atmosfera" pode levar a resultados enganosos em jogos rigorosos como o Go.

Da mesma forma, o modelo de recompensa atual dos LLMs funciona de maneira semelhante – ele tende a classificar com alta prioridade as respostas que parecem estatisticamente mais agradáveis aos avaliadores humanos. Isso se assemelha mais a uma adaptação às preferências superficiais humanas do que à verdadeira capacidade de resolução de problemas. O que é ainda mais preocupante é que o modelo pode aprender rapidamente como explorar essa função de recompensa, em vez de realmente melhorar suas próprias habilidades.

Karpathy aponta que, embora o aprendizado por reforço tenha um desempenho excelente em ambientes fechados como o Go, o verdadeiro aprendizado por reforço ainda é difícil de implementar para tarefas de linguagem abertas. Isso ocorre principalmente porque, em tarefas abertas, é difícil definir objetivos e mecanismos de recompensa claros. "Como fornecer uma recompensa objetiva para tarefas como resumir um artigo, responder a perguntas vagas sobre a instalação do pip, contar uma piada ou reescrever código Java em Python?", questiona Karpathy. "Avançar nessa direção não é impossível em princípio, mas certamente não é fácil; requer algum pensamento criativo."

Apesar disso, Karpathy ainda acredita que, se esse desafio for resolvido, os modelos de linguagem poderão realmente igualar ou até mesmo superar a capacidade de resolução de problemas dos humanos. Esse ponto de vista coincide com uma publicação recente do Google DeepMind, que afirma que a abertura é fundamental para a inteligência artificial geral (AGI).

Como um dos vários especialistas seniores em IA que deixaram a OpenAI este ano, Karpathy está atualmente trabalhando em sua própria startup de educação em IA. Suas declarações, sem dúvida, injetaram uma nova dimensão de reflexão no campo de pesquisa de IA e forneceram insights valiosos para o futuro desenvolvimento da IA.

O ponto de vista de Karpathy gerou amplas discussões no setor. Os defensores argumentam que ele revelou um problema crucial na pesquisa atual de IA: como fazer com que a IA realmente possua a capacidade de resolver problemas complexos, e não apenas imitar comportamentos humanos. Os opositores temem que abandonar o RLHF muito cedo possa levar a um desvio na direção do desenvolvimento da IA.

Endereço do artigo: https://arxiv.org/pdf/1706.03741