O recém-lançado modelo de IA de código aberto Reflection70B, tem sido alvo de amplas controvérsias na indústria.

Este modelo, lançado pela startup nova-iorquina HyperWrite, autodenominado uma variante do Llama3.1 da Meta, chamou a atenção por seu desempenho excepcional em testes de terceiros. No entanto, com a divulgação de alguns resultados de testes, a reputação do Reflection70B começou a ser questionada.

Tudo começou quando Matt Shumer, cofundador e CEO da HyperWrite, anunciou o Reflection70B no X (antigo Twitter) em 6 de setembro, declarando-o com confiança como o "modelo de código aberto mais poderoso do mundo".

Shumer também compartilhou detalhes sobre a tecnologia de "ajuste reflexivo" do modelo, alegando que este método permite que o modelo faça uma autoavaliação antes de gerar conteúdo, melhorando assim sua precisão.

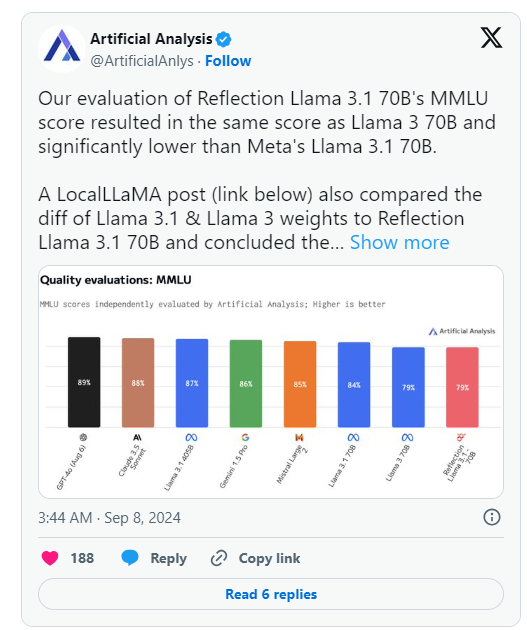

No entanto, no dia seguinte ao anúncio da HyperWrite, a Artificial Analysis, uma organização que realiza "análises independentes de modelos de IA e provedores de hospedagem", publicou sua própria análise no X, indicando que a pontuação MMLU (Massive Multitask Language Understanding) do Reflection Llama3.170B que eles avaliaram era a mesma do Llama370B, mas significativamente menor que a do Llama3.170B da Meta, o que difere significativamente dos resultados inicialmente divulgados pela HyperWrite/Shumer.

Shumer posteriormente afirmou que os pesos (ou configurações do modelo de código aberto) do Reflection70B apresentaram problemas durante o upload para o Hugging Face (repositório e empresa de hospedagem de código de IA de terceiros), o que pode ter resultado em um desempenho inferior à versão da "API interna" da HyperWrite.

A Artificial Analysis, em declaração posterior, afirmou ter obtido acesso à API privada e observado um desempenho impressionante, embora não tenha atingido o nível inicialmente declarado. Como o teste foi realizado na API privada, eles não puderam verificar independentemente o que estavam testando.

A organização levantou duas questões cruciais que questionam seriamente as declarações de desempenho iniciais da HyperWrite e de Shumer:

- Por que a versão lançada não foi a versão testada pela HyperWrite por meio da API privada do Reflection?

- Por que os pesos do modelo da versão testada ainda não foram publicados?

Simultaneamente, vários usuários de comunidades de aprendizado de máquina e IA no Reddit também questionaram o desempenho declarado e a origem do Reflection70B. Algumas pessoas apontaram que, de acordo com comparações de modelos publicadas por terceiros no Github, o Reflection70B parece ser uma variante do Llama3, e não do Llama-3.1, o que levanta ainda mais dúvidas sobre as declarações iniciais de Shumer e da HyperWrite.

Isso levou pelo menos um usuário do X, Shin Megami Boson, a acusar publicamente Shumer de "fraude" na comunidade de pesquisa de IA em 8 de setembro, às 20h07, horário do leste, e a publicar uma longa sequência de capturas de tela e outras evidências.

Outros acusaram o modelo de ser na verdade um "wrapper" ou aplicativo construído sobre o Claude3 da Anthropic, um concorrente de código proprietário/fechado.

No entanto, outros usuários do X saíram em defesa de Shumer e do Reflection70B, e alguns também publicaram o desempenho impressionante do modelo em suas próprias experiências.

Atualmente, a comunidade de pesquisa de IA aguarda a resposta de Shumer às acusações de fraude e a atualização dos pesos do modelo no Hugging Face.

🚀 O lançamento do modelo Reflection70B foi seguido por questionamentos sobre seu desempenho, com os resultados dos testes não replicando o desempenho inicialmente afirmado.

⚙️ O fundador da HyperWrite explicou que problemas no upload do modelo levaram à queda de desempenho, pedindo que se preste atenção à versão atualizada.

👥 As discussões sobre o modelo nas redes sociais são acaloradas, com acusações e defesas, criando um cenário complexo.