O Google anunciou hoje o lançamento de uma nova série de modelos Gemini aprimorados, incluindo o Gemini-1.5-Pro-002 e o Gemini-1.5-Flash-002. Esta atualização não apenas melhorou significativamente o desempenho, mas também trouxe descontos de preços surpreendentes, o que certamente causará um grande impacto no desenvolvimento de IA.

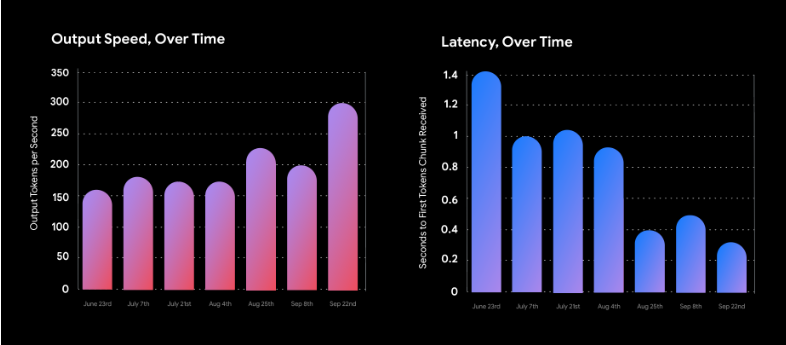

Primeiro, o mais atraente é a redução drástica de preços. O custo de uso dos novos modelos foi reduzido pela metade, com uma queda de mais de 50%. Ao mesmo tempo, o desempenho foi significativamente aprimorado. A velocidade de processamento do Gemini 1.5 Flash dobrou, enquanto o 1.5 Pro ficou quase três vezes mais rápido. Isso significa que os desenvolvedores podem obter resultados mais rápidos e atrasos menores com um custo menor, aumentando significativamente a eficiência do desenvolvimento.

Em termos de desempenho, os novos modelos Gemini demonstram uma melhoria abrangente. As melhorias são particularmente notáveis em matemática, processamento de textos longos e tarefas visuais. Por exemplo, o modelo agora pode processar facilmente documentos PDF com mais de 1000 páginas, responder a perguntas que incluem dezenas de milhares de linhas de código e até mesmo extrair informações úteis de um vídeo de uma hora. No teste de referência MMLU-Pro, que é bastante desafiador, o novo modelo alcançou uma melhoria de desempenho de aproximadamente 7%. O que é ainda mais impressionante é que nos testes de referência MATH e HiddenMath, a melhoria chegou a 20%.

O Google também otimizou a qualidade de resposta do modelo. A nova versão, mantendo a segurança do conteúdo, oferece respostas mais úteis e concisas. Em tarefas como resumo, perguntas e respostas e extração de informações, o comprimento da saída foi reduzido de 5% a 20% em comparação com a versão anterior, o que não apenas aumenta a eficiência, mas também reduz ainda mais os custos de uso.

Para usuários corporativos, a capacidade de processamento de textos longos (até 2 milhões de palavras) e a capacidade multimodais do Gemini 1.5 Pro abrem novos cenários de aplicação. A partir de 1º de outubro de 2024, os preços dos tokens de entrada, tokens de saída e tokens de cache incremental serão reduzidos em 64%, 52% e 64%, respectivamente, o que certamente reduzirá significativamente os custos de uso de IA pelas empresas.

Em termos de limitações de uso, o Google também fez ajustes significativos. A limitação de taxa de serviço pago do Gemini 1.5 Flash foi aumentada para 2000 solicitações por minuto, enquanto a do 1.5 Pro foi aumentada para 1000, oferecendo aos desenvolvedores maior flexibilidade.

A segurança sempre foi uma área de foco principal do Google. A nova versão do modelo, além de seguir as instruções do usuário, aprimorou ainda mais a segurança. O Google também ajustou as configurações padrão do filtro, dando aos desenvolvedores mais autonomia.

Além disso, o Google lançou uma versão aprimorada do modelo experimental Gemini 1.5 Flash-8B, que apresenta excelente desempenho em aplicações de texto e multimodais. Esta versão já está disponível no Google AI Studio e na API Gemini, oferecendo mais opções aos desenvolvedores.

Para usuários do Gemini Advanced, a versão Gemini 1.5 Pro-002 otimizada para bate-papo estará disponível em breve.