Na área de processamento de linguagem natural (PNL), o desenvolvimento de grandes modelos de linguagem (LLMs) tem sido rápido, alcançando avanços significativos em diversos campos. No entanto, com o aumento da complexidade dos modelos, a avaliação precisa de suas saídas se torna crucial. Tradicionalmente, a avaliação dependia de humanos, um método dispendioso em tempo e difícil de escalonar, incapaz de acompanhar o ritmo acelerado do desenvolvimento dos modelos.

Para mudar essa situação, a equipe de pesquisa de IA da Salesforce lançou o SFR-Judge, uma família de três grandes modelos de linguagem. Esses modelos possuem 8 bilhões, 12 bilhões e 70 bilhões de parâmetros, respectivamente, e são baseados em Meta Llama3 e Mistral NeMO. O SFR-Judge pode executar várias tarefas de avaliação, incluindo comparação em pares, pontuação única e avaliação de classificação binária, com o objetivo de ajudar as equipes de pesquisa a avaliar o desempenho de novos modelos de forma rápida e eficiente.

Os modelos tradicionais de avaliação de LLMs costumam apresentar alguns problemas de viés, como viés de posição e viés de comprimento, que afetam seus julgamentos. Para superar esses problemas, o SFR-Judge utiliza o método de treinamento de otimização de preferência direta (DPO), permitindo que o modelo aprenda com exemplos positivos e negativos, melhorando assim sua capacidade de compreensão das tarefas de avaliação, reduzindo vieses e garantindo a consistência dos julgamentos.

Nos testes, o SFR-Judge apresentou desempenho excelente em 13 benchmarks, superando muitos modelos de avaliação existentes, incluindo alguns modelos privados. Em particular, no ranking RewardBench, a precisão do SFR-Judge atingiu 92,7%, sendo a primeira e segunda vez que um modelo de avaliação generativo ultrapassa a marca de 90%, demonstrando seu desempenho excepcional na avaliação de modelos.

O método de treinamento do SFR-Judge abrange três formatos de dados diferentes. O primeiro é a "crítica em cadeia de pensamento", que ajuda o modelo a gerar uma análise estruturada das respostas de avaliação. O segundo é a "avaliação padrão", que simplifica o processo de avaliação, fornecendo feedback direto sobre se a resposta atende aos padrões. Por fim, a "dedução de resposta" ajuda o modelo a entender as características de respostas de alta qualidade, fortalecendo sua capacidade de julgamento. A combinação desses três formatos de dados melhorou significativamente a capacidade de avaliação do SFR-Judge.

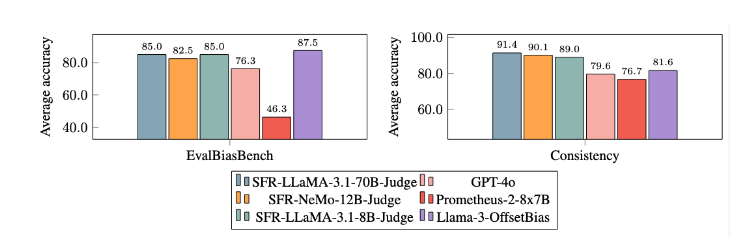

Após inúmeros experimentos, os modelos SFR-Judge demonstraram desempenho significativamente superior a outros modelos na redução de vieses. No benchmark EvalBiasBench, eles mostraram alta consistência de ordem em pares, indicando que mesmo com mudanças na ordem das respostas, o julgamento do modelo permanece estável. Isso torna o SFR-Judge uma solução de avaliação automatizada confiável, reduzindo a dependência de anotações manuais e oferecendo uma opção mais escalável para a avaliação de modelos.

Link do artigo: https://arxiv.org/abs/2409.14664

Destaques:

📊 Alta precisão: O SFR-Judge obteve os melhores resultados em 10 dos 13 benchmarks de teste, atingindo uma alta precisão de 92,7% no RewardBench.

🛡️ Mitigação de vieses: O modelo apresenta vieses menores do que outros modelos de avaliação, especialmente em relação aos vieses de comprimento e posição.

🔧 Aplicações multifuncionais: O SFR-Judge suporta comparação em pares, pontuação única e avaliação de classificação binária, adaptando-se a diversos cenários de avaliação.