Recentemente, o Google anunciou o lançamento de um novo modelo chamado "gemma-2-2b-jpn-it", o mais recente membro de sua série de modelos de linguagem Gemma. Este modelo é otimizado especificamente para a língua japonesa, demonstrando o compromisso contínuo do Google com os modelos de linguagem de grande porte (LLMs).

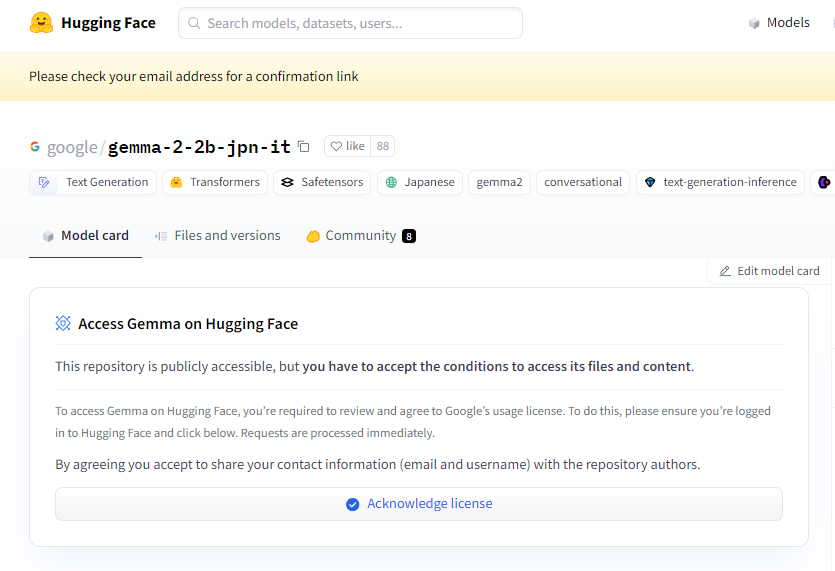

Entrada do projeto: https://huggingface.co/google/gemma-2-2b-jpn-it

gemma-2-2b-jpn-it é um modelo de linguagem de grande porte do tipo decodificador texto-para-texto, com pesos abertos, o que significa que ele pode ser acessado publicamente e ajustado para diferentes tarefas de geração de texto, como perguntas e respostas, resumos e raciocínio.

Este novo modelo possui 2,61 bilhões de parâmetros e utiliza o tipo de tensor BF16. Ele é baseado na arquitetura da série de modelos Gemini do Google e possui documentação e recursos técnicos avançados, permitindo que os desenvolvedores integrem facilmente a inferência em vários aplicativos. Vale destacar que este modelo é compatível com o hardware mais recente do Google TPU, especialmente o TPUv5p. Este hardware oferece uma capacidade de computação poderosa, resultando em um treinamento de modelo mais rápido e melhor desempenho, superando em muito as infraestruturas tradicionais baseadas em CPU.

Em termos de software, o gemma-2-2b-jpn-it é treinado usando as estruturas JAX e ML Pathways. O JAX é especialmente otimizado para aplicações de aprendizado de máquina de alto desempenho, enquanto o ML Pathways fornece uma plataforma flexível para organizar todo o processo de treinamento. Essa combinação permite que o Google realize um fluxo de trabalho de treinamento eficiente.

Com o lançamento do gemma-2-2b-jpn-it, seu potencial de aplicação em várias áreas tem recebido ampla atenção. Este modelo pode ser muito útil na criação de conteúdo e comunicação, como gerar poemas, roteiros, códigos, textos de marketing e até mesmo respostas de chatbots. Sua capacidade de geração de texto também é adequada para tarefas de resumo, podendo condensar grandes quantidades de texto em resumos concisos, ideal para pesquisa, educação e exploração do conhecimento.

No entanto, o gemma-2-2b-jpn-it também apresenta algumas limitações que os usuários devem conhecer. O desempenho do modelo depende da diversidade e qualidade de seus dados de treinamento; se os dados contiverem vieses ou lacunas, isso pode afetar as respostas do modelo. Além disso, como os modelos de linguagem de grande porte não possuem um banco de dados embutido, ao lidar com consultas complexas, eles podem gerar declarações de fatos imprecisas ou desatualizadas.

Durante o desenvolvimento, o Google também deu grande importância às considerações éticas, realizando uma avaliação rigorosa do gemma-2-2b-jpn-it para lidar com problemas relacionados à segurança do conteúdo, danos à representatividade e memória dos dados de treinamento. O Google também implementou técnicas de filtragem para excluir conteúdo prejudicial e estabeleceu uma estrutura de transparência e responsabilização, incentivando os desenvolvedores a monitorar continuamente e adotar tecnologias de proteção de privacidade para garantir a conformidade com as leis de privacidade de dados.

Destaques:

🌟 O modelo gemma-2-2b-jpn-it, lançado pelo Google, é otimizado para a língua japonesa, possui 2,61 bilhões de parâmetros e uma arquitetura tecnológica avançada.

💡 Este modelo possui amplo potencial de aplicação em áreas como criação de conteúdo e processamento de linguagem natural, suportando várias tarefas de geração de texto.

🔒 O Google priorizou as considerações éticas no desenvolvimento do modelo, implementando filtragem de conteúdo seguro e medidas de proteção de privacidade para reduzir riscos.