No mundo da IA, os dados são como uma mina de ouro, quanto mais ricos, mais brilhantes. Recentemente, a LLM360 lançou um conjunto de dados impressionante, o TxT360, especialmente projetado para o treinamento de grandes modelos de linguagem. Este gigante não apenas inclui dados de texto de alta qualidade de vários setores, mas também passou por um processo de limpeza global, culminando em 5,7 trilhões de tokens de alta qualidade – uma verdadeira "caixa de ferramentas de dados"!

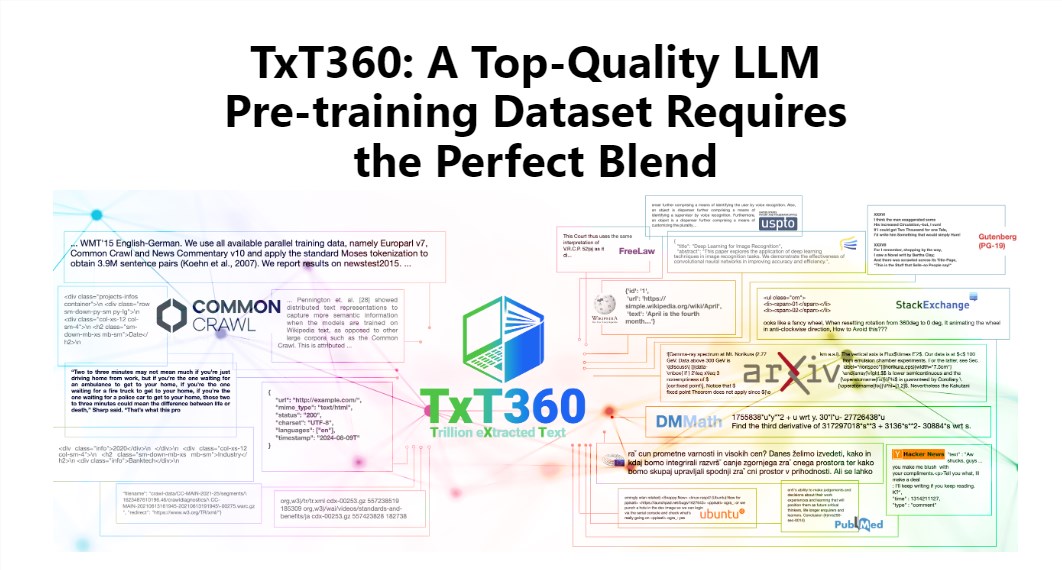

O charme do TxT360 reside em sua escala e qualidade excepcionais, superando conjuntos de dados existentes como FineWeb e RedPajama. Este conjunto de dados extraiu a essência da internet de 99 instantâneos do Common Crawl, e também selecionou cuidadosamente 14 fontes de dados de alta qualidade, como documentos legais e enciclopédias, tornando seu conteúdo não apenas rico e diversificado, mas também confiável.

Ainda mais interessante, o TxT360 oferece aos usuários uma "receita de ajuste de peso de dados", permitindo que você ajuste os pesos das diferentes fontes de dados de acordo com suas necessidades. É como cozinhar: você pode ajustar os ingredientes de acordo com seu paladar, garantindo que cada mordida seja deliciosa.

Claro, a tecnologia de desduplicação também é um destaque do TxT360. Através de operações complexas de desduplicação, este conjunto de dados resolve eficazmente a redundância de dados e a repetição de informações durante o processo de treinamento, garantindo que cada token seja único. Além disso, a equipe do projeto removeu inteligentemente informações de identificação pessoal dos documentos, como endereços de e-mail e IP, usando expressões regulares, garantindo assim a privacidade e a segurança dos dados.

O design do TxT360 não se concentra apenas na escala, mas também na qualidade. Combinando as vantagens de dados da web e fontes de dados selecionadas, permite que os pesquisadores controlem precisamente o uso e a distribuição dos dados, como se tivessem um controle remoto mágico para ajustar as proporções dos dados.

Em termos de eficácia de treinamento, o TxT360 também se destaca. Através de uma simples estratégia de amostragem, o volume de dados aumentou significativamente, criando um conjunto de dados com mais de 15 trilhões de tokens. Em uma série de indicadores-chave de avaliação, o TxT360 superou o FineWeb, especialmente em áreas como MMLU e NQ, demonstrando uma capacidade de aprendizado excepcional. Ao combinar dados de código (como Stack V2), a curva de aprendizado tornou-se mais estável e o desempenho do modelo melhorou significativamente.

Mais informações: https://huggingface.co/spaces/LLM360/TxT360