Modelos de linguagem grandes (LLMs), como a série GPT, com seus vastos conjuntos de dados, demonstram capacidades surpreendentes em compreensão de linguagem, raciocínio e planejamento, atingindo níveis comparáveis aos humanos em diversas tarefas desafiadoras. A maioria das pesquisas se concentra em aprimorar ainda mais esses modelos treinando-os em conjuntos de dados maiores, com o objetivo de desenvolver modelos básicos mais poderosos.

No entanto, embora o treinamento de modelos básicos mais poderosos seja crucial, os pesquisadores acreditam que dotar os modelos da capacidade de evoluir continuamente também na fase de raciocínio, ou seja, a autoevolução da IA, é igualmente crucial para o desenvolvimento da IA. Comparado ao treinamento de modelos usando dados em larga escala, a autoevolução pode exigir apenas dados ou interações limitados.

Inspirados na estrutura colunar do córtex cerebral humano, os pesquisadores hipotetizam que os modelos de IA podem desenvolver capacidades cognitivas emergentes e construir modelos de representação interna por meio de interações iterativas com seu ambiente.

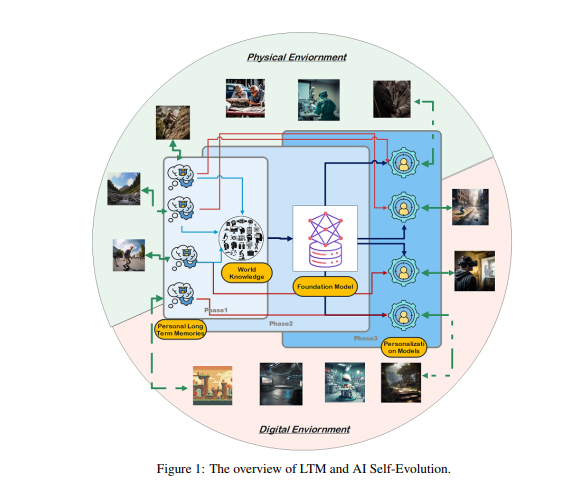

Para atingir esse objetivo, os pesquisadores propõem que os modelos devam possuir memória de longo prazo (LTM), usada para armazenar e gerenciar dados de interação com o mundo real processados. A LTM não apenas pode representar dados individuais de cauda longa em modelos estatísticos, mas também pode promover a autoevolução, apoiando experiências diversas em vários ambientes e agentes.

A LTM é a chave para a autoevolução da IA. Assim como os humanos aprendem e melhoram continuamente por meio de experiências pessoais e interação com o ambiente, a autoevolução dos modelos de IA também depende dos dados da LTM acumulados durante a interação. Diferentemente da evolução humana, a evolução do modelo impulsionada pela LTM não se limita à interação com o mundo real. Os modelos podem interagir com o ambiente físico, como os humanos, e receber feedback direto, que, após o processamento, aumentará suas capacidades; esta é uma área de pesquisa crucial para a IA encarnada.

Por outro lado, os modelos também podem interagir em ambientes virtuais e acumular dados de LTM, o que apresenta custos mais baixos e maior eficiência em comparação com a interação com o mundo real, aumentando assim as capacidades de forma mais eficaz.

A construção da LTM requer a destilação e estruturação de dados brutos. Dados brutos referem-se ao conjunto de todos os dados não processados que o modelo recebe por meio da interação com o ambiente externo ou durante o treinamento. Esses dados contêm várias observações e registros, que podem conter padrões valiosos e uma grande quantidade de informações redundantes ou irrelevantes.

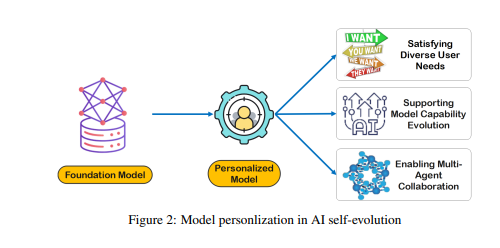

Embora os dados brutos constituam a base da memória e da cognição do modelo, eles precisam ser processados adicionalmente para serem usados eficazmente para personalizar ou executar tarefas de forma eficiente. A LTM destila e estrutura esses dados brutos, permitindo que o modelo os utilize. Esse processo aprimora a capacidade do modelo de fornecer respostas e sugestões personalizadas.

A construção da LTM enfrenta desafios como a esparsidade de dados e a diversidade de usuários. Em sistemas LTM em constante atualização, a esparsidade de dados é um problema comum, especialmente para usuários com histórico de interação limitado ou atividades esparsas, tornando o treinamento do modelo difícil. Além disso, a diversidade de usuários também aumenta a complexidade, exigindo que o modelo se adapte a padrões individuais e generalize efetivamente entre diferentes grupos de usuários.

Os pesquisadores desenvolveram uma estrutura de colaboração multiagente chamada Omne, que implementa a autoevolução da IA com base na LTM. Nesta estrutura, cada agente possui uma estrutura de sistema independente, podendo aprender e armazenar autonomamente um modelo ambiental completo, construindo assim uma compreensão independente do ambiente. Por meio desse desenvolvimento colaborativo baseado em LTM, o sistema de IA pode se adaptar em tempo real às mudanças no comportamento individual, otimizar o planejamento e a execução de tarefas, promovendo ainda mais a autoevolução da IA personalizada e eficiente.

A estrutura Omne alcançou o primeiro lugar no teste de referência GAIA, demonstrando o enorme potencial do uso de LTM para autoevolução da IA e resolução de problemas do mundo real. Os pesquisadores acreditam que o avanço da pesquisa em LTM é crucial para o desenvolvimento contínuo e as aplicações práticas da tecnologia de IA, especialmente no que diz respeito à autoevolução.

Em resumo, a memória de longo prazo é crucial para a autoevolução da IA, permitindo que os modelos de IA aprendam e melhorem com a experiência, como os humanos. A construção e o uso da LTM exigem superar desafios como a esparsidade de dados e a diversidade de usuários. A estrutura Omne oferece uma solução viável para a autoevolução da IA baseada em LTM, e seu sucesso no teste de referência GAIA demonstra o enorme potencial deste campo.

Artigo: https://arxiv.org/pdf/2410.15665