Recentemente, a OpenAI lançou um novo benchmark chamado SimpleQA, projetado para avaliar a precisão factual das respostas geradas por modelos de linguagem.

Com o rápido desenvolvimento de grandes modelos de linguagem, garantir a precisão do conteúdo gerado apresenta muitos desafios, especialmente os chamados fenômenos de “alucinação”, onde o modelo gera informações que soam confiantes, mas são na verdade incorretas ou não verificáveis. Isso é particularmente importante em um contexto onde cada vez mais pessoas dependem da IA para obter informações.

O SimpleQA se destaca por sua ênfase em perguntas curtas e claras, que geralmente têm uma resposta definitiva, facilitando a avaliação da correção da resposta do modelo. Diferentemente de outros benchmarks, as perguntas do SimpleQA são cuidadosamente elaboradas para desafiar até mesmo os modelos mais avançados, como o GPT-4. Este benchmark contém 4326 perguntas, cobrindo várias áreas, incluindo história, ciência, tecnologia, arte e entretenimento, com foco especial na avaliação da precisão e capacidade de calibração do modelo.

O design do SimpleQA segue alguns princípios-chave. Primeiro, cada pergunta tem uma resposta de referência determinada por dois treinadores de IA independentes, garantindo a precisão da resposta.

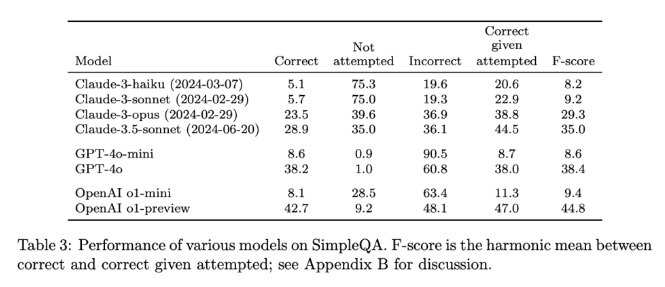

Em segundo lugar, a formulação das perguntas evita ambiguidades; cada pergunta pode ser respondida com uma resposta simples e clara, tornando a pontuação relativamente fácil. Além disso, o SimpleQA usa o classificador ChatGPT para pontuação, marcando explicitamente as respostas como "corretas", "incorretas" ou "não tentadas".

Outra vantagem do SimpleQA é sua abrangência de perguntas diversificadas, evitando a superespecialização do modelo e garantindo uma avaliação abrangente. Este conjunto de dados é fácil de usar, pois as perguntas e respostas são curtas, tornando os testes rápidos e com pouca variação nos resultados. Além disso, o SimpleQA considera a relevância a longo prazo das informações, evitando o impacto de mudanças de informações, tornando-o um benchmark "eterno".

O lançamento do SimpleQA representa um passo importante para impulsionar a confiabilidade das informações geradas por IA. Ele não apenas fornece um benchmark fácil de usar, mas também define um padrão elevado para pesquisadores e desenvolvedores, incentivando-os a criar modelos que não apenas geram linguagem, mas também o fazem com precisão e fidelidade. Por meio do código aberto, o SimpleQA oferece à comunidade de IA uma ferramenta valiosa para melhorar a precisão factual dos modelos de linguagem, garantindo que os sistemas de IA futuros forneçam informações confiáveis.

Entrada do projeto: https://github.com/openai/simple-evals

Página de detalhes: https://openai.com/index/introducing-simpleqa/

Destaques:

📊 SimpleQA é um novo benchmark da OpenAI, focado na avaliação da precisão factual dos modelos de linguagem.

🧠 O benchmark consiste em 4326 perguntas curtas e claras, cobrindo várias áreas para garantir uma avaliação abrangente.

🔍 O SimpleQA ajuda os pesquisadores a identificar e melhorar a capacidade dos modelos de linguagem em gerar conteúdo preciso.