Recentemente, uma equipe de pesquisa lançou uma estrutura chamada HelloMeme, capaz de transferir com alta fidelidade a expressão facial de uma pessoa em uma imagem para outra pessoa em outra imagem.

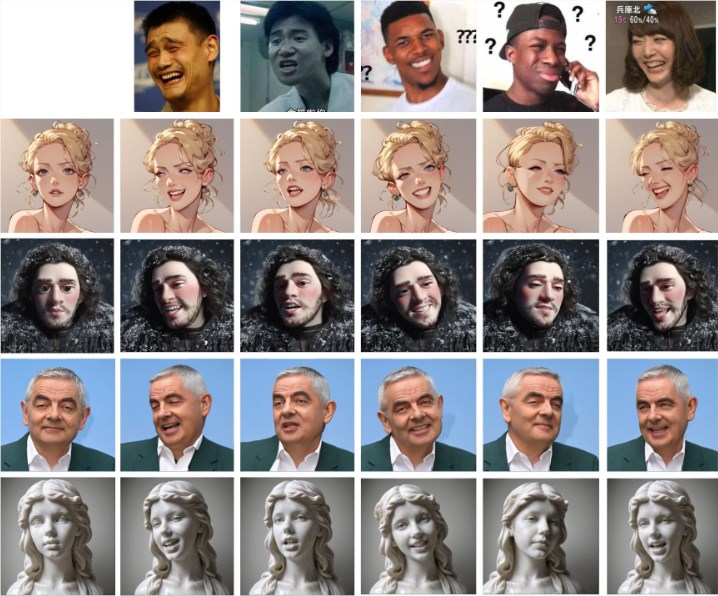

Como mostra a imagem abaixo, fornecendo uma imagem de expressão (primeira linha), é possível transferir os detalhes da expressão para outros personagens em outras imagens.

O núcleo do HelloMeme reside em sua estrutura de rede única. A estrutura consegue extrair as características de cada quadro de um vídeo e inseri-las no HMControlModule. Através desse processamento, os pesquisadores conseguem gerar imagens de vídeo fluidas. No entanto, nos vídeos gerados inicialmente, havia um problema de cintilação entre os quadros, afetando a experiência de visualização. Para resolver isso, a equipe introduziu o módulo Animatediff, uma inovação que melhorou significativamente a continuidade do vídeo, mas também reduziu um pouco a fidelidade da imagem.

Para lidar com essa contradição, os pesquisadores otimizaram e ajustaram ainda mais o módulo Animatediff, conseguindo finalmente melhorar a continuidade do vídeo sem sacrificar muito a qualidade da imagem.

Além disso, a estrutura HelloMeme também oferece suporte robusto para edição de expressões faciais. Ao vincular o ARKit Face Blendshapes, os usuários podem controlar facilmente as expressões faciais dos personagens no vídeo gerado. Essa flexibilidade permite que os criadores gerem vídeos com emoções e expressões específicas, enriquecendo consideravelmente a expressividade do conteúdo de vídeo.

Em termos de compatibilidade técnica, o HelloMeme utiliza um design de adaptador de conexão a quente baseado em SD1.5. A maior vantagem desse design é que ele não afeta a capacidade de generalização do modelo T2I (texto para imagem), permitindo a integração perfeita de qualquer modelo estilizado desenvolvido com base no SD1.5 com o HelloMeme. Isso abre mais possibilidades para diversas criações.

A equipe de pesquisa descobriu que a introdução do HMReferenceModule melhorou significativamente as condições de fidelidade na geração de vídeos, o que significa que é possível gerar vídeos de alta qualidade com menos etapas de amostragem. Essa descoberta não apenas aumenta a eficiência da geração, mas também abre portas para a geração de vídeos em tempo real.

A comparação com outros métodos é apresentada abaixo. É evidente que o efeito de transferência de expressão do HelloMeme é mais natural e próximo ao efeito da expressão original.

Acesso ao projeto: https://songkey.github.io/hellomeme/

https://github.com/HelloVision/ComfyUI_HelloMeme

Destaques:

🌐 O HelloMeme, através de sua estrutura de rede única e do módulo Animatediff, alcança a fluidez na geração de vídeo e alta qualidade de imagem simultaneamente.

🎭 A estrutura suporta ARKit Face Blendshapes, permitindo aos usuários controlar flexivelmente as expressões faciais dos personagens, enriquecendo a expressividade do conteúdo do vídeo.

⚙️ Utiliza um design de adaptador de conexão a quente, garantindo compatibilidade com outros modelos baseados em SD1.5, oferecendo maior flexibilidade para criação.