No campo da inteligência artificial, maior escala parece significar maior capacidade. Na busca por modelos de linguagem mais poderosos, grandes empresas de tecnologia têm empilhado descontroladamente parâmetros de modelos e dados de treinamento, resultando em custos exponencialmente maiores. Mas não haveria um método econômico e eficiente para treinar modelos de linguagem?

Pesquisadores da Universidade de Harvard e da Universidade de Stanford publicaram recentemente um artigo onde descobriram que a precisão (precision) do treinamento do modelo é como uma chave escondida que pode desbloquear o "código de custo" do treinamento de modelos de linguagem.

O que é precisão do modelo? Simplificando, refere-se ao número de bits usados nos parâmetros do modelo e nos cálculos. Modelos de aprendizado profundo tradicionais geralmente usam números de ponto flutuante de 32 bits (FP32) para treinamento, mas, recentemente, com o desenvolvimento de hardware, tornou-se possível usar tipos numéricos de menor precisão, como números de ponto flutuante de 16 bits (FP16) ou inteiros de 8 bits (INT8).

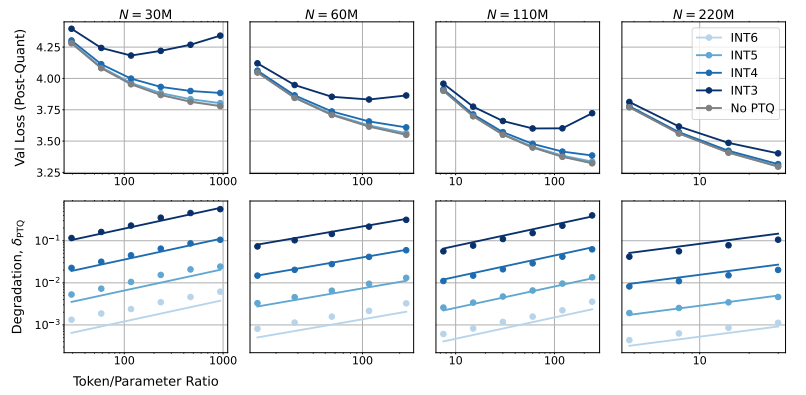

Então, como a redução da precisão do modelo afeta o desempenho do modelo? Esta é a questão que este artigo busca investigar. Os pesquisadores, através de inúmeros experimentos, analisaram as mudanças de custo e desempenho do treinamento e inferência do modelo em diferentes precisões e propuseram uma nova lei de escala "consciente de precisão".

Eles descobriram que o uso de menor precisão para treinamento pode reduzir efetivamente o "número efetivo de parâmetros" do modelo, reduzindo assim a quantidade de computação necessária para o treinamento. Isso significa que, com o mesmo orçamento computacional, podemos treinar modelos de maior escala ou, com a mesma escala, podemos economizar muitos recursos computacionais usando menor precisão.

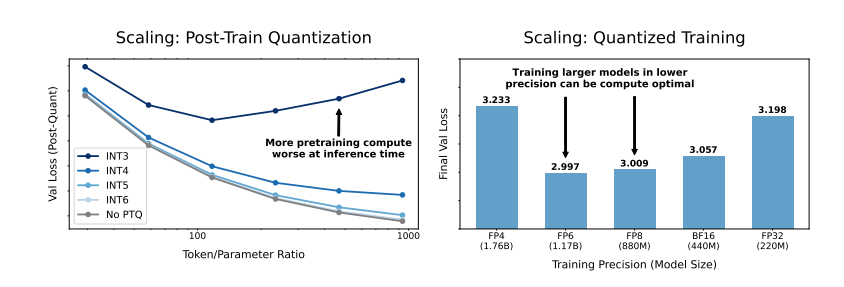

Mais surpreendentemente, os pesquisadores também descobriram que, em alguns casos, o uso de menor precisão para treinamento pode até melhorar o desempenho do modelo! Por exemplo, para modelos que precisam de "quantização pós-treinamento" (post-training quantization), se uma precisão menor for usada na fase de treinamento, o modelo será mais robusto à redução de precisão após a quantização, resultando em melhor desempenho na fase de inferência.

Então, qual precisão devemos escolher para treinar o modelo? Os pesquisadores, analisando sua lei de escala, chegaram a algumas conclusões interessantes:

O treinamento tradicional de 16 bits pode não ser a melhor escolha. Sua pesquisa sugere que a precisão de 7-8 bits pode ser uma escolha mais econômica e eficiente.

Perseguir o treinamento de precisão extremamente baixa (como 4 bits) também não é sábio. Porque, em precisão muito baixa, o número efetivo de parâmetros do modelo diminui drasticamente, e para manter o desempenho, precisamos aumentar significativamente o tamanho do modelo, o que leva a custos computacionais mais altos.

A melhor precisão de treinamento pode variar para modelos de diferentes escalas. Para modelos que precisam de muito "treinamento excessivo" (overtraining), como as séries Llama-3 e Gemma-2, o uso de maior precisão para treinamento pode ser mais econômico e eficiente.

Esta pesquisa fornece uma nova perspectiva para entender e otimizar o treinamento de modelos de linguagem. Ela nos diz que a escolha da precisão não é imutável, mas deve ser ponderada de acordo com o tamanho específico do modelo, a quantidade de dados de treinamento e o cenário de aplicação.

Claro, esta pesquisa também tem algumas limitações. Por exemplo, a escala dos modelos usados é relativamente pequena, e os resultados experimentais podem não ser diretamente generalizados para modelos de maior escala. Além disso, eles só se concentraram na função de perda do modelo e não avaliaram o desempenho do modelo em tarefas a jusante.

Apesar disso, esta pesquisa ainda é muito significativa. Ela revela a complexa relação entre a precisão do modelo, o desempenho do modelo e o custo de treinamento, e fornece insights valiosos para o projeto e treinamento de modelos de linguagem mais poderosos e econômicos no futuro.

Artigo: https://arxiv.org/pdf/2411.04330