Uma pesquisa recente demonstra que modelos de IA generativa, especialmente os grandes modelos de linguagem (LLMs), podem construir uma arquitetura capaz de simular com precisão o comportamento humano em diversos contextos. Esta descoberta oferece uma poderosa nova ferramenta para pesquisas em ciências sociais.

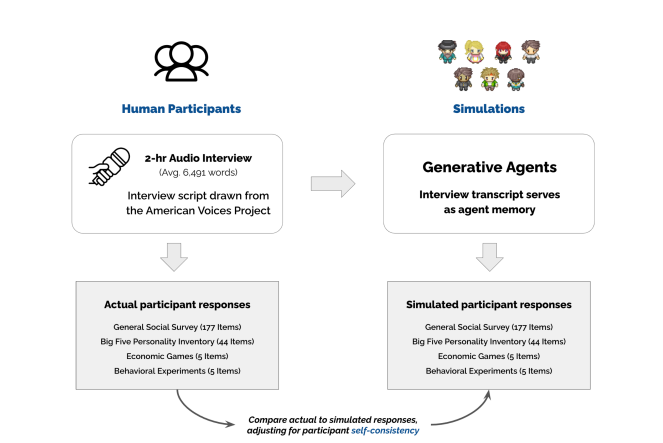

Os pesquisadores começaram recrutando mais de 1000 participantes de diferentes origens nos Estados Unidos, conduzindo entrevistas profundas de duas horas para coletar informações sobre suas experiências de vida, opiniões e valores. Em seguida, usaram esses registros de entrevistas e um grande modelo de linguagem para construir uma "arquitetura de agentes generativa".

Essa arquitetura consegue criar milhares de "clones" virtuais com base nas entrevistas dos participantes, cada um com personalidade e padrões de comportamento únicos. Os pesquisadores avaliaram o desempenho desses "clones" através de uma série de testes padrão de ciências sociais, como o "Big Five Personality Test" e jogos de economia comportamental.

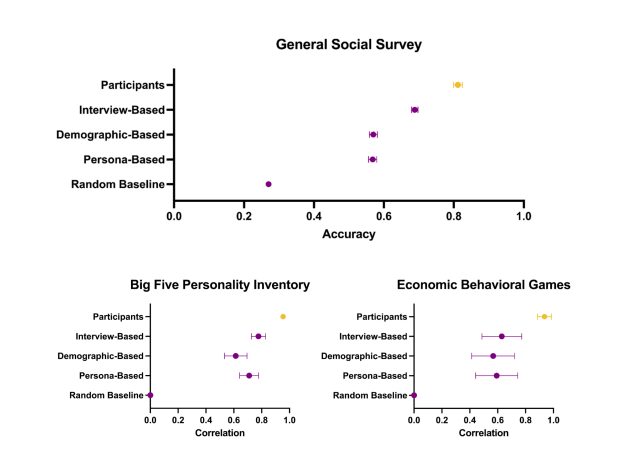

Surpreendentemente, o desempenho desses "clones" nos testes foi altamente consistente com o dos participantes reais. Não apenas conseguiram prever com precisão suas respostas em questionários, mas também suas reações comportamentais em experimentos. Por exemplo, em um experimento sobre como o poder afeta a confiança, o desempenho dos "clones" espelhou o dos participantes reais, com o grupo de alto poder demonstrando níveis de confiança significativamente mais baixos que o grupo de baixo poder.

Esta pesquisa demonstra que modelos de IA generativa podem ser usados para criar "humanos virtuais" altamente realistas e prever o comportamento humano real. Isso oferece um método totalmente novo para pesquisas em ciências sociais. Por exemplo, esses "humanos virtuais" podem ser usados para testar a eficácia de novas políticas de saúde pública ou estratégias de marketing sem a necessidade de experimentos em larga escala com pessoas reais.

Os pesquisadores também descobriram que depender apenas de informações demográficas para construir "humanos virtuais" é insuficiente. Somente a combinação com o conteúdo das entrevistas profundas permite simular com mais precisão o comportamento individual. Isso indica que cada indivíduo possui experiências e opiniões únicas, informações cruciais para compreender e prever seu comportamento.

Para proteger a privacidade dos participantes, os pesquisadores planejam criar um "banco de agentes" com dois tipos de acesso: acesso aberto a dados agregados para tarefas fixas e acesso restrito a dados individuais para tarefas abertas. Isso permite que os pesquisadores utilizem esses "humanos virtuais" enquanto minimiza os riscos associados ao conteúdo das entrevistas.

Esta pesquisa, sem dúvida, abre novas portas para as pesquisas em ciências sociais. Quais serão os impactos a longo prazo? Só o tempo dirá.

Endereço do artigo: https://arxiv.org/pdf/2411.10109