O Meta lançou recentemente um novo benchmark, chamado Multi-IF, projetado para avaliar a capacidade de seguir instruções de modelos de linguagem grandes (LLMs) em conversas de várias rodadas e ambientes multilíngues. Este benchmark abrange oito idiomas, incluindo 4501 tarefas de conversa de três rodadas, focando no desempenho dos modelos atuais em cenários complexos de várias rodadas e multilínguas.

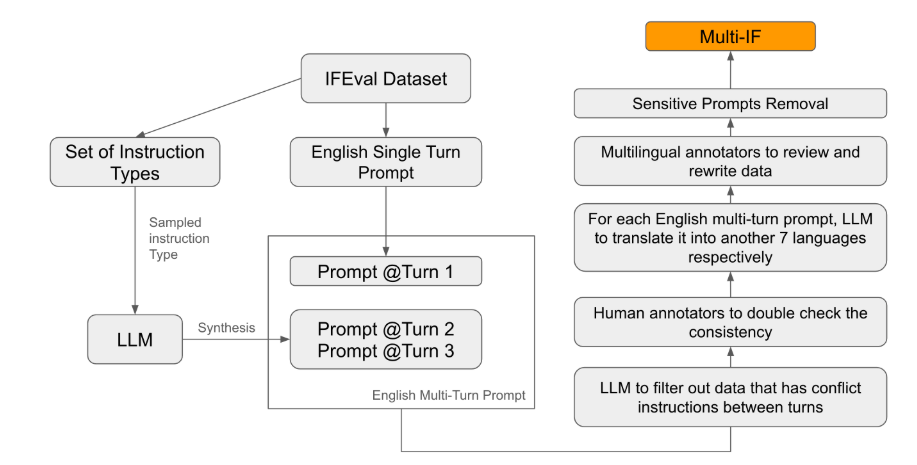

Na maioria dos padrões de avaliação existentes, a ênfase está em conversas de uma rodada e tarefas monolínguas, o que dificulta a reflexão completa do desempenho do modelo em aplicações reais. O lançamento do Multi-IF visa preencher essa lacuna. A equipe de pesquisa gerou cenários de conversa complexos, expandindo instruções de uma rodada para várias rodadas, garantindo a coerência e a progressão lógica de cada rodada de instruções. Além disso, o conjunto de dados alcançou suporte multilíngue por meio de tradução automática e revisão humana.

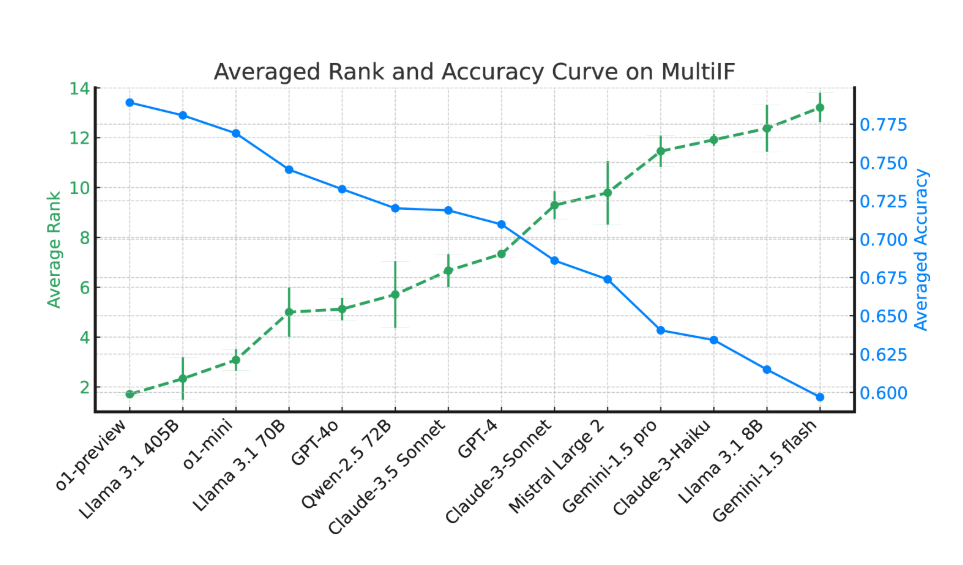

Os resultados experimentais mostram que a maioria dos LLMs apresenta uma queda significativa no desempenho em conversas de várias rodadas. Tomando o modelo o1-preview como exemplo, sua precisão média na primeira rodada é de 87,7%, mas cai para 70,7% na terceira rodada. Em particular, em idiomas não latinos, como hindi, russo e chinês, o desempenho do modelo é geralmente inferior ao do inglês, mostrando suas limitações em tarefas multilíngues.

Na avaliação de 14 modelos de linguagem de ponta, o o1-preview e o Llama3.1405B apresentaram os melhores resultados, com precisão média de 78,9% e 78,1%, respectivamente, em instruções de três rodadas. No entanto, em conversas de várias rodadas, a capacidade de seguir instruções de todos os modelos diminuiu geralmente, refletindo os desafios dos modelos em tarefas complexas. A equipe de pesquisa também introduziu a "taxa de esquecimento de instruções" (IFR) para quantificar o fenômeno de esquecimento de instruções em conversas de várias rodadas, mostrando que modelos de alto desempenho se saíram relativamente melhor nesse aspecto.

O lançamento do Multi-IF fornece aos pesquisadores um benchmark desafiador, impulsionando o desenvolvimento de LLMs em aplicações globais e multilíngues. O lançamento deste benchmark não apenas revela as deficiências dos modelos atuais em tarefas de várias rodadas e multilínguas, mas também fornece uma direção clara para melhorias futuras.

Artigo:https://arxiv.org/html/2410.15553v2

Destaques:

🌍 O benchmark Multi-IF abrange oito idiomas, incluindo 4501 tarefas de conversa de três rodadas, avaliando o desempenho de LLMs em cenários complexos.

📉 Os experimentos mostram que a precisão da maioria dos LLMs diminui significativamente em conversas de várias rodadas, especialmente em idiomas não latinos.

🔍 Os modelos o1-preview e Llama3.1405B apresentaram os melhores resultados, com precisão média de 78,9% e 78,1%, respectivamente, em instruções de três rodadas.