Já ouviu falar do ChatGPT, Wenxin Yiyan e outras IAs sofisticadas? A tecnologia central por trás delas são os “Modelos de Linguagem Grandes” (LLMs). Parece complicado e difícil de entender? Não se preocupe, mesmo que você tenha apenas o nível de matemática do segundo ano do ensino fundamental, depois de ler este artigo, você poderá entender facilmente o princípio de funcionamento do LLM!

Redes Neurais: A Magia dos Números

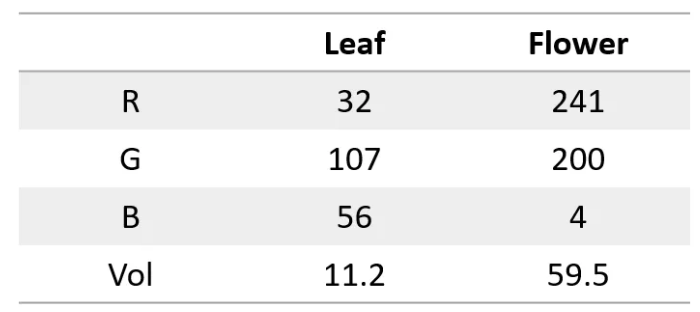

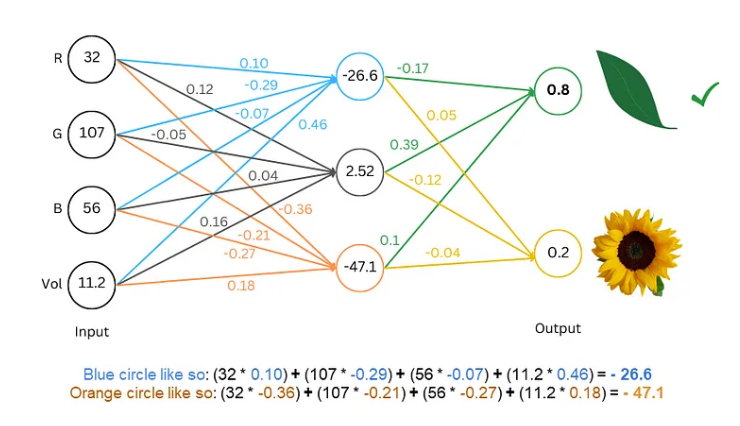

Primeiro, precisamos saber que uma rede neural é como uma supercalculadora que só pode processar números. Tanto a entrada quanto a saída devem ser números. Então, como fazemos para que ela entenda texto?

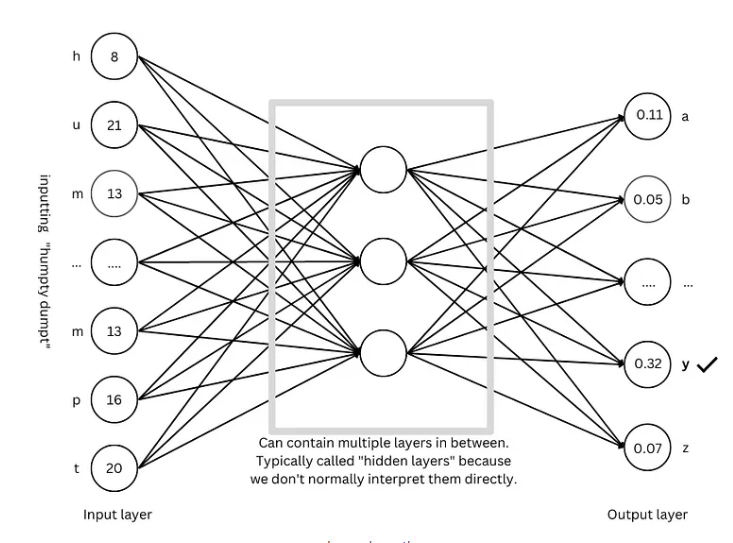

O segredo está em converter o texto em números! Por exemplo, podemos representar cada letra por um número, como a=1, b=2, e assim por diante. Dessa forma, a rede neural pode “ler” o texto.

Treinamento do Modelo: Fazendo a Rede “Aprender” a Linguagem

Com o texto digitalizado, o próximo passo é treinar o modelo, fazendo a rede neural “aprender” as regras da linguagem.

O processo de treinamento é como um jogo de adivinhação. Mostramos à rede alguns textos, como “Humpty Dumpty”, e a pedimos para adivinhar qual é a próxima letra. Se ela acertar, a recompensamos; se errar, a penalizamos. Através de adivinhações e ajustes contínuos, a rede pode prever a próxima letra com cada vez mais precisão, gerando finalmente frases completas, como “Humpty Dumpty sat on a wall”.

Técnicas Avançadas: Tornando o Modelo Mais “Inteligente”

Para tornar o modelo mais “inteligente”, os pesquisadores inventaram muitas técnicas avançadas, como:

Embeddings de palavras: Não usamos mais números simples para representar letras, mas sim um conjunto de números (vetores) para representar cada palavra, o que permite descrever o significado das palavras de forma mais abrangente.

Tokenizadores de subpalavras: Dividir palavras em unidades menores (subpalavras), como dividir “cats” em “cat” e “s”, reduzindo o vocabulário e aumentando a eficiência.

Mecanismo de autoatenção: Ao prever a próxima palavra, o modelo ajusta o peso da previsão com base em todas as palavras do contexto, assim como nós, ao ler, entendemos o significado das palavras com base no contexto.

Conexões residuais: Para evitar que o número excessivo de camadas da rede dificulte o treinamento, os pesquisadores inventaram as conexões residuais, tornando o aprendizado mais fácil para a rede.

Mecanismo de atenção multi-cabeça: Executando vários mecanismos de atenção em paralelo, o modelo pode entender o contexto de diferentes ângulos, melhorando a precisão da previsão.

Codificação posicional: Para que o modelo entenda a ordem das palavras, adicionamos informações posicionais aos embeddings das palavras, assim como nós, ao ler, prestamos atenção na ordem das palavras.

Arquitetura GPT: A “Planta” dos Modelos de Linguagem Grandes

A arquitetura GPT é uma das arquiteturas de modelos de linguagem grandes mais populares atualmente, como uma “planta”, guiando o design e o treinamento do modelo. A arquitetura GPT combina habilmente as várias técnicas avançadas mencionadas acima, permitindo que o modelo aprenda e gere linguagem de forma eficiente.

Arquitetura Transformer: A “Revolução” dos Modelos de Linguagem

A arquitetura Transformer é um grande avanço recente no campo dos modelos de linguagem. Ela não apenas melhorou a precisão da previsão, mas também reduziu a dificuldade de treinamento, lançando as bases para o desenvolvimento de modelos de linguagem grandes. A arquitetura GPT também evoluiu a partir da arquitetura Transformer.

Referências: https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876